ローカル5Gを用いた無人搬送車の遠隔制御

1.実証実験の背景

2023年現在,第五世代移動通信(5G : 5th Generation)の商用サービスが世界中で開始されている.5Gの総加入契約数は2023年第1四半期に11億に達している.さらに,5Gの加入契約数は,2028年末までに世界の46億に達し,全モバイル加入契約数の50%以上を占めると予測 されている[1].

また,携帯通信事業者が運用する公衆網に加え,携帯通信事業者以外が自身の施設内に専用のネットワークを構築するローカル(プライベート)5Gといった自営システムが注目されている.自営ネットワークとして広く普及しているWi-Fiと比較して,ローカル5Gシステムでは安全で柔軟なネットワークを提供することができる.さらに,施設内(工場,農地,ビルなど)の広範囲をカバーすることが可能となるため,製造業などでは有望な選択肢の1つとなっており,さまざまな分野での応用が期待されている.日本では,5Gの実現による新たな市場の創出に向けて,さまざまな利活用分野の関係者が参加する5G総合実証試験が2017年度から2020年度の3年間,総務省の主導により全国各地で行われてきた[2].またローカル5Gに関しても,ローカル5Gのより柔軟な運用の実現および低廉かつ安心安全なローカル5Gの利活用の実現に向け,現実のさまざまな利用場面を想定した多種多様な利用環境下において電波伝搬等に関する技術的検討を実施するとともに,ローカル5G等を活用したソリューションを創出する“課題解決型ローカル5G等の実現に向けた開発実証”を実施している[3].

我々は,ロボットの遠隔制御にローカル5Gを用いる構成を含む複数の構成を対象として実証実験を行った.具体的には,ロボットによる遠隔監視,高精細映像で大学キャンパスを見守る実験,トライアスロン大会のバイク競技をVR(Virtual Reality)観戦する実験である.本稿では,特にロボットの遠隔制御を中心としてシステム構成,デモ構成を示した後,デモを行った際の所感について述べる.また,本稿のロボットの遠隔制御の構成に関しては主に文献[4]に基づいており,デモ構成更新の理由,所感を追加している.また遠隔監視等のデモを追加している点が異なる.まず,第2章で本稿で用いたシステム概要について説明する.その後,第3章で香川大学で実施した実証実験・デモについて,第4章でその他の実証実験について説明する.最後に第5章で実証実験から得た知見について述べる.

2.システム概要

本章では,システムの概要について示す.2.1節でロボット向けのメタ・オペレーティングシステムであるRobot Operating System(ROS)[5]について,2.2節でローカル5Gについて述べた後,本稿における遠隔制御システムの構成について詳細を説明する.

2.1 ROS概要

ここでは,本稿において無人搬送車(UGV : Unmanned Ground Vehicle)の制御に使用するROSの概要について簡単に説明する.ROSはオープンソースで提供されるロボット向けのメタ・オペレーティングシステムである.ハードウェア抽象化, 低レベルなデバイス制御, 一般的な機能性, プロセス間通信, そして, パッケージ管理など, 一般的なオペレーティングシステムに要求されるサービスを提供する. また, コードを複数台のコンピュータにわたって保持・ビルド・記述・実行するためのツールやライブラリも提供している.ROSは,無人搬送車やドローン,ロボットアームなど幅広いロボットの制御に使用されている.また,ロボットの制御に必要となるさまざまな要素技術がオープンソースソフトウェアとして開発・公開されている.ロボットの制御では,分散処理が基本となっており,ROSでも分散処理が適用される.たとえば,測域センサのスキャンデータを取得する処理や,ロボットの位置を推定する処理,ロボットに移動指示を行う処理などを組み合わせることで,用途に応じたロボットを作成可能となる.

また,ROSではノードと呼ばれる計算を実行するプロセスが定義されている.このノードは,ROSクライアントライブラリを用いて,C++もしくはPythonによって記述され,並列・独立に動作する.

このノード間は,データの送受信をすることができ,このデータをメッセージと呼ぶ.このメッセージは,整数型,浮動小数点型等の一般的な型に加え,画像,慣性計測装置の測定値といったセンサでよく用いられるデータ型が定義されている[6].

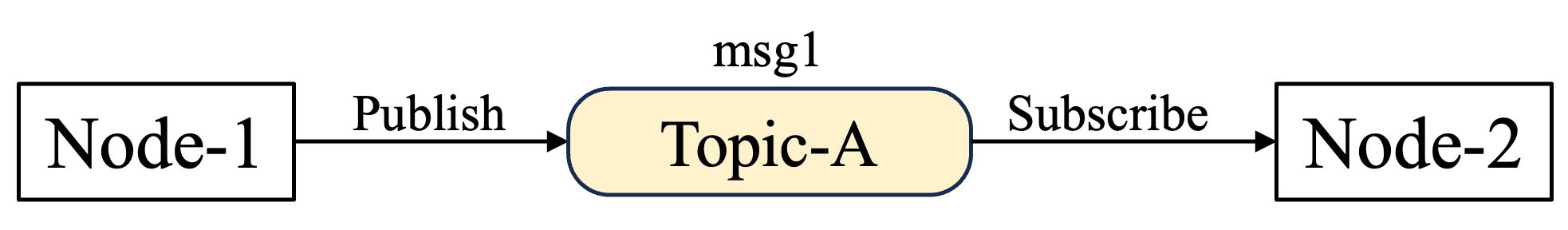

このメッセージを用いた通信方式として,トピック通信,サービス通信,アクション通信があるが,最もよく用いられる単方向非同期通信であるPublish/Subscribe方式を用いるトピック通信について説明する.この通信では,一方のノードは,メッセージにトピック名をつけて配信(Publish)する.他方のノードは,このトピックを購読(Subscribe)することでメッセージを受信する.このトピックは複数のノードで購読可能である.また,2つのノードは通信相手の情報を知る必要はなく,トピックの配信/購読のみを行うため,新たにプログラムを追加する場合や,削除する場合においても容易にシステムを変更可能となる.図1にNode-1がメッセージmsg1にTopic-Aというトピック名をつけて配信し,Node-2がTopic-Aを購読する場合を示す.図1(a)に正確な表記を示す.本稿では,より簡単に記載するため,トピック名を省略して図1(b)のように記載する.

図1 トピック通信の概念図

以上述べたように,ROSは複雑なロボットシステムを制御可能であり,世界中の研究者や開発者が作成した豊富なライブラリやツールを使用することでロボット制御システムの作成作業を簡素化・効率化することができる.

ROSのライブラリやプログラム等は,パッケージという単位で管理されており,ユーザは使用したい機能を持つパッケージをインターネットから入手することで,容易にロボットに組み込むことができる.

2.2 ローカル5G概要

ローカル5Gについて説明する前に,第五世代移動通信システム(5G : 5th Generation)について簡単に説明する.2Gでデジタル通信が導入されて以降,移動通信システムでは,高速大容量化が進められてきた.5Gでは,あらゆるモノ・人などが繋がる新たなコミュニケーションツールとしての役割を果たすため,図2に示すように,高速大容量(eMBB : Enhanced Mobile Broadband)に加え,低遅延(URLLC : Ultra-reliable and Low Latency Communications),多数同時接続(mMTC : Massive Machine Type Communications)といった新たな2つのシナリオをサポートする[7].“低遅延”シナリオでは,通信ネットワークにおける遅延,すなわちタイムラグをきわめて小さく抑えることが求められる.たとえば,自動車の自動運転のように高い安全性が求められるものにおいては,リアルタイムでの通信が必要である.また,ロボットの遠隔制御や遠隔医療といった分野においても超低遅延の効果が期待できる.たとえば,本シナリオの特定の条件では無線区間で1ミリ秒の遅延が実現可能である.また,“多数同時接続”シナリオでは,基地局1台から同時に接続できる端末を従来に比べて飛躍的に増加させる[8].

![図2 5G(IMT-2020)の3つのシナリオ([7]のFigure 2より引用)](DP6505-S04/image/image02.jpg)

5Gは,新たな2つのシナリオをサポートすることから,さまざまな事業分野における新ビジネスの創出に加え,地域が抱えるさまざまな社会課題を解決する手段として大きく期待されている.このため,携帯電話事業者による全国向けサービスとは別に,さまざまな主体が柔軟に構築・利用可能な新しい移動通信システムとして,ローカル5Gが導入された.このローカル5Gは,地域の企業や自治体等のさまざまな主体が,自らの建物内や敷地内でスポット的に柔軟に構築できる5Gシステムのことである.28.2から28.3GHzの100MHz幅で2019年に先行して制度化され,4.6から4.9GHzおよび,28.3から29.1GHzの周波数帯は,2020年7月に情報通信審議会において技術的条件が取りまとめられ,2020年12月に制度化された[9].

ローカル5Gは携帯電話事業者の5Gサービスと異なり(1)携帯事業者によるエリア展開が遅れる地域において5Gシステムを先行して構築可能である点,(2)使用用途に応じて必要となる性能を柔軟に設定可能である点,(3)他の場所の通信障害や災害などの影響を受けにくい点といった特徴がある.また,Wi-Fiと比較して,無線局免許に基づく安定的な利用が可能であるという特徴がある[10].

このローカル5Gの運用に関して,本実験では非同期運用の目的である端末から基地局への送信(上りリンク)の速度増大・低遅延を実現しつつ,携帯電話事業者の5Gサービスといった同期運用をしている基地局からの信号を保護できる準同期運用を用いた[11].

2.3 遠隔制御システム構成

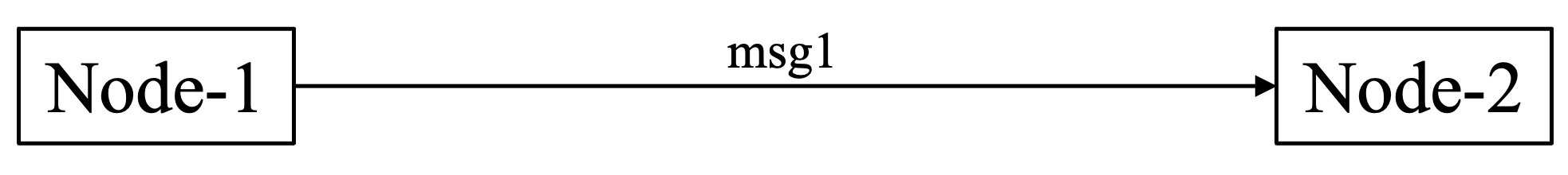

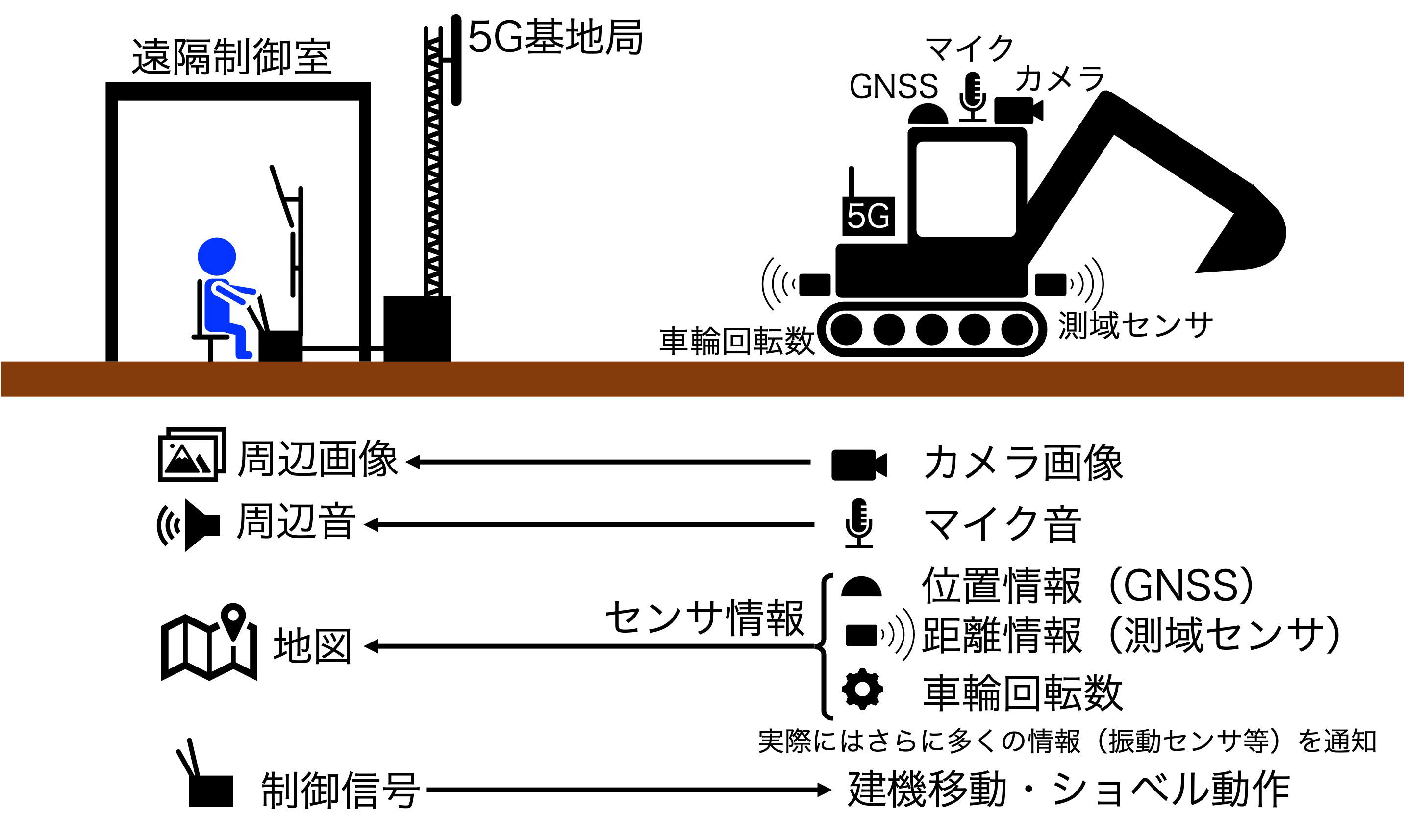

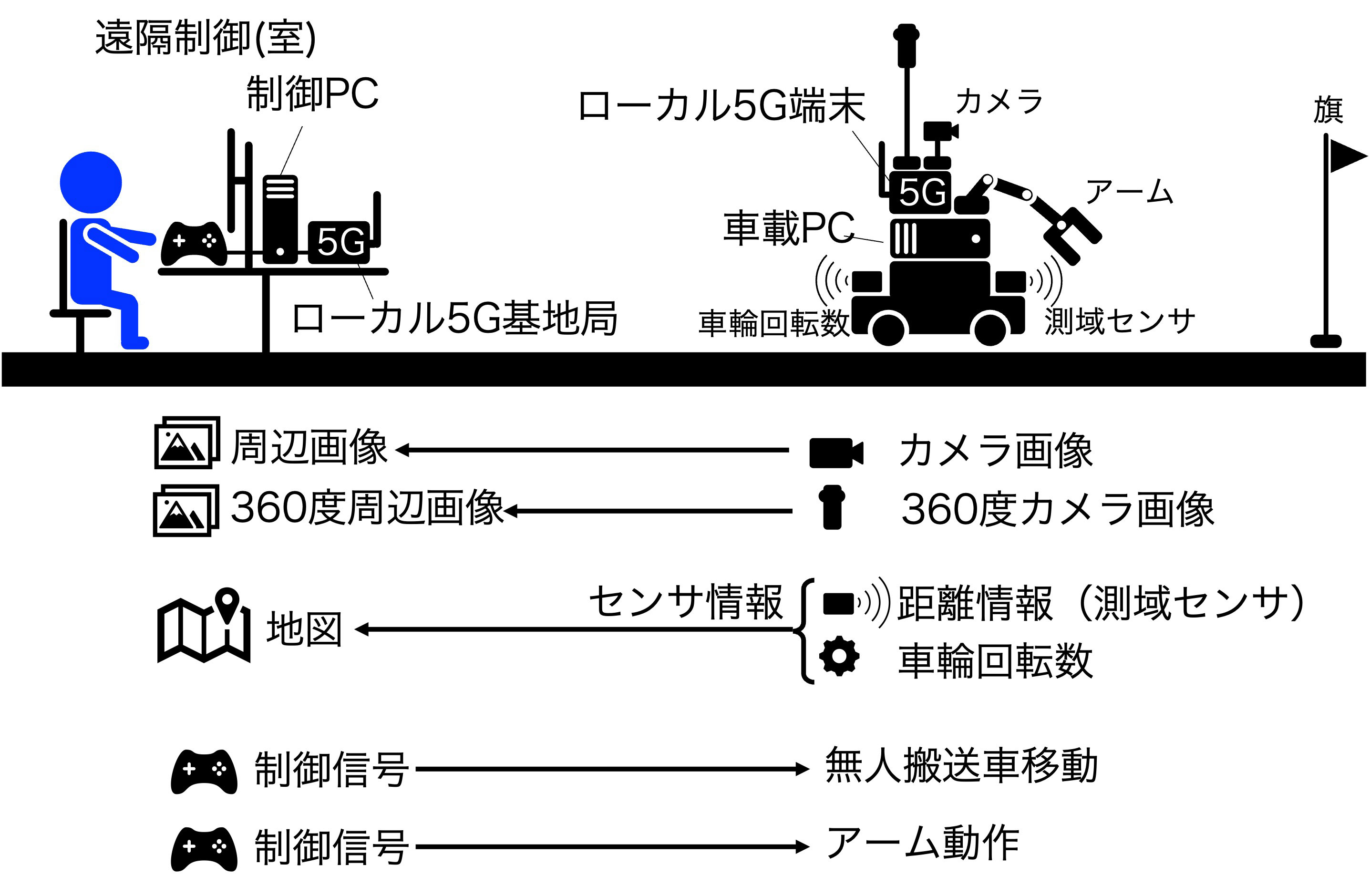

本稿では,建設現場の建機を使った大規模な実証実験[12],[13],[14]を小規模化した遠隔制御システムを構築した.図3(a)に建設現場の建機を遠隔制御する場合の模式図を示す.建機の遠隔制御では,建機に設置されたカメラ(360度カメラも含む)の周辺画像,マイクで収音した周辺音を遠隔操縦室に5Gシステムで伝送する.また,さまざまなセンサ情報も同様に5Gシステムで伝送する.具体的には,全地球航法衛星システム(GNSS : Global Navigation Satellite System)で取得した位置情報,測域センサで得られた距離情報,建機の車輪回転数に加え,エンジン回転数等の建機の状態を示す信号,振動センサ,危険防止のため人を検知するための補足カメラ情報,トンネル工事などにおける可燃性ガスの検出用センサなどがある.これらの情報を遠隔制御室では画像・地図・音声・振動として再現し,これらを元に操縦者がハンドル・レバー・ボタンなどで操作する.この制御信号が5Gシステムで建機に伝送され,建機が動作する.図3(b)に本稿で作成した遠隔制御デモ構成の模式図を示す.また,図4に遠隔制御デモ構成の外観を示す.遠隔制御側の操縦者は,ディスプレイに表示された情報を元に,2つのコントロールパッドを用いて操縦する.これらは,ROSをインストールしたPC(本稿では制御PCと呼ぶ)に接続されており,さらに制御PCはローカル5G基地局に接続されている.離れた場所にある無人搬送車[15]にはローカル5G端末が搭載されており,ローカル5G端末は無人搬送車に搭載されたPC(本稿では車載PCと呼び,制御PCと同様にROSがインストールされている)に接続されている.またこのPCは無人搬送車の四輪を制御するマイコンVS-WRC051,ロボットアーム,Webカム,360度カメラに接続されている.建機の場合と同様に,カメラの周辺画像,測域センサと車輪の回転数を遠隔操縦室にローカル5Gシステムで伝送する.また操縦者が操作する2台のコントロールパッドの制御信号を元に無人搬送車,ロボットアームが動作する.この詳細については,ローカル5Gの諸元を説明した後,詳細な処理を含めて説明する.

図3 本稿で作成した遠隔制御デモ構成

![図4 遠隔制御デモ構成の外観[4]](DP6505-S04/image/image04_a.jpg)

![図4 遠隔制御デモ構成の外観[4]](DP6505-S04/image/image04_b.jpg)

図4 遠隔制御デモ構成の外観[4]

次に,本稿で用いるローカル5Gについて示す.本稿では,(株)エイビットのAU-510[16]を用いた.キャリア周波数は4.8499GHz,システム帯域幅は100MHzである.サブキャリア間隔は30kHzであり,システム帯域幅内に264リソースブロックが配置されている.端末から基地局への送信(上りリンク)と基地局から端末への送信(下リンク)を同一周波数を用いる時分割複信方式(TDD : Time Division Duplex)を適用した.また準同期システムを採用しており,図では省略しているがGNSSを用いることで送信タイミングを決定している.

次に図5に,本デモ装置の制御をROSのパッケージ,メッセージの形で示す.図において,パッケージ名を四角で表し,矢印でメッセージの配信方向を示す.矢印の上にメッセージの内容を示している.まず,無人搬送車から制御側へのデータの流れについて説明する.無人搬送車の四輪のモータに接続されたモータエンコーダから得られた回転数を元に,車載PCはオドメトリ情報を取得する.ここでオドメトリとは位置,進行方向,速度を含んでいる.また,本稿では距離4m,240度の範囲で障害物までの距離を測定可能な測域センサ[17]を2台用いた.具体的には,無人搬送車の前後に2台の測域センサを設置し,進行を0度とした場合,-120度(240度)から120度の方向,60度から300度の方向に対して,障害物までの距離を測定し,スキャンデータとして車載PCに出力する.車載PCは,この2スキャンデータからira_laser_toolsパッケージ[18]を用いて,全方向の合成スキャンデータを得る.車載PCはオドメトリと合成スキャンデータをローカル5Gを経由,制御PCに送信する.制御PCでは,オドメトリと合成スキャンデータを用いて,slam_gmappingパッケージ[19]を用いて,Simultaneous Localization and Mapping(SLAM)アルゴリズム[20]を適用する.その結果をrvizパッケージ[21]を用いて制御PCに接続されたPCに表示する.

![図5 本装置の制御構成[4] (a)上りリンク(無人搬送車から操縦席)の制御](DP6505-S04/image/image05_a.jpg)

![図5 本装置の制御構成[4] (b)下りリンク(操縦席から無人搬送車)の制御](DP6505-S04/image/image05_b.jpg)

図5 本装置の制御構成[4]

さらに,操縦者に無人搬送車周辺の画像情報を提供するために2種類のカメラを設置している.USBビデオクラス(UVC)対応のWebカム[22]に対して,libuvc_cameraパッケージ[23]を用いて,所望の画質(1280 × 720, 30fps)の動画を生成する.その出力に対して,image_transportパッケージ[24]を用いて,jpegフォーマットに圧縮してローカル5Gを経由して制御PCに送信する.制御PCではrvizパッケージで表示する.Webカムに加え,360度カメラであるTHETA Z1も無人搬送車に搭載した.THETA Z1は,全画角180度を超える小型の魚眼レンズ2つが背中あわせに配置されており,これにより360度すべての方向からの光を一度に取り込むことが可能である.しかしながら,この処理時間に起因して,Webカムよりも画像伝送遅延が増大する.また,THETA Z1はさまざまな開発ツールが提供されており,libuvc_thetaライブラリを用いて正距円筒(エクイレクタングラ)図法の全天球動画を生成する.この動画をgscamパッケージ[25]を用いてローカル5Gを経由して制御PCに送信する.制御PCではrvizパッケージでWebカムと同様に表示する.WebカムとTHETA Z1で伝送方法が異なるのは,本構成の方がTHETA Z1の遅延を大きく低減できるためである.本デモシステムでは,ソフトエンコーディング・デコーディングを用いており,送受信側に設置されたPCの性能,画像伝送の画質などによって遅延特性が変動する.これらを変化させたときの遅延特性を評価し,特定の条件であれば画像伝送遅延100ms程度,Full HD(1920 × 1080)画質を伝送した場合でも300ms以下の遅延時間を実現可能であることを示している[4].

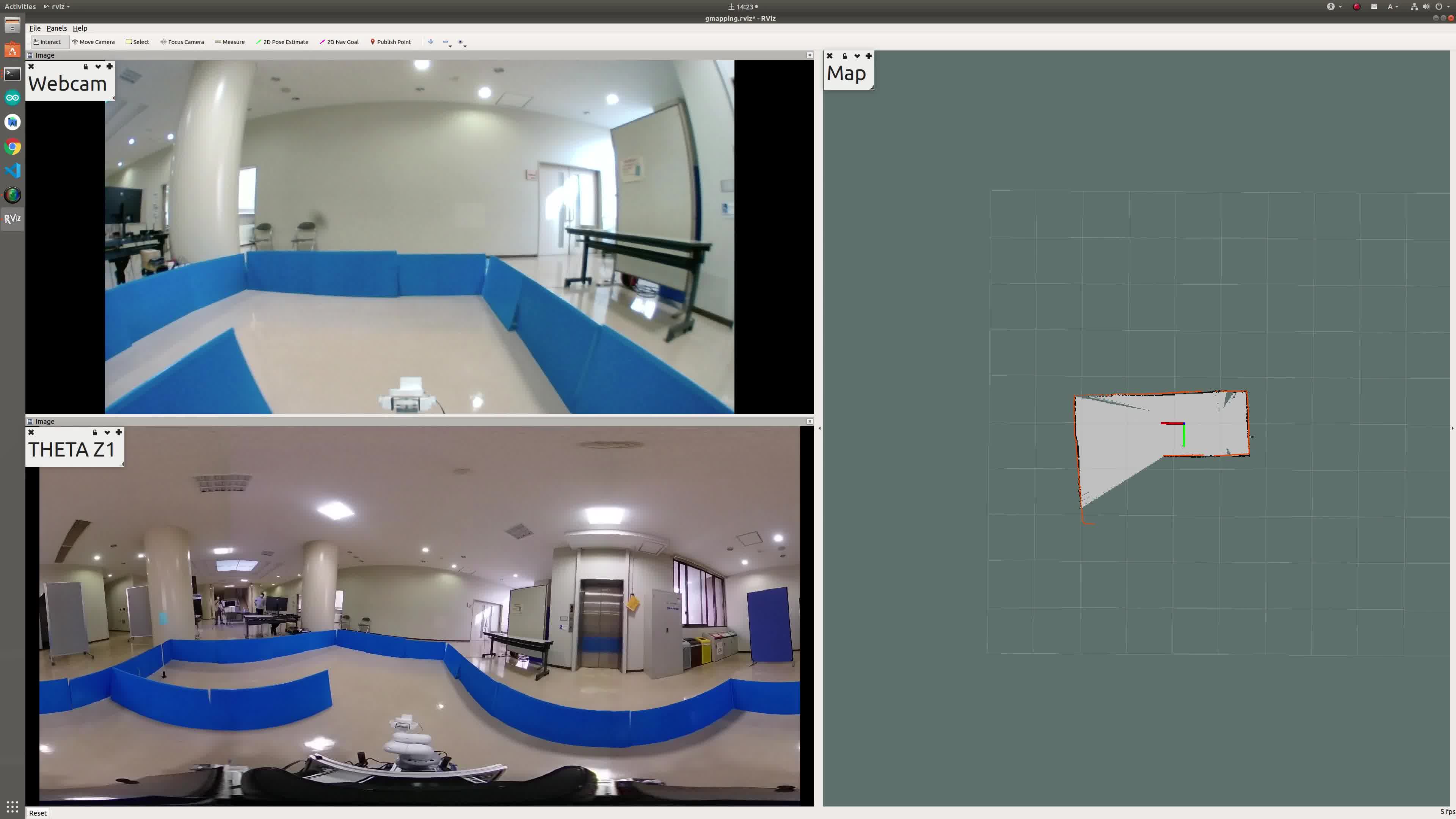

図6に,制御側のディスプレイ表示を示す.右に地図情報を示し,左上にWebカムの画像,左下にTHETA Z1の画像を示している.地図の中央が無人搬送車の位置を示しており,赤線で進行方向,緑線で進行方向に対して左向きを示している.地図は,占有格子地図(Occupancy Grid Map)で示されており,事前に設定した確率以上であれば占有されている(障害物がある)として黒色で表し,確率以下であれば占有されていない(障害物なし)として,灰色で表している.また,未知の個所は濃い緑色で表している.また現在のスキャンデータによって障害物があると認識されている個所はオレンジ色で表している.またWebカムはハイビジョン画質(1280 × 720),30fps,THETA Z1は2K(1920 × 960)30fpsに設定した.この場合の上りリンクの伝送速度はローカル5Gの最大伝送速度とほぼ同等となる.また遅延はWebカムが200ms程度であるのに対し,THETA Z1は前述の通り処理遅延が大きく500ms程度である[4].

この画面・地図を見て操縦者は無人搬送車,およびアームを制御する.それぞれの制御を行うコントロールパッドを用意した.無人搬送車制御用コントロールパッドに対して,前後左右の移動,および左右旋回を2本のアナログスティックに対応させた.さらに,アーム制御用コントロールパッドは,図4(b)に示すようにロボットアームの上下左右,伸縮に対応するようにボタンを対応させた.また,グリッパの開閉にも別のボタンを対応させることによって,つかむ・はなす動作を実現した.さらに,無人搬送車移動時にはアームを畳む(図4(b)参照)ことによって障害物との衝突を避け,アーム動作時には無人搬送車の正面にアームが向く姿勢を実現するため,両姿勢を事前に設定し,新たなボタンに対応させた.

この2台のコントロールパッド操作はjoystick_driversパッケージを用いて数値化され,ローカル5Gを経由して車載PCに送信する.車載PCはArm_control, UGV_controlパッケージを用いて,ロボットアーム,無人搬送車を制御する.

3.香川大学での実証実験・デモ

3.1 無人搬送車とロボットアームを遠隔制御するデモ

デモ構成としては一度更新し,デモ内容も一度更新しており,まず以下に示すデモ①を作成した後,構成を変更してデモ②に更新した.その後デモ内容を見直し,デモ③を構成した.

- ① 無人搬送車の遠隔制御

- ② 無人搬送車とロボットアームの遠隔制御(熟練者向け)

- ③ 無人搬送車とロボットアームの遠隔制御(初心者向け)

3.1.1 無人搬送車の遠隔制御

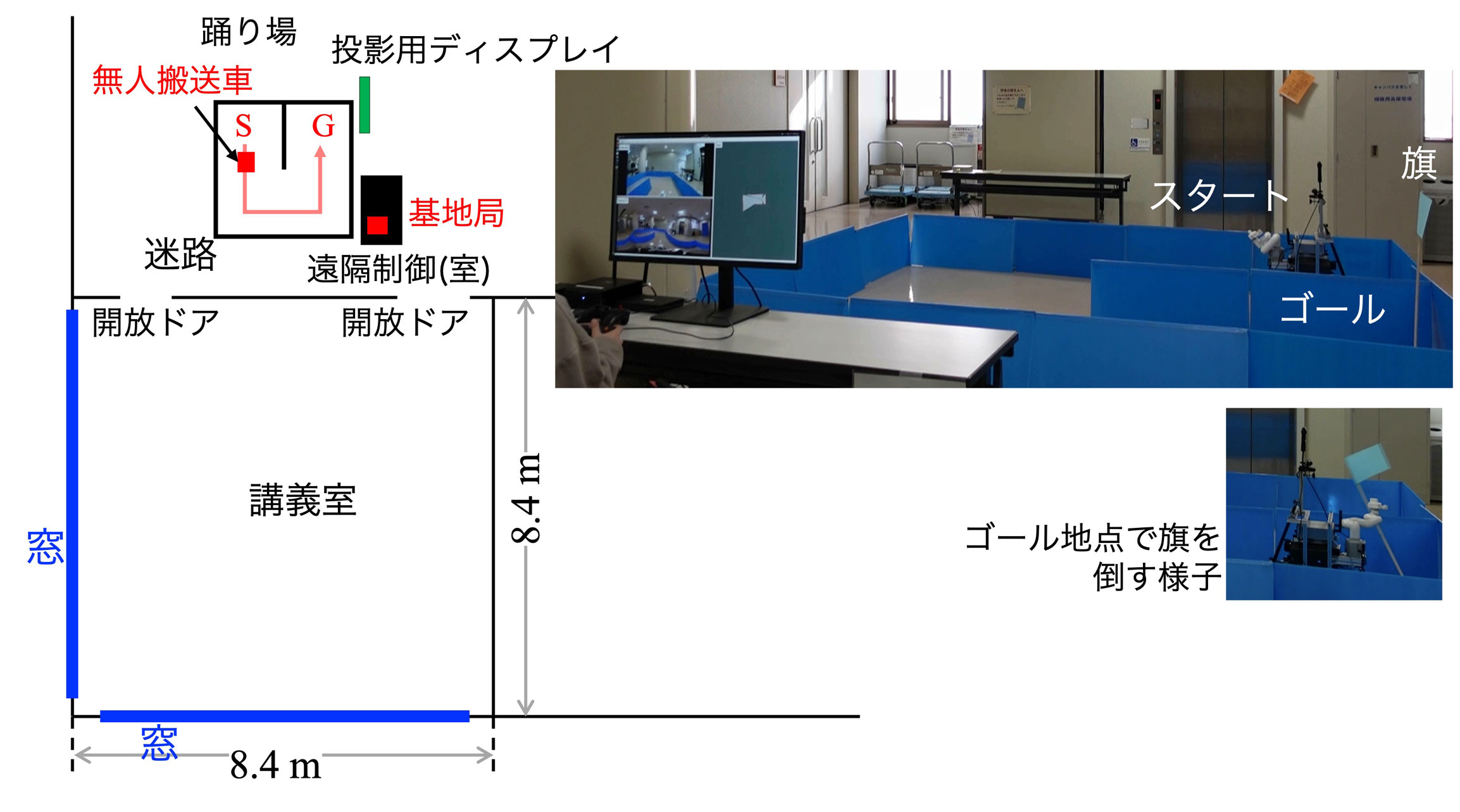

遠隔制御の最も簡単な構成として,無人搬送車のみを用いるデモを構築した.本システム構成は2.3節で説明した構成において,ロボットアーム,および360度カメラを除いた構成である.デモの構成を図7に示す.図に示すように,遠隔地点から,コントローラ1台を用いて,無人搬送車をスタートからゴールまで移動させるデモである.

![図7 無人搬送車の遠隔制御の構成[4]](DP6505-S04/image/image07.jpg)

迷路は,操縦者は直接見ることのできない離れた地点に青いプラスチックダンボールを用いて構成した.これは,可搬性に優れ,自由な位置に設置できる点,無人搬送車が衝突しても無人搬送車へのダメージが少ない点,Webカムを用いて明確に判別できる点,測域センサにより障害物として明確に認識できる点等を考慮して採用した.

2021年当時新型コロナウイルス感染拡大の影響により,オープンキャンパスがWeb開催となったため,動画を作成して公開している(動画撮影時には図7とは異なる場所で撮影している)[26].コントロールパッドにおける2本のスティックがそれぞれ移動・旋回に対応する馴染みやすい構成である点,画像に加え,地図情報がリアルタイムに表示されることから,多くの人が比較的短い時間で障害物に接触せずゴールに到達することができていた.

3.1.2 無人搬送車とロボットアームの遠隔制御(熟練者向け)

図8に示すように建機の遠隔制御により近い構成を実現するため,ロボットアームを新たに無人搬送車に搭載した.さらに,3.2節で述べる遠隔監視も考慮して,360度カメラも搭載した.これにより,建機の遠隔制御を小規模化した構成を忠実に再現した.デモにアームの動作を加えるため,3Dプリンタを用いて“5G”の形状のオブジェクトを作成した.これをロボットアームで持ち上げ,目的地に運ぶというデモを構築した.このデモで大きな問題となったのは,オブジェクトをグリッパで掴む動作を遠隔で行う点である.今回,Webカム,360度カメラのみでは,オブジェクトまでの距離を正確に把握することができず,オブジェクトを掴む動作に熟練が必要であることが分かった.そこで,デモとしては,掴む動作は操縦者の近傍で行うことで,目視で確認できる状態とし,目的地に置く場合にのみ画像で確認する構成とした.

![図8 無人搬送車とロボットアームの遠隔制御(熟練者向け)の構成[4]](DP6505-S04/image/image08.jpg)

本構成で複数回のデモを実施した.ロボットアームを設置したことによりデモの完成度が大きく向上したという反応がある一方で,ロボットアームの動作に慣れるのに時間を要するため,参加者が多い場合には,すべての人にデモを体験してもらうのに時間を要するという課題がある.

3.1.3 無人搬送車とロボットアームの遠隔制御(初心者向け)

3.1.2項に記載したデモは建機の遠隔制御を小規模化した非常に有効なデモであった.すでに述べたとおり,ロボットアームの操作には慣れるのに時間を要するという課題があった.

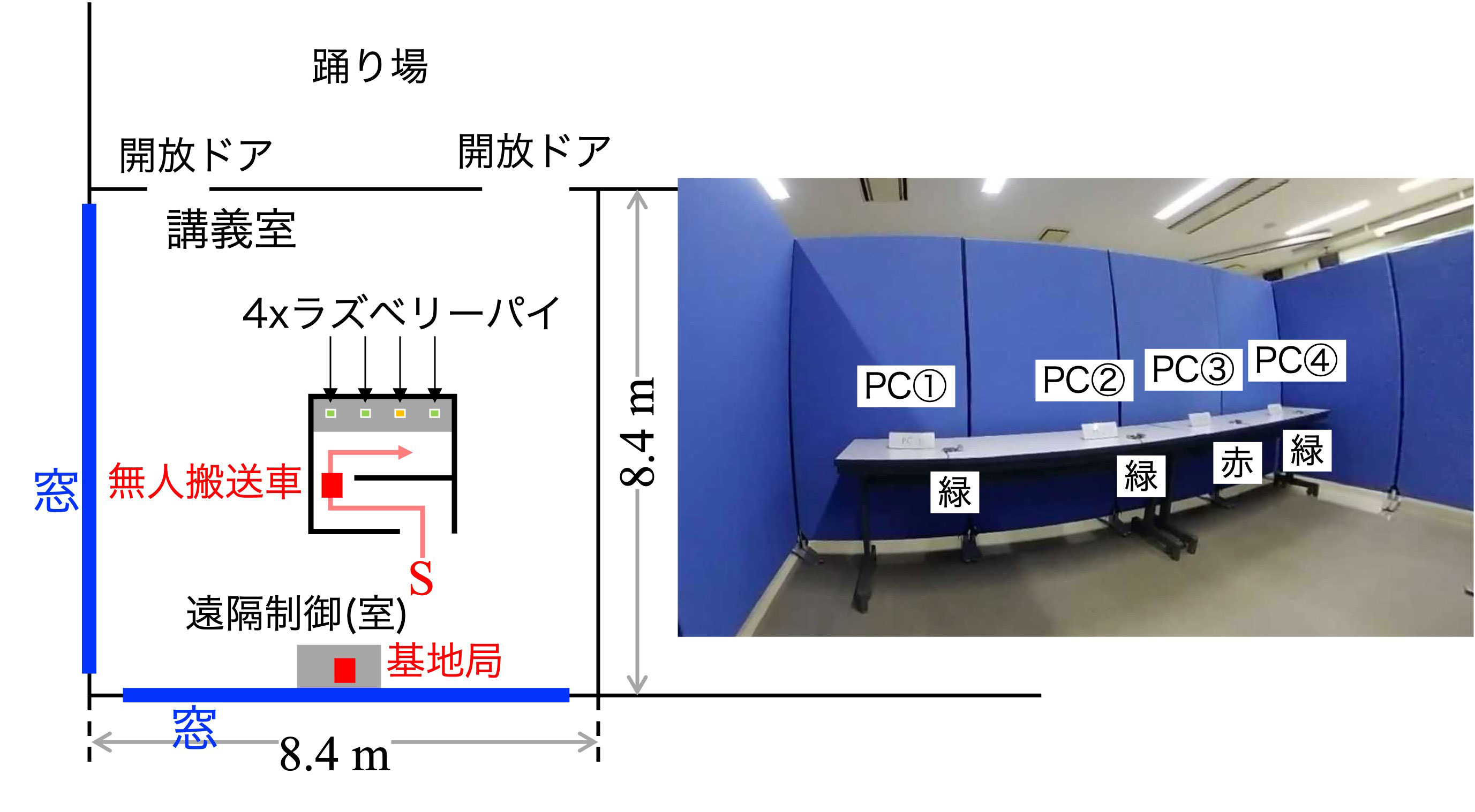

そこで,ロボットアームの動作を制限するデモを構築した.具体的には,ゴール地点に旗を設置する.スタート地点からゴール地点まで移動した後,ロボットアームを動作させ,旗を倒すというデモである.旗を倒すのみであるため,ロボットアームの動作は,前後・左右のみである.つまり,グリッパで物を掴むといった細かい動作は必要ないため,ロボットアームの動作の慣れも必要ない.

また,3.1.2項に記載したデモの別の課題として,グループで参加した場合,観覧者はゴール付近に移動する場合があり,操縦者と観覧者の距離が離れる点,動画伝送の遅延を目視で確認できない点があった.そこで,図9に示すように操縦席の前にコースを設営した.これにより,操縦者と観覧者の間で円滑なコミュニケーションが取れるようになった.また操縦者の画面と実際の画像を見比べて動画の遅延,コントロールパッドの操作と実際の無人搬送車の遅延を目視で確認できるようになり,ローカル5Gによる低遅延の実現をより明確に実感できるようになった.また,操縦席の制御PCの画面を分配し,操縦席とは離れた地点に40インチ以上の大型ディスプレイを設置して,操縦者の画面を投影した.この画面を用いて,デモを待機している人,観覧のみを希望している人にデモを説明できるようにした.この構成によって,オープンキャンパスなどといった多数の参加者が見込まれる場合に適した構成を実現した.課題としては遠隔制御というには操縦席とコースが近すぎる点があるが,これはデモ対象者の数などを考慮して,どちらを優先するかを考えることが必要となる.

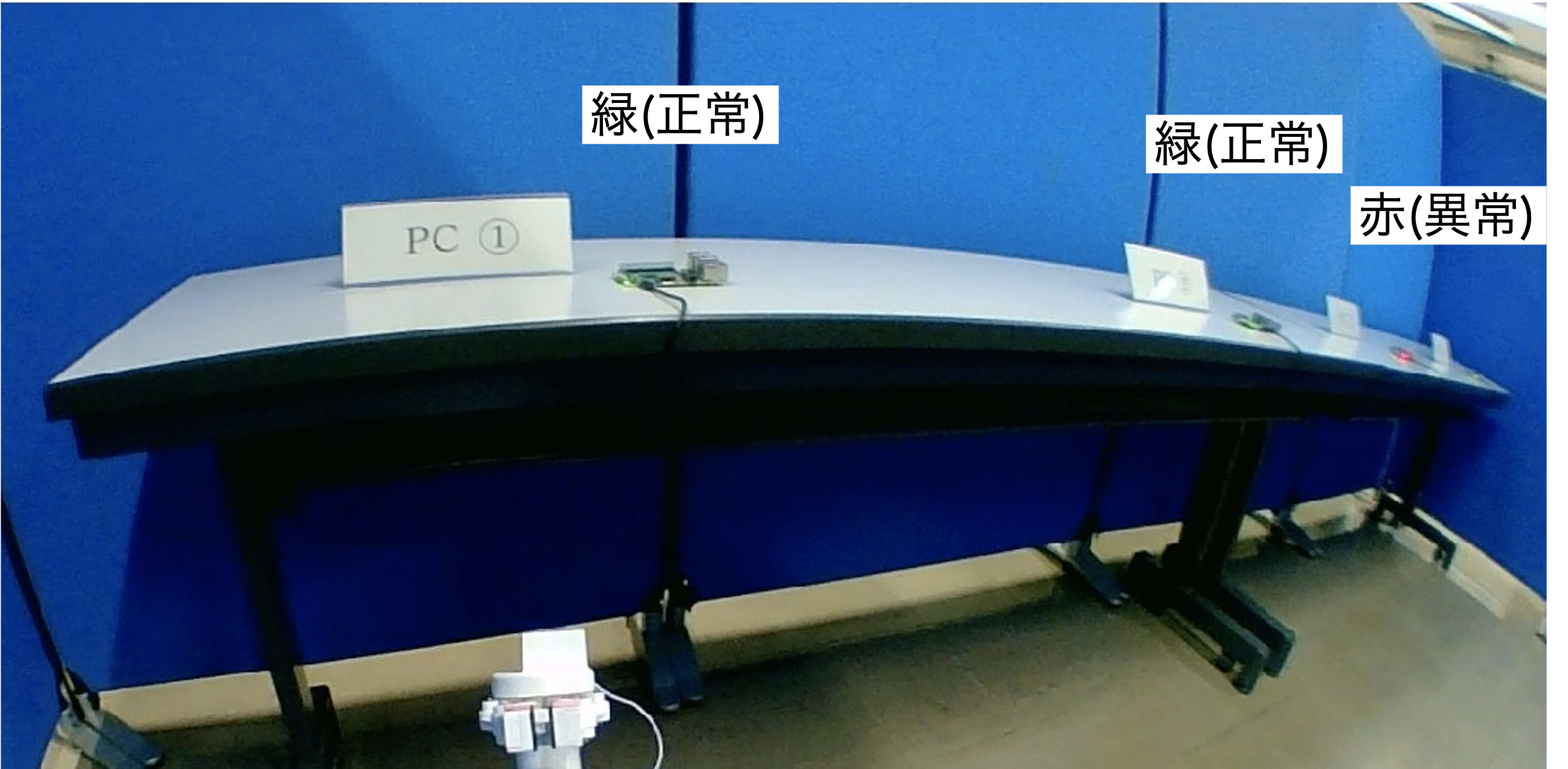

3.2 無人搬送車を用いて遠隔監視するデモ

次に,無人搬送車を用いて遠隔監視するデモを構築した.具体的には,データセンタのサーバルームにおいてサーバ機器の状態を示すLED・計器をWebカム,360度カメラを用いて遠隔監視することを想定した.本デモでは,図10(a)に示すようにサーバ機器の代わりに4台の小型のシングルボードコンピュータであるラズベリーパイ(Raspberry Pi)を設置し,3台は正常であることを示すためLEDを緑色に点灯させ,1台は異常であることを示すためLEDを赤色に点滅させた.遠隔制御室から操作して,ラズベリーパイの近くまで移動させ,LEDを確認した.図10(b)に示すように,Webカムの画像より,異常を示す赤のLEDが点滅していることを確認できた.また,360度カメラを用いることで,正面以外の位置についても確認でき,遠隔監視のデモが構築できていることを確認した.

図10 無人搬送車を用いて遠隔監視するデモ

今回用いた無人搬送車は,事前に決められたコースを移動することも可能である.この自動制御を用いることによって,より効率的な監視が可能になると考える.

4.その他の実証実験

ここまで説明してきた実験に加え,筆者らはローカル5Gの実証実験として,“4Kカメラと360度カメラの高精細映像で大学キャンパスを見守る実験”[27],“交差点の真ん中の360度カメラとローカル5Gでトライアスロン大会のバイク競技をVR観戦する実験”[28]も行った.本章ではこれらの実験について説明する.本章における実験では,無人搬送車は用いていない.そのため,PCにROSは搭載していない.

4.1 高精細映像で大学キャンパスを見守る実験

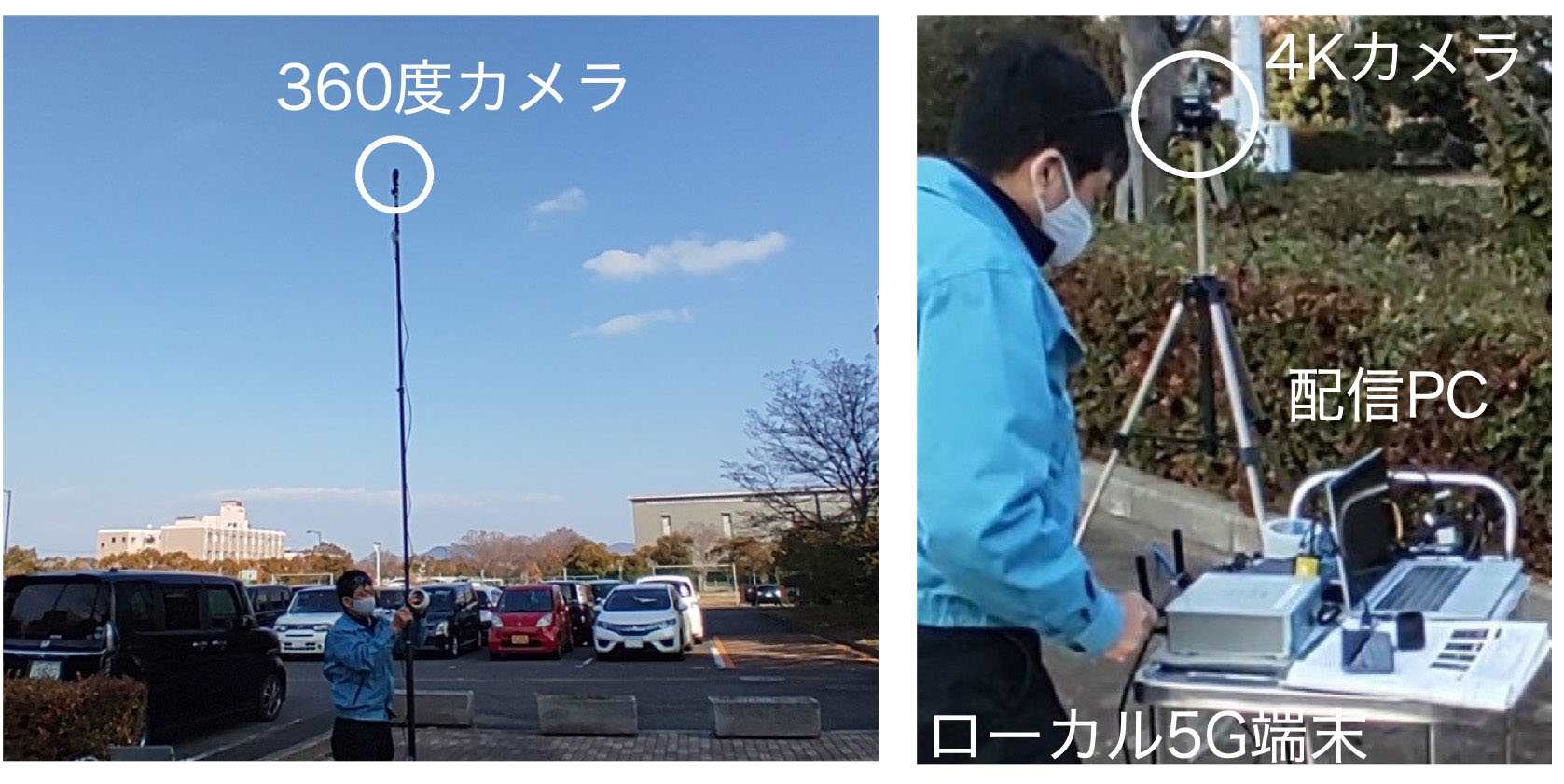

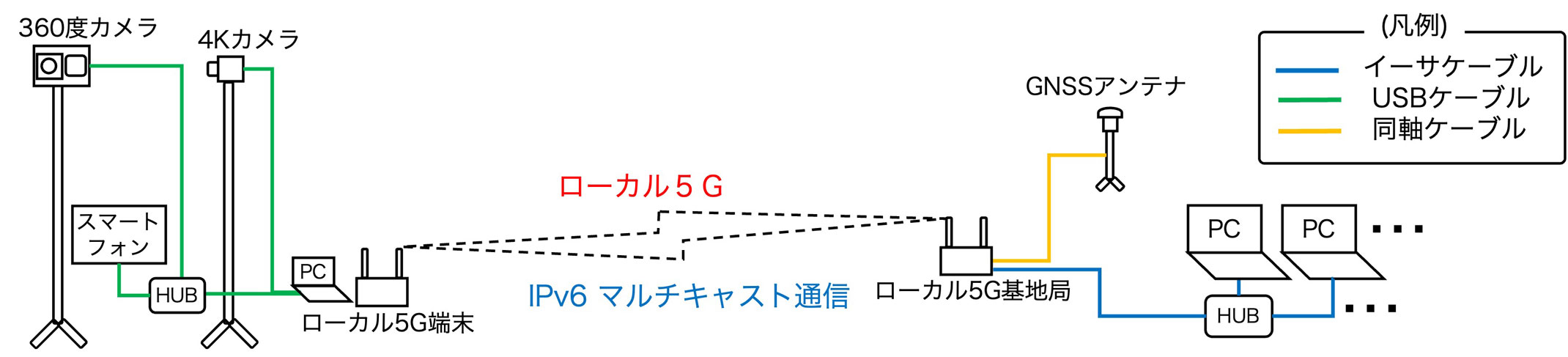

まず,高精細映像で大学キャンパスを見守る実験について説明する.ローカル5Gは,2.2節で述べたように“超高速”,“多数同時接続”,“超低遅延”といった特徴を活かして,工場やプラント,工事現場における機械の制御や,高精細映像を利用した街の見守り,施設の管理等への利用が期待されている.筆者らは,香川大学林町キャンパスを4Kカメラと360度カメラの高精細映像で見守る実験を実施し,現場システムの設置方法やアプリケーションへの活用方法についての知見・ノウハウを得るとともに,実際の遠隔制御や施設の見守りに適用できることを実証した.実験風景を図11に,システム構成図を図12に示す.

図11 4Kカメラ・360度カメラの実験風景

4.1.1 360度カメラ映像配信システム

360度カメラは撮影範囲を限定せずに360度の光景を高精細で撮ることができるため,従来のネットワークカメラに比較して,以下の利点がある.

プレイヤソフトの機能により,360度映像から見たい画角を切り出して得られることから,カメラ側にパン・チルト(首振り)のための機械稼働部分が存在しない.したがって,この機械部分の耐久性を考慮する必要がない.

実験終了後に確認する記録映像として活用した場合,360度映像であるため,従来のカメラ方向に限定される記録映像で生じていた取り漏らしがない.

カメラ設置時に撮影方向の事前調整や変更の手間・コストが不要である.また,1台のカメラで360度方向を網羅できることから,エリアを監視する場合等,カメラの設置台数を削減できる.

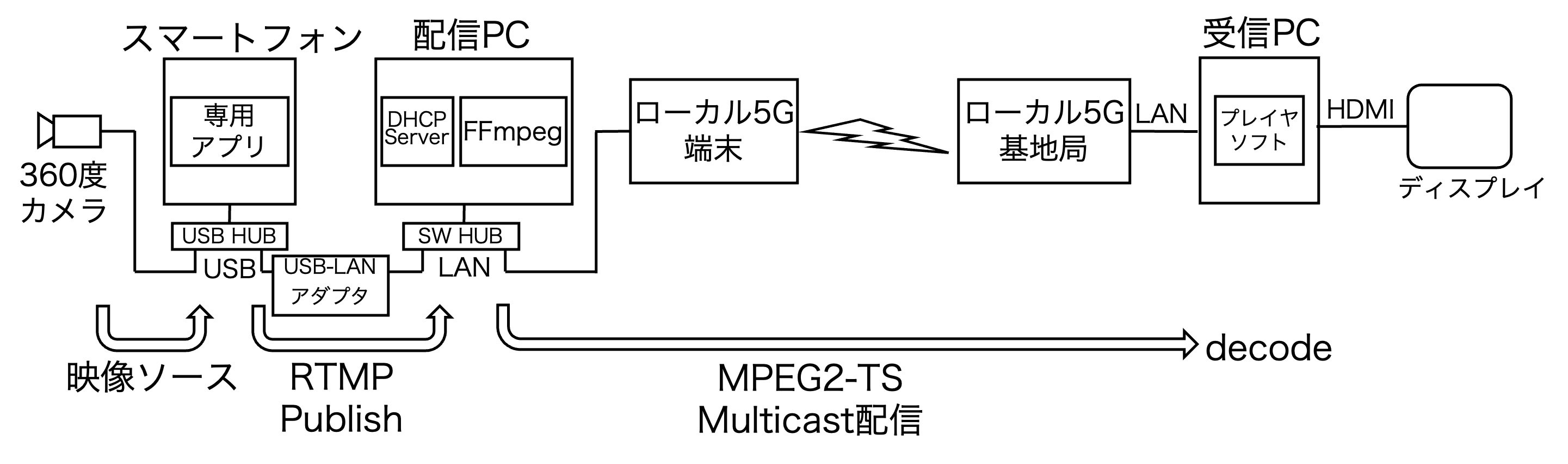

一方,リアルタイム伝送を実現するには安定した広帯域回線が必要である点が課題である.本実験では,ローカル5Gを360度カメラと組み合わせることにより,これらの利点を享受できるシステムが実現可能であることを実証した.360度カメラ映像の配信系統図を図13に示す.

スマートフォンから配信PCへの映像伝送は360度カメラメーカが提供する専用アプリの配信機能を利用し,配信PC(FFmpegサーバ)へReal Time Messaging Protocol(RTMP)配信(Publish)する.配信PCはスマートフォンから配信(Publish)された映像をソースとし,受信PCへ向けマルチキャスト配信する.360度カメラ映像の配信に関する具体的な設定等について,以下に述べる.

はじめに,スマートフォンにおける360度カメラ専用スマートフォンアプリの設定について述べる.まず,スマートフォンは配信PC上のDHCPサーバからIPv4アドレスを取得する.360度カメラ専用スマートフォンアプリは,カメラからのH.264で符号化した解像度が2560×1280の映像(8Mbpsのビットレート)をライブ配信モードで伝送する.ライブ配信モードでは,RTMP通信で,配信PCのIPv4アドレスへ映像を配信(Publish)する.次に,配信PCは,動画と音声を記録・変換・再生・配信するためのフリーソフトウェアであるFFmpeg[29]を用いた.FFmpegの設定により,配信PCはスマートフォンからのRTMP配信を受信できるよう接続待ち(Listen)し,受信した映像をIPv6マルチキャストアドレスとポート番号を指定してローカル5Gを経由して送信する.ここで,ストリーム形式はMPEG2-TSとした.一方,受信PCでは,プレイヤソフトを用いて,受信するIPv6マルチキャストアドレスとポート番号を指定し,正距円筒(エクイレクタングラ)図法の全天球動画を表示する.

これらの設定により360度映像を伝送した場合,ローカル5G区間における伝送速度は5Mbps程度となった.2023年時点で市販されているカメラのライブ配信機能は,従来の狭帯域な通信ネットワークを意識して作られていることから,映像品質より圧縮率を重視しており,ローカル5Gの帯域が十分に活かされていない.今後,ローカル5G等の高速ネットワークが普及するにつれて,カメラのライブ配信機能にも高ビットレート・高品質で動作するモードが実装されることを期待したい.

4.1.2 4Kカメラ映像配信システム

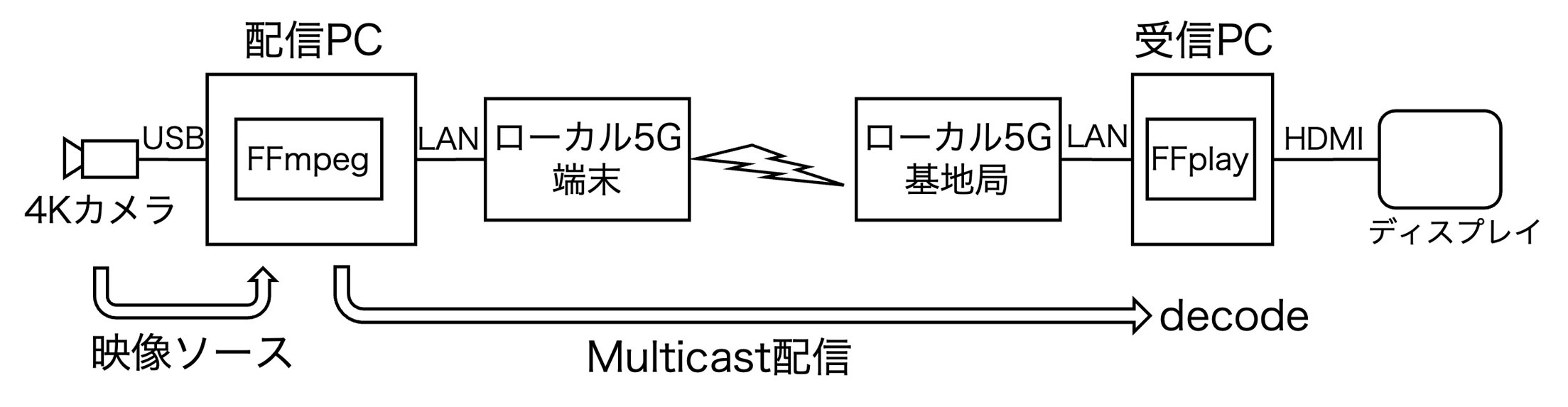

360度カメラ映像の伝送速度が5Mbps程度であったため,4Kカメラ映像を同時に配信し,ローカル5Gの最大伝送速度程度となった場合でも安定して配信できることを検証した.4Kカメラ映像の配信系統図を図14に示す.

4Kカメラは配信PCにUSBカメラデバイスとして接続しており,4Kカメラ映像を送受信するシステムはFFmpegとプレイヤソフトであるFFplayの対向で構成した.4Kカメラ映像の配信に関する具体的な設定は以下のとおりである.配信PCにおけるFFmpegの設定は4Kカメラをソースに指定し,Motion-JPEG で符号化した4Kの解像度(3840×2160),10fpsの映像を受信する.配信PCは,受信した映像をIPv6マルチキャストアドレスとポート番号を指定して送信し,ストリーム形式はMJPEG/UDPとした.一方,受信PCにおけるプレイヤソフトであるFFplayの設定は,受信するIPv6マルチキャストアドレスとポート番号を指定し,Motion-JPEGの映像を表示した.

これらの設定による伝送実験において,安定した映像伝送が実現できた.このとき,4K映像伝送のローカル5G区間の伝送速度は50Mbps程度であった.

4.2 トライアスロン大会のバイク競技をVR観戦する実験

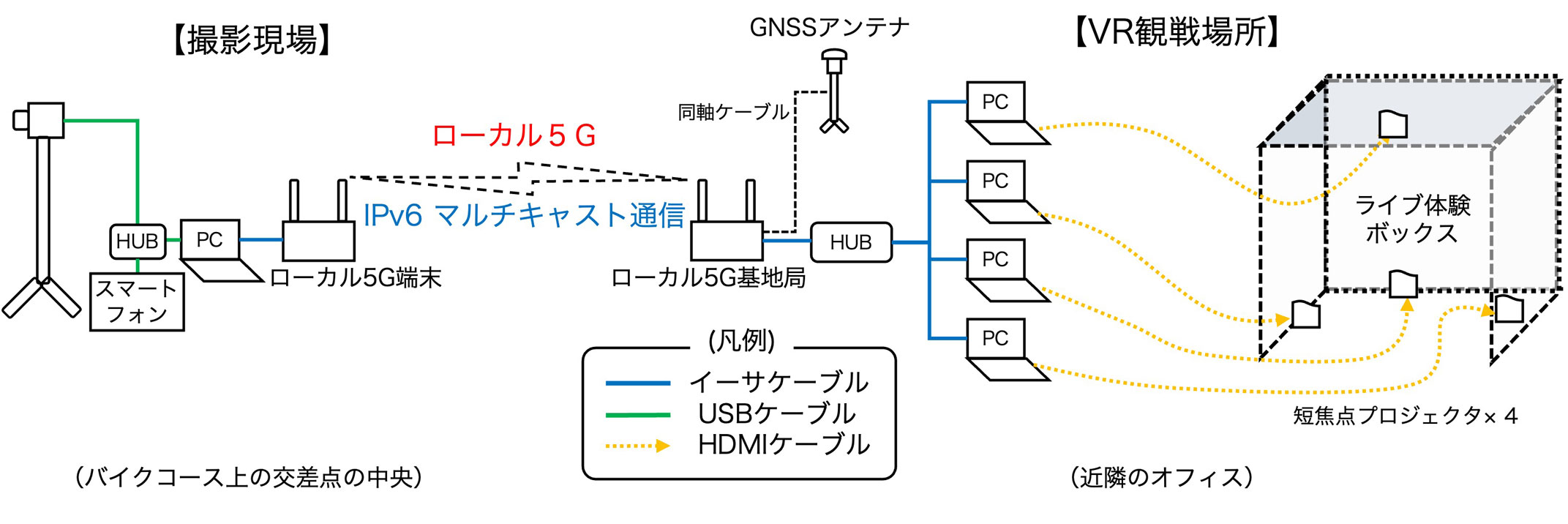

ワイヤレス映像伝送システムは,ケーブルを用いたシステムに比べて設置が容易で,コスト低減が期待できる特徴があることから,スポーツイベントやライブエンターテイメントへの適用が試行されている.STNetは,サンポート高松トライアスロン大会において,図15に示すようにバイクコースの往路と復路の間(交差点中央)に360度カメラを設置し,この場所で撮影された迫力ある映像をローカル5Gを用いて約65m離れた近隣のオフィスビルへ伝送した.オフィスビルに設置した“ライブ体験ボックス”でVR観戦する実験を行った.システム構成図を図16に示す.

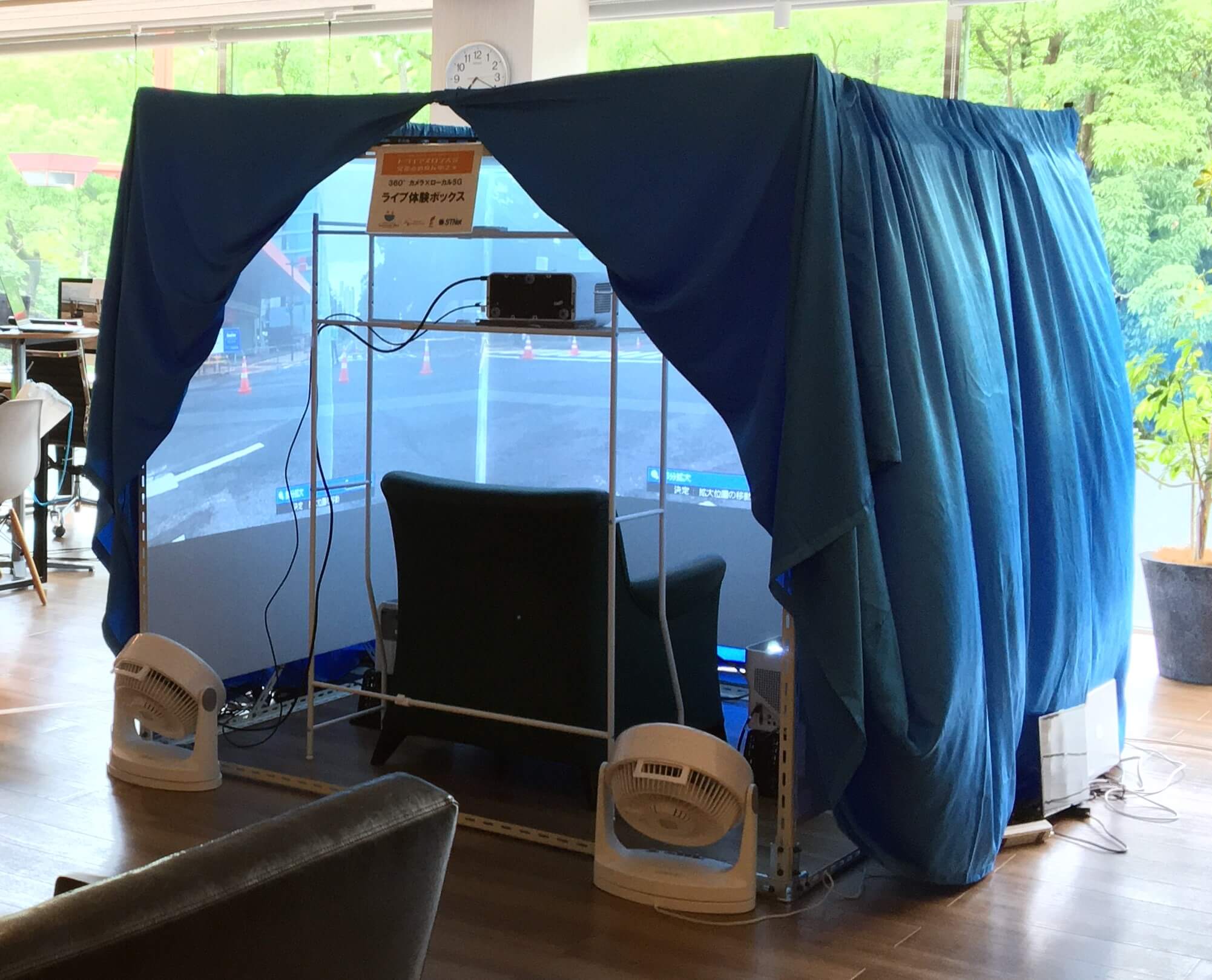

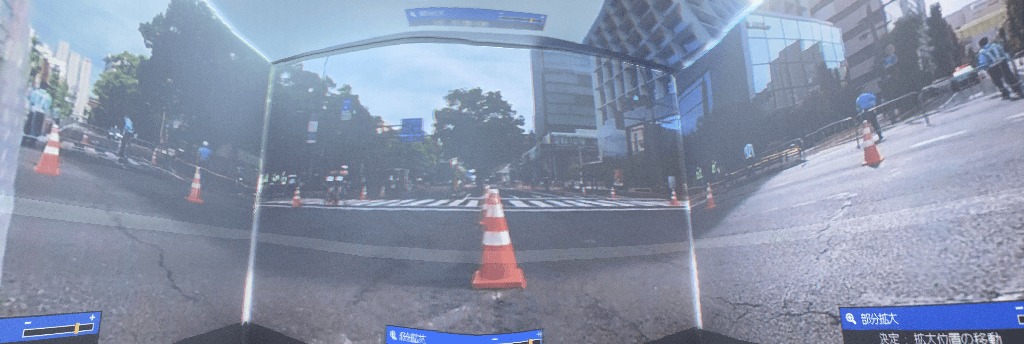

360度カメラ映像の配信系統図,およびシステムの設定は4.1.1項で述べたシステムと同様である.本実験では4台ある受信PCで,正面,左面,右面,上面それぞれの映像を360度映像から切り出し,四方と上部を壁面で囲んだ“ライブ映像ボックス”の内面にプロジェクタで投影する.投影された4画面が継ぎ目なく繋がるよう,切り出す画角をプレイヤソフトで調整している.4受信映像を合成したときにタイムラグによる違和感が生じないようにするため,4台の受信PCに対してマルチキャストで配信している.図17に“ライブ体験ボックス”の外観と投影された360度映像を示す.

図17 ライブ映像ボックス

360度映像を体験するデバイスとしてVRゴーグル等がよく用いられているものの,装着に時間がかかり,視野角が狭いという課題がある.より簡便,かつ臨場感の高い360度映像を体験できるシステムの可能性を評価検証するため,今回“ライブ体験ボックス”を考案・製作した.実際の体験者からは,以下に示す感想が得られた.

- カメラが路面近くに設置されているため,手が届きそうなところをバイクが通り過ぎるVR特有の迫力に思わず歓声をあげた.

- 本当に交差点の真ん中に座って,自分の周りをバイクが走っているような感覚になった.

- この仕組みを使えば“サンポート高松トライアスロン”を東京などの遠隔地でも臨場感があるライブで楽しめる.

5.実証実験から得た知見

本稿では,無人搬送車をローカル5G経由で遠隔制御する実証実験構成について示した後,実証実験・デモについて述べた.また,固定地点に4K・360度カメラを設置した映像伝送実証実験,トライアスロン大会のバイク競技をVR観戦する実験についても紹介した.いずれの実証実験・デモにおいてもローカル5Gの特徴を有効に活用しており,体験者から肯定的な所感を得ることができた.これらの経験をもとに,今後の研究に活用していきたい.

参考文献

- 1)Ericsson : Ericsson Mobility Report (Jun. 2023).

- 2)5GMF : General Report on 5G System Trials in Japan from 2017 to 2020 (Mar. 2021).

- 3)令和4年度ローカル5G開発実証等報告書,https://go5g.go.jp/carrier/令和4年度ローカル5g開発実証等%E3%80%80報告書/

- 4)Makino, I., Terai, J. and Miki, N. : Small-Scale Demonstration of Remote Control of Patrol and Work Robot with Arms Employing Local 5G System, IEICE Transactions on Communications, Vol.E106.B, pp.101-108 (2023). Copyright(c)2023 IEICE

- 5)Quigley, M., Conley, K., Gerkey, B, P., Faust, J., Foote, T., Leibs, J., Wheeler, R. and Ng, A. Y. : ROS: An Open-Source Robot Operating System, ICRA Workshop on Open Source Software (2009).

- 6)ROS : http://wiki.ros.org/sensor_msgs

- 7)ITU-R, Recommendation ITU-R M.2083, IMT Vision – Framework and overall objectives of the future development of IMT for 2020 and beyond (Sep. 2015).

- 8)総務省:平成30年版情報通信白書,https://www.soumu.go.jp/johotsusintokei/whitepaper/h30.html

- 9)総務省:令和2年版情報通信白書,https://www.soumu.go.jp/johotsusintokei/whitepaper/r02.html

- 10) 総務省:ローカル5G等を活用した 地域課題の解決に向けて (Jan. 2020).

- 11) 総務省:ローカル5G導入に関するガイドライン (Dec. 2019).

- 12) NTTドコモ報道発表:コマツとNTTドコモ,5Gを用いた建設・鉱山機械遠隔制御システムの開発に向けた実証実験を開始 (May 2017).

- 13) 古屋 弘,岩下正剛,陣内英二,蔵多正人,岡本邦宏,小林只和:次世代高速通信5Gを用いた重機の遠隔操縦の高度化,大林組技術研究所報,No.83, pp.1-9 (2019).

- 14) Takai, K., Aoki, K., Tajima, Y. and Yoshida, M. : Remote Control Demonstration of the Construction Machine Using 5G Mobile Communication System at Tunnel Construction Site, Proc. 37th International Symposium on Automation and Robotics in Construction (ISARC) (Oct. 2020).

- 15) ヴイストン(株):二輪駆動大型台車ロボット メガローバーVer2.1.

- 16) (株)エイビット:AU-510,https://5g.abit.jp/product/au500/

- 17) 北陽(株):URG-04LX-UG01, https://www.hokuyo-aut.co.jp/search/single.php?serial=17

- 18) Ballardini, A, L., Fontana, S., Furlan, A. and Sorrenti, D. G. : Ira_Laser_Tools: A ROS Laserscan Manipulation Toolbox, CoRR, Vol.abs/1411.1086, pp.1–6 (2014), http://arxiv.org/abs/1411.1086

- 19) ROS : https://wiki.ros.org/gmapping

- 20) Grisetti, G., Stachniss, C. and Burgard, W. : Improved Techniques for Grid Mapping With Rao-Blackwellized Particle Filters, IEEE Trans. Robot., Vol.23, No.1, pp.34–46 (Feb. 2007).

- 21) ROS : https://wiki.ros.org/rviz

- 22) サンワサプライ:CMS-V53BK, https://www.sanwa.co.jp/product/syohin?code=CMS-V53BK

- 23) ROS : http://wiki.ros.org/libuvc_camera

- 24) ROS : http://wiki.ros.org/image_transport

- 25) ROS : http://wiki.ros.org/gscam

- 26) 香川大学:ローカル5Gを体験しよう,https://www.youtube.com/watch?v=JXkFJxIIHlM

- 27) STNet : https://www.stnet.co.jp/archives/001/202203/press_20220308.pdf

- 28) STNet : https://www.stnet.co.jp/archives/001/202206/press_20220629.pdf

- 29) FFmpeg : https://ffmpeg.org

三木信彦

miki.nobuhiko@kagawa-u.ac.jp

1996年京都大学工学部卒業.1998年京都大学大学院修士課程修了.2009年慶應義塾大学工学研究科後期博士課程修了.1998年NTT移動通信網(株)(現,(株)NTTドコモ)に入社後,HSDPA,LTE,およびLTE-Advancedの研究,標準化に従事.2013年より香川大学工学部 准教授,2018年より香川大学創造工学部 教授.『第65回電子情報通信学会学術奨励賞』,2004年『無線通信システム活動奨励賞』,『第9回電子情報通信学会通信ソサイエティ論文賞』,『第11回電子情報通信学会通信ソサイエティ論文賞(チュートリアル論文賞)』受賞.

牧野一生

2020年香川大学工学部卒業.2022年香川大学大学院信頼性情報システム工学専攻修了.在学中,移動通信システムとIoTに関する研究に従事.

王 釗

2021年香川大学工学部卒業.2023年香川大学大学院信頼性情報システム工学専攻修了.在学中,移動通信システムに関する研究に従事.

武部駿佑

2023年香川大学創造工学部卒業.現在,香川大学大学院創発科学研究科に所属.IoTに関する研究に従事.

寺井淳司

1989年大阪府立大学工学部卒業.1989年四国電力(株)に入社後,電気通信設備の建設,保守,運用に従事.2018年より(株)STNetにて,地域課題解決に資する情報通信技術の研究開発に従事.

採録決定:2024年1月31日

編集担当:坂下幸徳(LINEヤフー(株)/ゼットラボ(株))