XRが拓くRX(リサーチトランスフォーメーション)

1.XR活用に基づくRX戦略

近年,メタバースやデジタルツインといった言葉とともに,人々の生活や社会を革新していくテクノロジーとして「XR技術」に注目が集まっている.XRとは,Cross RealityまたはExtended Realityの略語であり,リアルとバーチャルを融合した空間を創り出し,現実にはないものを知覚できるようにする技術の総称である[1].XRには,デジタル上の仮想空間において体験を得られるVR(Virtual Reality;仮想現実)技術や,現実空間にデジタル情報を重ねるAR(Augmented Reality;拡張現実)技術が含まれる.また,現実世界と仮想世界を融合し,相互にリアルタイムで影響し合う空間を構築するMR(Mixed Reality;複合現実)技術も含まれる.VR,AR,MRはそれぞれ異なる形態の技術であるが,近年は境界が曖昧になってきているため,総称としてXRという言葉が使われるようになった.XR技術の中には,ゴーグル型デバイスのような特殊な道具が必要となるケースもあるが,一般的なPCやタブレット,スマートフォンといったデバイスを使ってアクセスできる形態も増えている.産業界においてもゴーグル型デバイスを活用するような事例が増え始めており,XR技術が利用される場面は今後ますます広がっていくと予想される.

本稿では,国立の研究機関である情報通信研究機構(NICT)に所属する研究者である筆者が,NICT未来ICT研究所のサポートの元で進めている「XRシステムの開発と運用」に関する活動を紹介する.活動の目的は,科学技術振興機構(JST)の研究開発戦略センター(CRDS)が提唱する「リサーチトランスフォーメーション(RX)」を,研究者が主体となってボトムアップ的に促進することである.RXは,CRDSが2021年に公開したレポートの中で詳しく説明されており,「デジタルトランスフォーメーション(DX)等を駆動力として研究開発活動を革新し,そのオペレーティングシステムをトランスフォームすること」という概念を表す言葉である[2].レポートの中では,研究開発DXとしての遠隔化システムや研究コミュニケーションのかたちに関する方向性が述べられ,さまざまなデジタル技術の活用例が紹介されている.RXあるいはDXのために活用されるデジタルテクノロジーには5G,IoT,AIなどが挙げられるが,最近はXR技術も注目を集めている.XRは発展途上の技術であり,将来的にどのような有用性を発揮するのか,明確な答えは出ていない.RXの促進という文脈においても,研究現場のどのような場面でXRを使うのが効果的であるかは分かっていないのである.そのため,まずはXRを使用する場面を探りながら,XR活用にかかるコストや得られる価値に関する知見を蓄積していく必要がある.そのような活動を進める中でXRの効果的な使用方法や利用場面が見つかれば,それらの知見を共有していくことによって,XR活用によるRXの実現に繋がっていくものと期待される.

ここで,XR技術として一般的によく知られているVR,AR,MRといった技術に加えて,リアルタイム拡張仮想(Realtime Augmented Virtuality)の技術を紹介しておく.拡張仮想とは,VRで扱うような仮想世界に対し,実在する映像などのリアルな情報を加える形態のXR技術である[3].事前に撮影した静止画や動画を使う場合は,VRと似たような形態となるため,拡張仮想をVRに含めて説明するケースも多い.しかし,VR空間の背景画像として「現実を撮影したリアルタイムの映像」を使用する場合,VRよりもARに近い形態となる.その理由は,ARが「現実空間にデジタル情報を重ねる技術」であるのに対して,拡張仮想は「現実空間の映像にデジタル情報を重ねる技術」であり,どちらもリアルタイムで動作するものだからである.一方で,リアルタイム拡張仮想はARとも異なる.なぜなら,ARの場合は,その技術を利用するユーザが,本人の身の回りに実在するもの(あるいはそれらの部分的な映像)をそのまま利用することを前提としており,「遠隔地からの利用」が困難な形態だからである.拡張仮想であれば,現実世界全体が背景画像として取り込まれるため,遠隔地のユーザが利用しやすくなる.

リアルタイム拡張仮想は「遠隔化システムや研究コミュニケーションのかたちを探ること」に直結する技術であり,高い有用性を秘めているが,この技術を扱うシステムは世の中にまだあまり出てきていない.そこで筆者らは,リアルタイム拡張仮想を代表とするXR技術を活用した独自のシステムを「内製で開発する」という戦略で活動を進めることにした.内製であれば,ユーザとしての筆者が利用したくなるような機能を,必要に応じて開発者となって実装することができる.読者の方々がXR技術の開発を検討する際に,本稿で紹介するような内製スタイルでのシステム開発手法を参考にしていただければ幸いである.

2.XRシステムの開発手法

2.1 ゲームエンジン

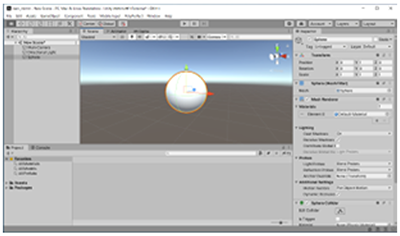

筆者らがXRシステムを内製で開発する際に利用しているツールの1つとして,ゲームエンジンを紹介する.ゲームエンジンとは,ゲーム開発に必要となる画像の表示やコントローラー入力の処理といった基本機能を提供するプログラムのことである.厳密な定義は決まっていないが,Unity [4]やUnreal Engine [5]といった統合開発環境をゲームエンジンと呼ぶことが多い.開発時には図1に示したようなエディタ画面を使って,仮想物体である3次元の立体モデルを空間に配置した上で,個々の物体にどのような物理的属性を持たせるかを設定する.何らかのタイミングで物体に特殊な動作をさせたい場合は,スクリプトと呼ばれるプログラミング基盤を使ってルールを記述し,そのルールを個々の物体に適用する.スクリプトを作る際には,C#あるいはC++といったプログラミング言語が使われることが多く,たとえば,Microsoft社が提供するVisual Studioのような統合開発環境を組み合わせて使うことになる[6].

ゲームエンジンは,仮想空間の中で物体を運動させたり衝突させたりするような物理的な演算を自動的に行う機能を持っている.また,作成したプログラムを動作させるプラットフォームをビルド時に選択できる仕様になっており,WindowsやiOSを搭載したPCはもちろん,スマートフォン,タブレット,ゴーグル型デバイス用のプログラムを製作できる.プログラムをWebサーバにそのまま配置可能なWebGLと呼ばれる形式のソフトウェアを製作することも容易であり,その場合はユーザがブラウザからアクセスするだけでシステムを利用できるようになる.ゲームエンジンの持つこれらの機能を活用すると,通常のPCだけでなく,特殊なゴーグル型デバイスを使ったXRシステムの開発を劇的に効率化できる.

2.2 仮想空間の作成

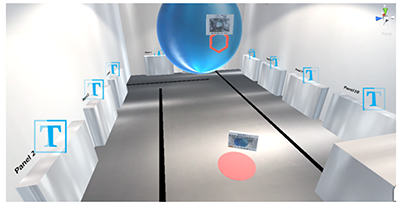

ゲームエンジンは,板や球体,円柱といったシンプルな形状の立体モデルを作成する機能を持っている.作成した立体モデルに色を付けることができるほか,テクスチャーとして画像を貼り付けたり,照明光の当たり具合を調整したりもできる.このような機能を組み合わせれば,ゲームエンジンの付属機能を使うだけでも,図2に示すような独自の空間を容易に作成することができる.さらにスクリプトをうまく使えば,mp4形式のムービーをテクスチャーとして再生したり,Webカメラのリアルタイム映像を描画したりするような空間も作成できる.

ゲームエンジン付属の機能だけで作成することが難しい複雑な形状の立体モデルが必要になる場合もある.そのようなモデルを入手する手段としてお勧めするのは,インターネット上で販売されているデータを購入する方法である.Unityの場合,アセットストアと呼ばれるWebサイトがゲームエンジンと連携するように設計されており,モデルに加えてアニメーションやスクリプトも含まれている「アセット」と呼ばれるパッケージを入手できるようになっている[7].既存のアセットを購入して使う場合のコストパフォーマンスはきわめて高いため,同じアセットが別の用途で使われている可能性が問題とならない場面であれば,積極的に活用すべき手法である.もちろん,インターネット上では手に入らないような立体モデルがどうしても必要になる場合には,3D CAD等を使って自作するか,あるいは特殊な撮影装置を使って立体データに変換することになる.デジタルツインのような空間を作るのであれば,どのような手順で立体モデルを作成するのかについて検討しておく必要がある.

2.3 現実との接点

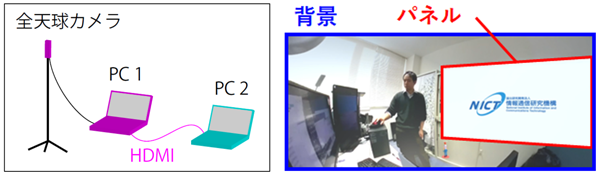

本稿で紹介するリアルタイム拡張仮想を実装する手法の一例として,全天球カメラを用いる方式を紹介する.全天球カメラとは,上下左右全方位の360度パノラマ写真や,360度のムービーを撮影できる装置であり,360度カメラ,VRカメラ,全方位カメラとも呼ばれ,リコー社の製品であるRICOH THETAシリーズがよく知られている[8].図3左に,全天球カメラを用いたXRシステムの実装例を示した.三脚の上に設置されているのが全天球カメラであり,PCにUSB接続した場合にWebカメラとして認識されるタイプのデバイスを使用しているものとする.リアルタイム拡張仮想の機能を持つ内製XRアプリをPC1で起動し,仮想空間に配置した球体に対して,全天球カメラから送られてくるリアルタイム映像を描画する.また,PC1においてUSBタイプのHDMIキャプチャユニットを動作させ,PC2付属のHDMI出力端子との間をHDMIケーブルで接続する.PC2では,デスクトップ画面を複製して出力する設定にした上で,スライドやムービーといったコンテンツを全画面表示する.PC1で受け取るPC2の画面に関しては,内製XRアプリ内の仮想空間に配置した板状のパネルにリアルタイム映像を描画するように設定しておく.

このような条件下で,全天球カメラのリアルタイム映像を背景として描画し,全画面表示したパネルの画像を右側に表示したのが図3右である.パネルの画像も背景の映像もリアルタイムに描画されるため,画面内に表示された現実世界の発表者が,現実には存在しない空中に浮いたディスプレイを扱っているかのように見える.パネルに表示される画像はPC2のデスクトップ画面そのものであるため,Teams [9]やZoom [10]といったオンライン会議アプリの参加者一覧を表示することもできる.さらに,XRシステムで作成した図3右のような画像を,オンライン会議アプリで画面共有して参加者に見せることもできる.このように,一般的なオンライン会議アプリと組み合わせたコミュニケーションツールとして利用できる点は,本稿で紹介するXRシステムの持つ特徴のひとつである.

2.4 なぜ内製するのか

筆者らは,ここまでに説明したゲームエンジンを活用して,仮想空間の作成や,現実との接点を持たせるための機能の開発を「内製」で進めてきた.それら内製システムの活用事例を紹介する前に,内製という手段を選択した理由に関して,内製によって発生するコストと,内製によって得られる価値を説明しておく.まず内製によって発生するコストであるが,最も大きなものはおそらく,仮想物体を動かすためのスクリプトを書けるようになる際に必要となる学習のコストである.特に,多くのゲームエンジンにおいて採用されている「オブジェクト指向」と呼ばれる設計で作られたプログラミング言語は,概念として理解するまでに時間がかかる.また,オブジェクト指向の言語をある程度マスターしたとしても,作成したプログラムには大抵バグが潜んでいるため,そのデバッグ作業に膨大な時間がかかってしまうこともある.しかし一方で,インターネット上に蓄積されている情報をうまく利用しながら,正常に動くソースコードを効率良く構築できるセンスがあれば,このような問題が発生する頻度を大幅に減らすことも可能である.

次に内製によって得られる価値について述べる.XRは発展途上の技術であり,特にリアルタイム拡張仮想の持つ可能性は未知数であるため,得られる価値を正確に見積もることは難しい.しかし,実際にXRシステムの開発を進めてみた結果として得た印象は,「内製で試作したものをさまざまな場面に応用してみることによって,新しい価値を短期間で生み出しやすいテクノロジーである」というものである.実際に筆者は近年の活動において,プレゼンテーション,見学会,動画コンテンツ作成,作業支援,講習会,交流会,展示会,打合せ,トラブル対応,オペレーショントレーニング等の場面でXRシステムを活用し,「楽しかった,ワクワクする体験だった」といった好意的な意見を多数もらうことに成功している.ここで強調しておくべきことは,内製のシステムであるからこそ,場面に応じて機能を加えながら仕様を自由にカスタマイズして利用できる点である.既存のプラットフォームを使う場合は,仕様を変更する権限をユーザが持っていないため,活用する場面を増やしにくい問題がある.業務の効率化やイベント運用といった場面に必要となる機能のカスタマイズに対して迅速に対応しながら,周囲の関係者に楽しんでもらうことにも貢献できるため,XRシステムを内製することの価値は大きい.

3.XRシステムの開発と運用

3.1 研究現場を「見せる」システムの開発と運用

それではここから,筆者らが内製で開発・運用を進めてきたXRシステムの活用事例を紹介する.まずは研究現場を「見せる」ために開発した,VRを使ったシステムと,リアルタイム拡張仮想を使ったシステムをひとつずつ紹介する.

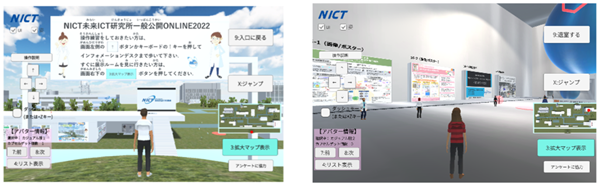

3.1.1 未来ICT研究所一般公開ONILNE用バーチャル空間サイト

1つ目に紹介するシステムは,筆者が所属する研究組織である未来ICT研究所の一般公開イベントで利用したONLINEバーチャル空間サイトである[11].このサイトはVRを活用したシステムで構成されており,ユーザが自宅PCのブラウザを使ってアクセスできる仕組みになっている.図4左に,Webサイトに入場した際に表示される画像を示した.中央下に立っている白いシャツのヒト型のモデルがアバターであり,入場者はこのアバターを操作して会場を回る仕組みになっている.図4右は,展示ルームの中の様子であり,5~10個程度の展示コンテンツが壁に並んでいる.アバターを展示コンテンツの前に移動させると,動画やポスターなどにアクセスできるようになっている.

展示ルームの数が少なければ,ゲームエンジンの中ですべての展示コンテンツを管理することも可能である.しかし,この一般公開イベントは未来ICT研究所を構成する研究室を主とした多くのチームが参加するため,20個を超える数の展示ルームを作成する必要があった.そのため,すべての展示ルームのコンテンツをゲームエンジン内で管理する方針は取らず,個々の展示ルームの担当者がコンテンツをWebサーバ上で管理できる仕組みを導入することにした.この仕組みのおかげで,プラットフォームの開発者の作業と展示コンテンツ管理者の作業をうまく分散することができた.なお,図4左に示したのは2022年7月に使用したサイトの画面であるが,ベースとなるシステムの開発に着手したのは2021年4月であり,同年7月には活用をスタートしている[12].メタバースが話題になる前の時期にこのようなプラットフォームを内製で構築し運用できたことは,高く評価された.なお,展示ルームの構成については別の論文で詳しく解説したので,興味がある方はそちらを読んでいただきたい[13].

3.1.2 XRを活用したオンライン見学ツアーとリモート監査

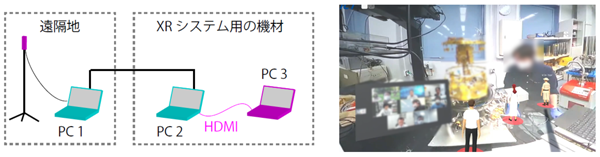

2つ目に紹介するのは,オンラインの見学ツアーや,筆者らがリモート監査と呼んでいる企画への活用をテストしたシステムである.前節で紹介した一般公開用のシステムとは異なり,現実のライブ映像を仮想空間に描画するリアルタイム拡張仮想の技術を活用している.システム構成の例を図5左に示した.機材が設置してある部屋とは異なる遠隔地のPC1に全天球カメラを接続し,その映像をオンライン会議アプリで画面共有した.共有した映像をPC2に表示した上で,さらにその映像を複製した出力をPC3に入力した.PC3において内製のXRアプリを起動し,PC2から受け取った360度の映像を球体の内側に描画した.球体の内部に数名のアバターを立たせ,そのアバターを操作することによって球体の中を自由に移動できるようにした.また,図には示していないが,オンライン会議アプリの参加者の映像もPC3に入力し,板状のパネルに描画した.

このシステムを使って,リモート監査をテストしてみた様子が図5右である.アバターを使って視点や視線を調整したり会話をしたりしながら,実際の現地訪問に近い形態で進行することができた[14].なお,このときのリモート監査では,神戸と小金井という離れた拠点に点在する3つの実験室の映像を同時に共有し,それらを順番に見学する形式で進行した.映像の共有にはオンライン会議アプリをそのまま使用し,複数の全天球カメラ映像を同時に共有した上で,PC2において表示する映像を選択した際に図5右の背景が切り替わる仕組みを利用した.このリモート監査の企画は,内製XRシステムの活用を試すことが目的でありながら,参加者は一般的なオンライン会議アプリを使ってログインするだけで済む形態になっており,この点は大変好評であった.

3.2 研究活動を「遠隔化する」システムの開発

次に紹介するのは,研究活動を「遠隔化する」ための内製XRシステムである.現地のライブ映像を見せるためのリアルタイム拡張仮想の機能を利用しているのは前節で紹介したシステムと同じだが,「研究用の装置を遠隔地から操作するための機能を持っている」という違いがある.

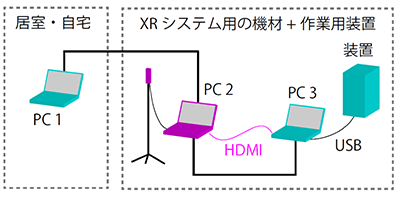

3.2.1 XRを活用したオンライン見学ツアーとリモート監査

図6を使って遠隔化システムの構成例を説明する.まず,自宅や居室に配置したPC1の前にユーザが座っている状況を考える.PC1はインターネットまたはイントラネットを介してPC2に接続してあり,OSに付属したリモートデスクトップの機能等を使って,PC2を遠隔操作できるものとする.PC2には全天球カメラがUSB接続されており,内製XRアプリを起動できるものとする.PC3は,現地で何かしらの作業を行うための装置がUSB接続されたPCであり,XRシステムを導入する前から稼働していたものであってよい.PC2とPC3はローカルネットワークで接続されているほか,PC3のモニターに表示されている画面を複製してPC2に入力する.少し複雑な構成図に見えるが,XRシステムの構成要素であるPC2と全天球カメラ部分を除くと,PC1,PC3,USB接続された装置だけが残り,多くの場所で一般的に運用されているシステム構成図であることが分かる.

PC2で動作しているXRシステムでは,全天球カメラのリアルタイム映像を描画するほか,PC3のデスクトップ画面をパネルに表示する.ここで,内製XRアプリ内の仮想空間の中に設置されている「PC3のデスクトップ画面が表示されたパネル」をクリックした際,そのクリックの情報をPC3に送信する仕組みを導入する.PC3では,その情報を受信した際にクリックを実行するアプリを立ち上げておく.すると,PC2で動作している内製XRアプリを使って,PC3を遠隔操作できるようになる.なお,図6において内製XRアプリの中で操作できるPCは1台として描いているが,PC3と同様の役割をするPCを複数台用意して,それらをすべてPC2から操作することも可能である.

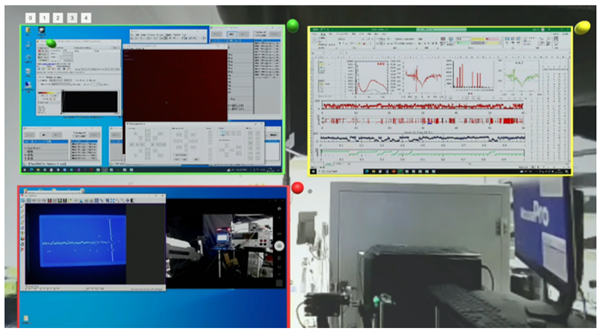

3.2.2 実験装置のリモート操作

リモート作業用のXRシステムを筆者が実際に活用している場面において,PC2に表示される画像を図7に示した.詳しい説明は割愛するが,活用場面は「顕微光量子計測装置のリモート操作」であり,筆者がこれまでの研究において開発を進めてきた装置を操作するシステムになっている[15].リモート作業を行うためのパネルは3つ表示されており,左上,左下,右上の順に,顕微鏡のカメラ映像と操作パネル,光量子の発生レートをリアルタイムに表示するモニター用画面,記録したデータを解析するための画面,が描画されている.背景として描画されているのは現地のリアルタイム映像であり,マウスでドラッグすることによって全体を見回すことができる.ひとつのパネルを手前に引き寄せて表示領域を拡大し,高い解像度で描画する機能も持っているため,そのままリモートデスクトップのように作業をすることも可能となる.

このXRシステムを利用することで,仮想空間から出した指示に応じてハードウェアが正常に動作しているかどうかを,背景映像を見ながら確認することが可能となった.外出先や自宅からインターネット経由でリモート操作を行う場面において,マルチモニターの画像を全て表示してしまうとかなり操作性が悪くなるため,1画面で済むことはメリットのひとつであった.また,作業の様子をアーカイブ動画として記録する場面においても,全てが1画面に収まっているメリットが活きてくることも分かった.

3.2.3 オンラインレクチャーへの活用

「作業を行う際に用いるPCが複数台であっても,XRシステムによって生成される画面はひとつである」という点は,オンライン会議アプリで画面を共有する場面とも相性がよい.オンライン会議アプリに付属している「リモート操作」といった機能を活用すれば,XRシステムを通して,遠隔地から作業を行うこともできる.筆者は近年,これまでに開発を進めてきた顕微光量子計測装置を使って,上記の方式でオンラインレクチャーを実施してみた.「装置の操作方法を理解している現地のエキスパートが,遠隔地のサポートスタッフに対して操作手順をレクチャーする」といった場面で,XRシステムが活躍することが分かった.

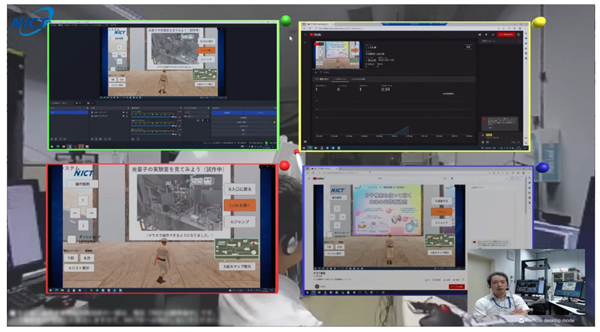

このようなXRシステムを使ったオンラインレクチャーの仕組みは,実験装置を動かすような場面でなくとも,さまざまな場面で活用できるポテンシャルがある.実際に筆者らは近年,YouTubeライブ配信の手順をオンラインレクチャーする企画を行う際に,内製のXRシステムを活用することに挑戦した.その様子を撮影したのが図8である.配信するコンテンツである動画の画像(左下)と,配信用アプリの画面(左上),配信サーバの状態を把握するための画面(右上),配信されている画像を視聴者として眺めるブラウザ画面(右下),という4つの画面をXRアプリ内のパネルに描画した.遠隔地から配信用アプリを操作することも試した.その結果,画像を眺めるだけのレクチャーをするよりも深い理解を受講者に与えられるほか,受講者の理解度をチェックする効果が得られることも分かった.

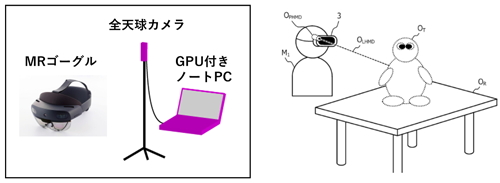

本節では,実験装置のリモート操作やオンラインレクチャーに対する内製XRシステムの活用例を紹介した.なお,本稿では詳しい説明を割愛するが,本システムは,ユーザがソフトウェアを起動する際に「使用する機能を選択できる仕組み」を実装してある.そのため,ゲームエンジンがインストールされている端末を使わなくても,システムをある程度カスタマイズして利用できるようになっている.ハードウェアとしては,GPU付きのノートPC1台,全天球カメラ1台,USB変換デバイス,ケーブルといった機材があれば動作するため,気軽に導入できる規模である.今後,システムを公開し利用者からフィードバックをもらいながら,広く普及させるための活動を進める計画である.XRシステムを開発する目的が「RXに貢献すること」であるからには,内製のソフトウェアを普及させるところまでを視野に入れて活動を進めるべきであると考えている.

3.3 Mixed Realityの活用

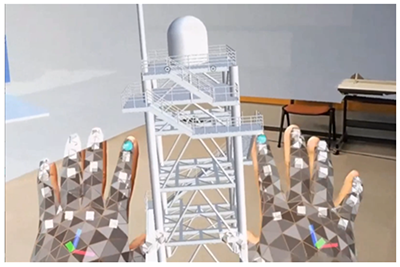

最後に,内製XRシステムへの実装を進めている「Mixed Reality(複合現実;MR)への拡張機能」を紹介する.MRは「現実世界と仮想世界を融合し,相互にリアルタイムで影響し合う空間を構築する技術」であり,専用のゴーグル型デバイスが必要となる.現時点で知名度の高いMRゴーグルのひとつに,Microsoft社のHoloLens 2というデバイスがある[16].このMRゴーグルは,半透明のディスプレイからなる光学シースルー型のデバイスであり,現実空間に仮想物体を重ねて描画した上で,その仮想物体を「自分の手で直接」動かすことができる.デバイスが装着者の位置や向きを認識しているため,仮想物体の裏側に歩いて回り込むことができ,現実空間に物体が存在するかのような認識を持てるようになっている.図9に,ゴーグルの装着者視点の映像の例を示した.ハンドトラッキングの機能によって,装着者の両手の形状や位置が検出され,仮想オブジェクトと相互作用できる状態になる.たとえば片手を仮想オブジェクトの中に入れた状態で,手の形状をパーからグーに変えるとオブジェクトを掴んだ状態になり,そのまま手を動かすことによって位置や向きを変えることができるようになる.

MR技術は建設,設備,社会インフラのみならず,医療,製造など,今後ますます幅広い分野で活用されていくことが予想されている.しかし一方で,MRゴーグル用に公開されているアプリの種類は少なく,高い有用性を持つ完成度の高いシステムは提供されていないのが現状である.そこで筆者らは,内製のXRシステムに「MRへの拡張機能」を実装することを考え,実際に開発を進めてみた.開発環境として使ったのはゲームエンジン(Unity)とVisual Studioである.開発の際にはMixed reality toolkit(MRTK)と呼ばれるツールキットのチュートリアルを参考にしたことで,ゴーグル用のアプリを開発した経験がまったくない筆者であっても,開発ノウハウを短期間で身に付けることができた[17].

3.3.1 MRゴーグルを活用したシステム開発

図10左に,MRへの拡張機能を持たせた内製XRシステムの構成例を示した.このシステムは,MRゴーグルとPCの両方で構成されており,これら2つのデバイスの間で情報を共有する仕組みになっている.ゴーグルの装着者は,半透明のディスプレイを通して見える現実と,そこに重ねた仮想物体の両方を視認しているものとする.PC側にはリアルタイム拡張仮想の技術を取り入れたアプリが動作しており,背景として描画された全天球カメラのリアルタイム映像に重ねて,仮想物体が描画されているものとする.図10右に示した図が,PC側で表示される画像の例である.左上に描かれている人物像(M1)がMRゴーグルの装着者であり,仮想物体としての視点(OPHMD)や視線(OLHMD)が描画されている.中央に実線で描かれた机(OR)は実在するものであるが,机の上に乗っている人形(OT)は仮想物体である.この状況で,仮想物体の座標,向き,スケール等の位置情報をMRゴーグルとPCの間で同期させる.すると,片方のデバイスで仮想物体の位置情報を変化させた場合に,もう片方のデバイスでも同様に変化させることができる.PC側においてリアルタイム拡張仮想の画像を表示することにより,ゴーグルを装着していない人も仮想物体を視認できるようになり,ゴーグルの装着者が何を見て何をしているのかを非装着者に伝えることができるようになる.

3.3.2 オンラインデモの実演

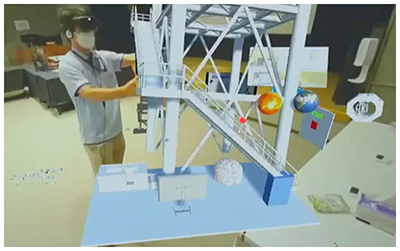

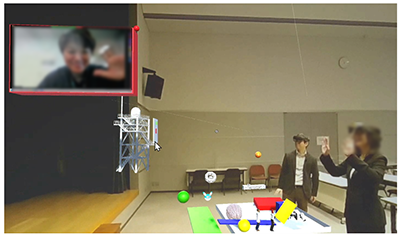

MRへの拡張機能付きのXRシステムを活用した事例として,2022年の7月に開催された未来ICT研究所の一般公開において,筆者らが実施したオンラインデモ実演を紹介する.図11に,オンラインデモ実演を行っている最中のスクリーンショットを示した.背景画像として表示されているのは現実世界のリアルタイム映像であり,左側に立っているのがMRゴーグルを装着した筆者である.中央付近に描画されているさまざまな立体構造物が仮想物体であり,筆者はMRゴーグルを通してこれらの仮想物体を視認し,自分の手を使って物体を動かしている.一般公開の当日は,PC側の画面をオンライン会議システムで共有した上で参加者と会話を行い,その画像や音声を含めてYouTubeライブ配信を行った[18].MRゴーグルを使って仮想物体を動かす様子を初めて目にする視聴者も多く,大きな反響があった.

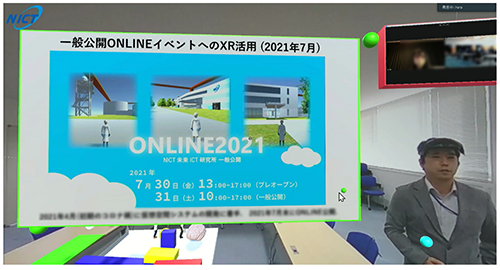

このように,リアルタイム拡張仮想の画像をPC側で表示することにより,ゴーグルの非装着者も仮想物体を視認できるようになった.画像の背景は全天球カメラを視点とした映像であるため,ゴーグル装着者が動きまわったとしても視聴者への影響が小さく,XRテクノロジーの弱点のひとつである「映像酔い」の発生を抑える効果があることも分かった.また,オンライン会議アプリで画面共有することも可能となり,参加者にリモート操作権を渡せば,遠隔地から視線を変えたり,仮想オブジェクトを操作したりすることもできるようになった.その結果,オンライン会議への参加者がただ単に視聴するだけの形態をとるのではなく,能動的に参加しアクションを起こすようなことも可能となった.しかもそのオンライン参加者は,TeamsやZoomといった既存のアプリを使って会議にログインするだけで済み,即戦力のツールとしてすぐに利用できる形態となっている.筆者自身も最近は,MRゴーグルと同期させたリアルタイム拡張仮想の空間にスライドやムービー,Webカメラ映像等を持ち込み,その空間の画像を画面共有してプレゼンテーション・講演・交流会等を実施する企画を何度も試している(図12).参加者が現地にいる場合であればMRゴーグルの体験会を同時に実施することも可能であり,そのような機会をきっかけとして,新しい活用方法や使用場面についての異分野融合的な議論が進むことも頻繁に発生している(図13).近い将来,人々の生活や社会を革新していくテクノロジーのひとつとして,本稿で紹介したようなXR技術が広く利用されるようになる可能性は高い.

4.RXに向けた課題

本稿では,内製で開発を進めているXRシステムの構築方法と活用事例を紹介した.研究現場を見せるためのシステムや,研究活動を遠隔化するためのシステムのほか,MRを取り入れたシステムも紹介した.特に,リアルタイム拡張仮想の技術を活用し,既存のオンライン会議アプリとも連携させることによって,さまざまな場面で利用できることを説明した.カスタマイズ性も備えたシステムが完成しつつあるため,「開発者自身がユーザでもある」というスタイルであれば,今後もかなり多くの活用場面を開拓し,XR活用のコストや有用性に関する知見を蓄積することが可能である.

今後さらに「RXの促進」という目的に向けてXR技術の活用を拡げていくためには,同様の活動を行う研究者と繋がり,コミュニティを形成していく必要がある.あるいは,XR活用を検討している研究者の活動を支援したり,そのような活動を積極的に進められる人材を育成したりしていくべきなのかもしれない.いずれにしても,まずはコストが小さく価値の大きい活用場面にターゲットを絞った上で,ユーザを増やしていくのが効果的な戦略であろう.現時点の有力なターゲットとしては,学会発表やプレゼンテーション等の「インパクトを与えることが重要な場面」のほか,オンラインレクチャやワークショップなど「参加者の体験が重要視されるイベント」等のシーンが挙げられる.これらのような場面においてXR技術を活用する研究者が増えれば,遠隔化システムや研究コミュニケーションのかたちが変化し,RXの実現に向けた道が開かれていくと予想される.

実際に研究者のXR活用を拡げていく際のシナリオには,2つの方向性が考えられる.1つ目は,本稿で紹介したような内製のXRシステムを汎用化させて,ほかのユーザが使いやすいように公開するような方向性である.この場合,XRシステムの運用方法やカスタマイズの手順を情報共有することは避けて通れず,それらを伝えるための作業を行う必要が生じる.本稿で紹介した内製XRシステムに関しては,ユーザを開拓するためのチーム体制の構築がまだ不十分であるため,このような活動を短期間で展開することは難しい状況である.しかし,所属する組織の枠を超えて,研究機関内外の協力者と連携してオープンな体制で活動すれば,普及への道が開ける可能性はある.もう1つは,「ゲームエンジンを使ったXRシステム内製」のノウハウや文化を広める方向性である.こちらの場合は,各分野の研究者がゲームエンジンを使って,それぞれの分野に特化したXRシステムを開発し活用していくような形態になる.もし研究者自身が内製することが難しければ,開発を得意とする外部の専門家が開発を担当するのでもよい.ただし,XR技術が発展途上である現時点では,仕様を事前に決めてトップダウンで開発を進めるような方式よりも,必要に応じて仕様を調整しながらテストを繰り返すボトムアップ方式で進める方がおそらく効果的である.

本稿で紹介したように,XR技術は試作したシステムをさまざまな場面で応用しやすく,新しい価値を短期間で生み出しやすいテクノロジーである.ぜひ読者の方々にも,活用場面の開拓や,内製でのシステム開発にチャレンジしていただきたい.XR技術の活用を目的とした異分野交流が活発化すれば,「XRが拓くRX」は現実のものになると確信している.本稿が,そのような未来の到来を加速させるきっかけとなれば幸いである.

参考文献

- 1)エクステンデッド・リアリティ:Wikipedia, https://ja.wikipedia.org/wiki/エクステンデッド・リアリティ(2023年2月28日現在)

- 2)(国研)科学技術振興機構 研究開発戦略センター:戦略提案・報告書,リサーチトランスフォーメーション(RX)ポスト/withコロナ時代,これからの研究開発の姿へ向けて,https://www.jst.go.jp/crds/report/CRDS-FY2020-RR-06.html

- 3)オーグメンテッドバーチャル:Wikipedia, https://ja.wikipedia.org/wiki/オーグメンテッドバーチャル(2023年2月28日現在)

- 4)Unity : https://unity.com/ja

- 5)Unreal engine : https://www.unrealengine.com/ja/

- 6)Microsoft Visual Studio : https://visualstudio.microsoft.com/ja/

- 7)Unityアセットストア: https://assetstore.unity.com/

- 8)Ricoh THETA : https://theta360.com/ja/

- 9)Microsoft Teams : https://www.microsoft.com/ja-jp/microsoft-teams/group-chat-software/

- 10)Zoom : https://zoom.us/

- 11)NICT未来ICT研究所一般公開ONLINE2022 : https://www2.nict.go.jp/advanced_ict/ippankoukai/2022/(2023年2月28日現在)

- 12)NICT未来ICT研究所一般公開ONLINE2021 : デモ動画,https://www.youtube.com/watch?v=6DEGTA3P7zM(2023年2月28日現在)

- 13)井原章之:研究現場におけるXR(クロスリアリティ)活用事例の紹介,電子情報通信学会,通信ソサイエティマガジン B-plus 2023,採択済.

- 14)土井美和子:監査のみのDXにあらず~組織全体のDXあってこそ~,第33回公会計監査機関意見交換会議(2022),https://www.youtube.com/watch?v=iXFoIRDR6cU&t=2490s(2023年2月28日現在)

- 15)Ihara, T., Miki, S., Yamada, T., Kaji, T., Otomo, A., Hosako, I. and Terai, H. : Superior Properties in Room-temperature Colloidal-dot Quantum Emitters Revealed by Ultralow-dark-count Detections of Temporally-purified Single Photons, Scientific Reports, Vol.9, No.1, p.15941 (2019).

- 16)Microsoft HoloLens 2 : https://www.microsoft.com/ja-jp/hololens/hardware/

- 17)Microsoft Mixed RealityツールキットMRTK2:https://learn.microsoft.com/ja-jp/windows/mixed-reality/mrtk-unity/mrtk2/

- 18)NICT未来ICT研究所一般公開ONLINE2022:展示コンテンツ紹介ツアー,https://youtu.be/vpm1ns9G9us?t=2h38m53s(2023年2月28日現在)

井原章之(非会員)t-ihara@nict.go.jp

東京大学物理学科卒.同大学院博士課程修了.博士(理学).東京大学生産技術研究所助教,京都大学化学研究所助教を経て,2017年情報通信研究機構未来ICT研究所入所.XR技術を活用した量子ICT実験システムの研究開発に従事.

採録決定:2023年4月6日

編集担当:西尾直也(日立製作所)