自律型視覚障がい者ナビゲーションロボットの普及を目指して

1.視覚障がい者移動支援

「光を失った人は移動の自由を失う.自分の家の周囲を歩くことも困難になる.自分が自由だとは思えなくなり,ほかの人に依存せざるを得ないと感じるようになる.」(日本語訳は筆者)これは1960年代に視覚障がい者教育に尽くしたトーマス・キャロルが中途失明により失う20のものを述べた文章の一節である[1].買い物に行く,レストランで食事をする,学校やオフィスに行く,こうした「リアル」な活動とその活動場所への移動は,私たちの社会生活の重要な一部である.移動をする自由を持たなければ人と会うことができず,食事を味わうこともできず,店で実際に物を触れて体感することもできず,会議に参加をして発言をすることもできない.デジタル化の進展によりリモートで可能な活動も増えているが,移動したいときに自分の意思で移動をしてリアルな活動を行うことの重要性は変わるものではない.

視覚障がい者は歩道・壁・障害物・曲がり角といった情報を離れた場所から視覚的に得ることが困難であり,独力での移動が困難になる.移動障がい者でもあると言われるゆえんである.そのため,視覚障がい者の移動を助けるさまざまな手段が発達してきた.白杖は最も普及している移動手段であり,1~1.5メートル先の段差や障害物を確認して歩行の安全性を保つほか,曲がり角などを示すランドマークを確認することで正しい順路で歩くことを可能にする重要な歩行手段である.決められた経路上の障害物や手摺り,人通りの多い道の音などの非視覚的なランドマークをあらかじめ確認することで独力での歩行が可能になるが,見知らぬ場所を白杖のみで訪れることは困難である.また,盲導犬も重要な手段である.盲導犬は視覚障がい者を支援するために段差や障害物を回避して歩行し,曲がり角を知らせる優れた能力をトレーニングによって獲得している.しかし,曲がり角を曲がる方向は人が判断をする必要があり,初めて訪れる場所で独力での移動ができるわけではない.こうした制約がありながらも白杖と盲導犬は長年視覚障がい者の移動を支えてきた.

さらに2020年以降の新型コロナウイルスのパンデミックは新たな困難を視覚障がい者にもたらした.感染対策のため,公共の場所で行列を作るときにある一定の間隔を開けることが社会的なルールとして新たに広まり,店舗のレジなどでは人の立ち位置が床に視覚的なマークとして示されるようになった.しかし視覚障がい者はこうしたマークを確認することができず,前の人との距離も視覚的に測ることができないため,この新たなルールに則って行動することが非常に困難である.また,人と人との会話に伴う飛沫・エアロゾルが重要な感染経路と判明したため,公共の場所での会話を控えることも新たなルールとなり,近くの人へ声をかけてサポートを依頼することも困難になった.このようにパンデミックを通して視覚障がい者の移動はさらに困難になりつつあるのが現状である.

2.関連技術

こうした中で新たな技術も開発されてきた.近年急速に発展しているのがスマートフォンを用いた視覚障がい者のためのナビゲーションアプリである.バックパック型コンピュータやメガネ型デバイスなど携帯可能なデバイスにより測位を行い,視覚障がい者を案内する技術が長年研究開発されてきた.特にこの10年ほどはスマートフォンの急速な普及と性能向上に伴い,スマートフォンのみを用いた手法が発展している.たとえばNavCogはBluetooth LEビーコンに加えて加速度センサによる測位(デッドレコニング)などを組み合わせて屋内でも1.5メートル程度の測位精度を実現することで視覚障がい者の屋内ナビゲーションを可能にしている[2].

Wi-Fiやビーコンを用いた測位は建物内の各所にビーコンなどの設備を大量に導入する必要がある点が欠点である.これに対し,画像処理のみを用いる方法は事前の画像データ収集作業のみで測位環境を構築することができる点が大きな利点であるが,昼間・夕方・夜間の見え方の変化,学校の廊下のように視覚的に判別の難しい場合,画像処理による電力消費(バッテリ駆動時間の大きな減少)などの課題が存在している[3].

測位方式に決定打がないのに加えて,スマートフォンからの音声による方向提示の難しさが知られている.視覚障がい者がスマートフォンからの音声情報を解釈し,白杖を用いて確認した上で歩行する必要があり,認知的負荷が大きい.そのため,高いスマートフォン普及率と比較してナビゲーションアプリの普及はまだまだ進んでいないのが現状である[4].

また白杖に認識技術を組み合わせて視覚障がい者のナビゲーションを支援する「スマートケイン(スマート白杖)」の開発が世界中で進められている.この場合も測位に用いることのできるセンサが白杖に搭載できる大きさに限定されるため,実用化されたものは少なく普及も進んでいないのが実情である.

さらに盲導犬ロボットをはじめとしたナビゲーションロボットに関してはこれまで数多く構想されてきたが研究段階にとどまったものがほとんどであり,実証実験に進んだものは少ない.ロボットには視覚障がい者が後をついて歩くだけで任意の目的地まで移動できるという大きな利点がある.しかしながら実用を目指すには非常に高価であり,普及のための経済的モデルを立てられたものは存在してない.

3.構想

こうした中で,自らも視覚に障がいを持ち,現在AIスーツケースプロジェクトのリーダーを務める浅川が思いついたソリューションが「スーツケース」であった.浅川は1人で出張に出かけることが多く,1人で歩行する必要が日常的に存在するため,スーツケースと白杖を一緒に持って移動をしていた.あるときスーツケースを前に押して歩くだけで障害物を認識できること,また曲がり角などもスーツケースで確認できること,下向き階段などの危険個所を確認できることに気づいた.つまりスーツケースは白杖の一部機能を代替可能であると気づいたのだ.またスーツケースを持って歩くのは自然な動作であり,街にさりげなく溶け込むことができることも大きな利点である.そこで,「視覚障がい者が街に馴染んでカッコよく歩く」ことを目標に,市販のスタイリッシュなスーツケースをベースとして認識系,制御系,駆動系を組み込んだAIスーツケースを構想した.

前述のようにロボットの実用化には価格が大きなネックとなる.そのため当初から価格を下げつつユーザの利便性を損なわないようにユーザ目線での割り切りを行った.たとえば,段差を乗り越える機能を持たせようとすると四足歩行など特殊で高価な機構が必要になる.そこで段差は帯同するユーザが通常のスーツケースの要領で持ち上げる設計とした.このように必要なときにユーザがサポートをすると言う発想はロボット開発者の視点よりも,実用化を目指すユーザ視点の発想であろう.

AIスーツケースの構想をまとめると以下のようになる.

- 視覚障がい者が信頼して利用できる.目的地を指定すると障害物や歩行者を適切に避けて安全に誘導する.地図のある場所では周囲のお店なども案内する.地図の存在しない場所では,周囲の看板などを認識しながら誘導する.

- 視覚障がい者が街に馴染んでカッコよく移動することができる.旅行を常に助けることができ,スーツケースとしても利用できる.シンプルな操作方法で,短時間のトレーニングで利用できる.

- 社会的ルールを理解して守ることができる.行列への割り込みなどをせず適切に並ぶことができ,ある程度人が多い場合でも周囲とスピードを合わせて移動することができる.

- ロボットが実施することが困難な場面ではユーザがロボットを助ける設計思想とする.段差を登る(降りる)機能は省略し,ユーザがサポートする設計とする.狭い場所など技術的にロボットにとって難しい場所ではユーザがサポートする.

非常に高い目標であったが,この実現のために浅川が客員教授を勤めるカーネギーメロン大学(以下CMU)の研究室において,IBMの研究員で現在はCMUでプロジェクトサイエンティストを務める佐藤が中心となり開発が始まった.さまざまな国から浅川のもとに研究員が集まった.2018年春には自律走行ができない初期のモデルを使って,空港でのシナリオを示したコンセプトビデオが作成された.この中では浅川自身が空港のカウンターに1人でチェックインし,空港内の鉄道に乗車後,ゲートに到着,その後飛行機遅延のためにカフェテリアに移動するまでのシナリオが示されている.浅川が実際に空港で経験した,多くの困難を解消するアイディアがシナリオとして盛り込まれていた.その後の開発では,このビデオのシナリオの実現を目指す形で開発が進められたという点で優れた「ビデオによるプロトタイプ」になった.

当初から街中で邪魔にならずに一緒に移動できるサイズとして,飛行機の機内に持ち込み可能なスーツケースのサイズを目標にした.これはもちろん一緒に旅行するためには機内に持ち込む必要があることも理由である.またカッコよく歩くためにファッション性の高い市販のスーツケースにこだわったこともサイズ選択の理由の1つである.しかしこれは同時に横幅を大きくすることができずに安定性が低くなることを意味する.開発の初期段階では自律走行により視覚障がい者を案内することが可能なパワーと精度を確保しつつ,目標とする形やサイズ,重さ,またスーツケースとして自由に移動できるという機能のトレードオフをどのように解消するかという点で試行錯誤を繰り返した.

CMUにおいて,約2年をかけて5世代のロボットを開発し,実証実験用に安定して動作するプロトタイプに到達することができた[5].しかし,実用可能性を示すためにはより完成度の高いロボットを開発する必要があった.自律型ナビゲーションロボットの開発には街中の環境を安定的に走破するための駆動系,動的な環境を認識するためのセンサ,ユーザとインタラクションするためのセンサや情報提示をするための振動提示といったハードウェアの技術に加え,人や障害物を安全に回避するための制御技術,視覚障がい者の意図に応じた動作をするためのインタラクション技術などソフトウェア技術の開発も重要である.さらに「街に馴染んで歩く」という目標を達成するためにはデザインも重要である.「総合芸術的」と言っても過言ではないであろう.とても一社で到達可能な目標とは考えられなかった.

そこで,さまざまなスキルを持った企業に声をかけて共同で開発を行うことになった.幸いなことにCMUで作成したビデオは分かりやすく,各社にAIスーツケースの目標に共感して参加していただくことができた.こうして設立されたのが,AIスーツケースコンソーシアム(正式名称:次世代移動支援技術開発コンソーシアム☆1)である.アルプスアルパイン社は言うまでもなく車載センサ・触覚デバイスなどを含めたさまざまな先端部品の技術を持っている.オムロンは自身もサービスロボットを開発する企業であり,今回は画像認識技術の立場で参加をした.清水建設は視覚障がい者のナビゲーション技術で協業した実績があり,各種ロボットの開発実績も有していた.これに自動車メーカである三菱自動車が加わる形で2019年12月に設立し,2020年2月に共同で記者会見を行った.

この設立記者会見は関係者の想定をはるかに超えた反響があり広く報道された.視覚障がい者のナビゲーションロボットというビジネス的には決して大きな市場が見通せない分野であっても,最先端技術で障がい者の社会参加を実現するというプロジェクトの社会的な重要性を実感するとともに,それからの開発の大きなモチベーションになった.

しかし2020年2月といえばパンデミックが深刻化し,日本でも行動制限が始まった時期と重なっている.そのためプロジェクト自体が大きな影響を受けることとなった.開発メンバ全員が在宅を余儀なくされたため,特にハードウェアの組み立てや走行実験は大きな影響を受けた.担当する研究員の家族の多大な協力のもとに,個人宅に全ての部品を集めて廊下で走行実験を行うなど通常では考えられないプロセスを経ることとなった.この場を借りて担当研究員のご家族の方々に謝意を表したい.

4.AIスーツケース

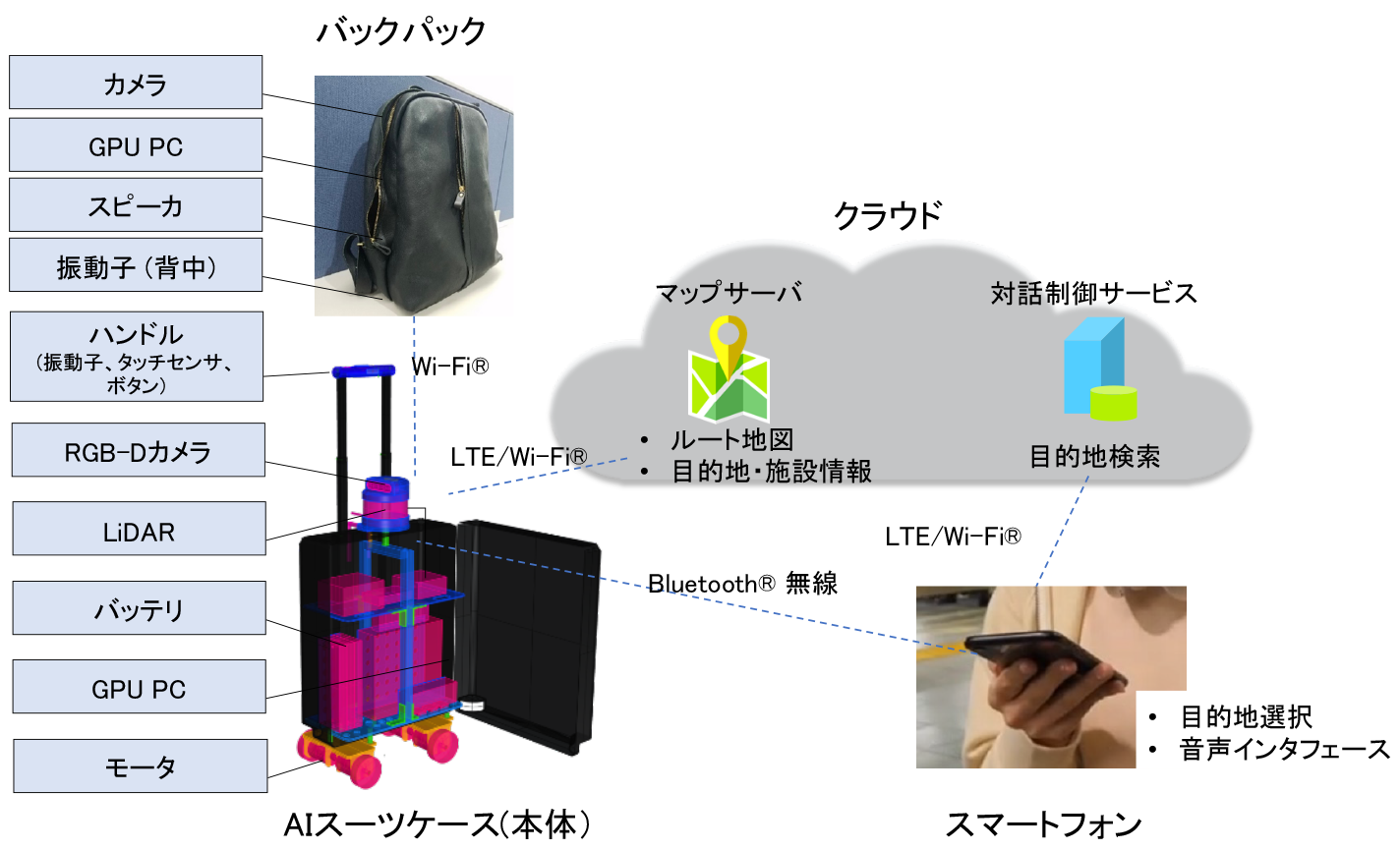

開発したAIスーツケース・システム(図1と図2.以下AIスーツケース)は本体,スマートフォン,クラウド,そしてバックパックの4つの部分からなる.本体には市販の機内持ち込み可能なスーツケースが用いられている(5.1節参照).元となったスーツケースとAIスーツケース本体の見た目上の大きな違いは,上に乗せたセンサ(LiDARとRGB-Dカメラ)であろう.本体下部前輪2つが駆動輪となっている.目的地選択インタフェースは本体とBluetooth無線で接続するスマートフォンを用いる.これは視覚障がい者にスマートフォンが広く普及しており,メニュー選択でも音声対話でも自然な目的地選択が期待できるためである.音声対話にはクラウドの対話制御サービスを用いている.

目的地が選択されるとスマートフォンから目的地のIDが本体に送られる.本体はマップサーバから目的地の場所とそこまでのルートを受け取り,ナビゲーションを開始する.ハンドル下部にはタッチセンサがあり,手が触れているときだけ走行する仕組みとなっている.つまりユーザが手を離せば止まるため単独で暴走することはなく,危険を感じたら手を離すという自然な動作で止めることができる.左右に曲がる場合はハンドルに埋め込まれた振動子で曲がる直前に方向を提示する.これによりAIスーツケースへの安心感を増し,信頼感向上を狙った.

5.実装

5.1 外装

本体のベースとして選んだのはグローブ・トロッター社のカーボン製スーツケースである.4輪であったこと,頑強な作りであったことなども理由だったが,非常にスタイリッシュだったことも理由である.このスーツケースをデザインした日本人インダストリアルデザイナー吉本英樹氏と縁があり,スーツケースに合わせたフレームやハンドル,センサカバーをデザインしていただいた.このデザインにより社会に対して「視覚障がい者が街に馴染んでカッコよく歩く」というコンセプトを明確に示すことができた.

5.2 駆動系

AIスーツケース本体は通常の早歩きの速度,時速6km程度の速度で走行し,特に街中にある点字ブロックを乗り越えることができる必要がある.現在の本体はブラシレスモータで3インチのホイールを直接駆動している.この駆動系では点字ブロックを乗り越えるときに大きく左右に揺れることになるが,人が常に手で触れているため,横揺れを抑えて乗り越えることが可能である.今後,障害物乗り越え時の横揺れを起こさない設計にするためにはホイールを大きくする必要がある.しかし,駆動に必要なトルク,つまりモータも大きくなるため,重量やサイズとのトレードオフになる.

5.3 測位技術

AIスーツケース本体には複数の階がある屋内環境で高精度に位置を推定することが可能なシステムが実装されている.第2章で述べたように,位置推定にはさまざまな手法があるが,開発段階では動作の確実性を重視し,LiDAR(Light Detection and Ranging,光による検知と測距)をメインセンサとして採用した.ある施設内で位置推定を可能にするためには,まず施設内でセンサを設置したスーツケースを移動させながらLiDAR点群,IMU(Inertial Measurement Unit,慣性計測装置),Wi-FiやBluetooth LE等の無線通信RSS(Received Signal Strength,受信信号強度)のデータを収集する作業(マッピング)を行う.このとき収集したデータからSLAM (Simultaneous Localization and Mapping)アルゴリズムによって高精度なLiDAR点群マップおよび電波強度マップ(RSSと位置の対応のデータベース)を得る.位置推定を行う際には,測定したRSSを電波強度マップと照合し精度15m程度で大まかに位置を絞り込んだ後,LiDAR点群を点群マップと位置合わせをして数cm〜10cmの精度で姿勢(位置と方向)を計算する.その後はLiDAR点群とIMUで姿勢の移動を追跡する.AIスーツケースは空港や商業施設など,複数の階を持ち面積も広い環境で使用される.そのような環境をサポートするため,RSSと高度計を利用して階を切り替えたり,広い面積のフロアを分割してマッピングしておき必要に応じて切り替えたりする拡張が施されている.

屋内環境に加えてAIスーツケースを屋外環境で利用するための開発も進めている.屋外ではLiDARとIMUに加え,RTK(Real-Time Kinematics)を組み合わせて測位を行う.RTKはGPSなどのGNSS(Global Navigation Satellite System,全地球航法衛星システム)の一種で,GNSSの単独測位ではなく基準局を利用する相対測位によってリアルタイムで数cm精度の位置情報が得られる測位方式である.近年,低価格で小型のアンテナ・受信機が入手可能になってきており,AIスーツケースの機能拡張に適していると考え採用した.RTK単体でも高精度の位置が得られるが,ロボットの方位(東西南北)までは確定しないため,LiDAR点群とIMUによる位置推定と組み合わせて利用している.AIスーツケースで屋内と屋外を行き来する際には,屋内・屋外の境界付近でのマップの切り替えが必要になる.屋内外の切り替えは推定した位置およびGNSS電波の受信状況などによって判定している.

5.4 地図情報

AIスーツケースは2つの地図を持っている.1つ目が測位用のマップ(LiDAR点群と電波強度マップ)で,もう1つが目的地への移動経路や周辺施設の情報を管理する「トポロジカルルートマップ(以下ルートマップ)」である.ルートマップは目的地や分岐点などのノードが経路を示す線で結ばれたネットワーク構造をしている.AIスーツケースは目的地をルートマップ上のノードのID番号として与えられ,マップサーバにそこまでの経路を問い合わせる.マップサーバは移動可能な経路のうち最短のものを経路として本体に送信する.本体では経路をエレベーターやドアなど建物の構造によって分割し,各中間地点を最小コスト経路のゴールとするナビゲーションを繰り返す.単純に最小コストを計算すると,曲がり角に面した店舗の中を通過したり,通路を斜めに走行してしまうため,おおむね指定されたルートに従うようにコストを調整した上で探索を実施する.こうしたルートマップには後述する行列になる可能性がある場所など動作に必要な情報が入力可能である.また,お店の名前や棚の商品など視覚障がい者を案内するための情報も入力ができる.こうした情報はその施設の知識を持った人が作成する必要があるのは自明である.そのため,こうしたルートマップを作成するための編集ツールを開発して効率化を図っている.

5.5 人・障害物回避

前述のお店を通過しない,通路を斜めに走らないといったルールはAIスーツケース本体と視覚障がい者の移動がより自然な行動になるようにするためのルールであるが,歩行者や障害物の回避においても同様の自然さの実現が理想である.AIスーツケース本体にはLiDARセンサが搭載されており,可能な限り衝突を回避するようにナビゲーションが制御される.またRGB-Dカメラを使って周囲の歩行者の位置や移動方向・速度を予測することで,自然な移動になるように工夫している.自律移動ロボットは工場や倉庫など,人や障害物の回避の必要が少ない環境で多く利用されてきたが,近年は自動運転,自動配達など歩行者や障害物等がダイナミックに変化する環境に適応しつつある.AIスーツケースが対象としている公共空間においては,空港の搭乗カウンター付近のような歩行者の密度が非常に高い空間を通過する必要性があり,周囲に合わせて自然に移動するためには,さらなる研究開発が必要である.現状ではAIとヒューリスティック(経験則)を組み合わせたシステム全体の動作を俯瞰したトップダウンによる実装であるが,実際の測定データを用いた完全なボトムアップによる「自然な移動」の学習は非常に興味深い研究テーマである.

5.6 ハンドル

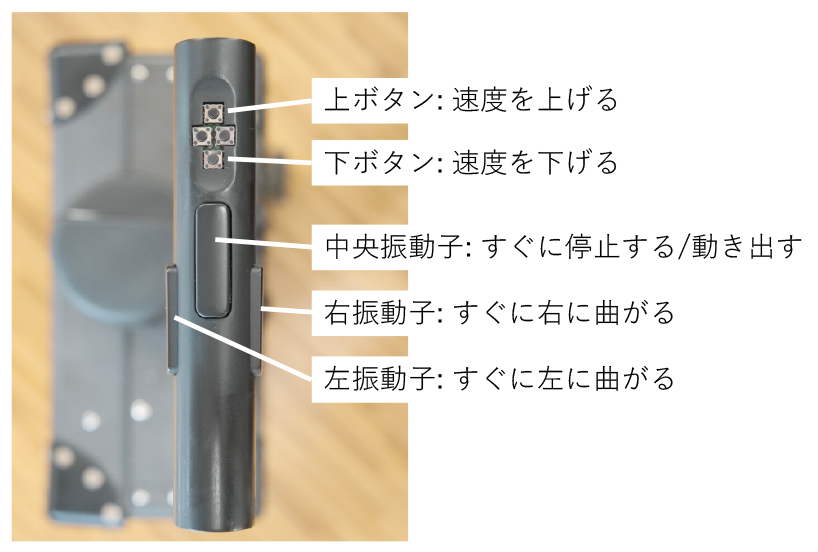

ハンドル(図3)には上部と左右側面の3カ所に振動提示部があり,底面にはタッチセンサを配置している.振動部はバネやウレタンフォームのような振動が伝わりにくい素材を介してハンドルに固定することで,ハンドル本体が振動してそれぞれの振動が区別できない問題を解消している.視覚障がい者に参加していただいたユーザ実験では,3カ所の振動子を使った計5種類の振動パターンを歩行中でも間違いなく認識できることを確認した.タッチセンサは前述のとおり,ユーザがハンドルを握っているかを判定して本体の動作を制御するものであるが,開発途中ではモータコントローラーがノイズ源となって誤動作する現象が発生した.そのため,安定してタッチを検出するためには総合的なノイズ対策が重要である.

5.7 バックパック

AIスーツケース本体はユーザとの直接の接点が手のひらだけに限られ,物理的に音声インタラクションのための口・耳からも遠い.また,本体に設置したカメラはユーザの視線から遠く,体の向きに応じた視野画像を得ることも難しい.そのため,当初から本体と連携するバックパックを用いてインタラクションを補完する方針をとった(図4).カメラ映像で周囲を認識し,ユーザに音声と振動で情報を伝達するバックパックを作成した.バックパックは,肩に装着しユーザの前方を撮影するカメラ,画像認識処理をするパソコンを格納したバックパック,情報伝達のための振動子とスピーカで構成される.

音声・振動提示

後述の人・マスク認識の結果をユーザに通知することを目的に,バックパックには音声提示・振動提示によるフィードバック機能を実装した.音声提示では肩口に取付けられたスピーカにより「右5メートル先に○○さんがいます」のような合成音声によるアナウンスを行う.音声提示にはワイヤレスヘッドホンのような機器が使われることが多いが,耳を覆うことで非視覚的なランドマークの役割も果たす重要な情報である周囲の音(環境音)が遮られてしまうという大きな課題がある☆2.そのため今回はバックパックに直接スピーカを取り付けることとした.スピーカを採用するにあたり,ユーザの聴覚や周囲への影響を少なくするため,取付位置・指向性・音量などについて配慮する必要があった.

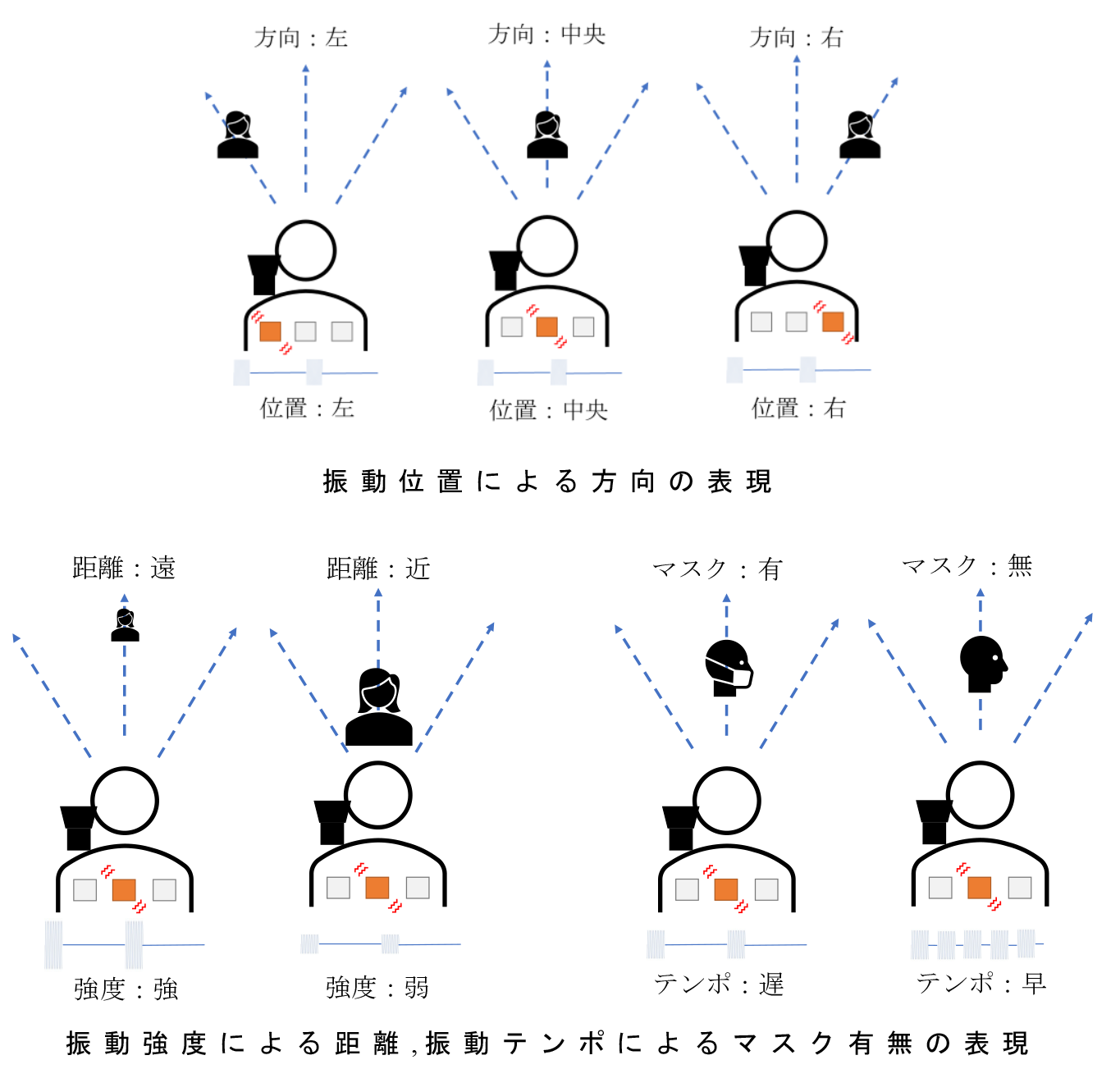

振動提示ではバックパック背面に取り付けられた3つの振動子により,触覚で人の位置や状態を伝える.図5に示すとおり,人の位置は振動パターンで表現され,たとえばユーザに向かって左側に人がいることをシステムが認識した場合,左側の振動子が振動し,対象との距離に応じて振動の強さが変化する.また,人のマスク有無等によって振動テンポを変化させることで人の状態を通知することができる.振動子は自由な位置に張り替えることができる.これによりユーザの体型等に合わせた調整が可能となり,背中に対し安定して振動子を接触させることができる.

人・マスク認識

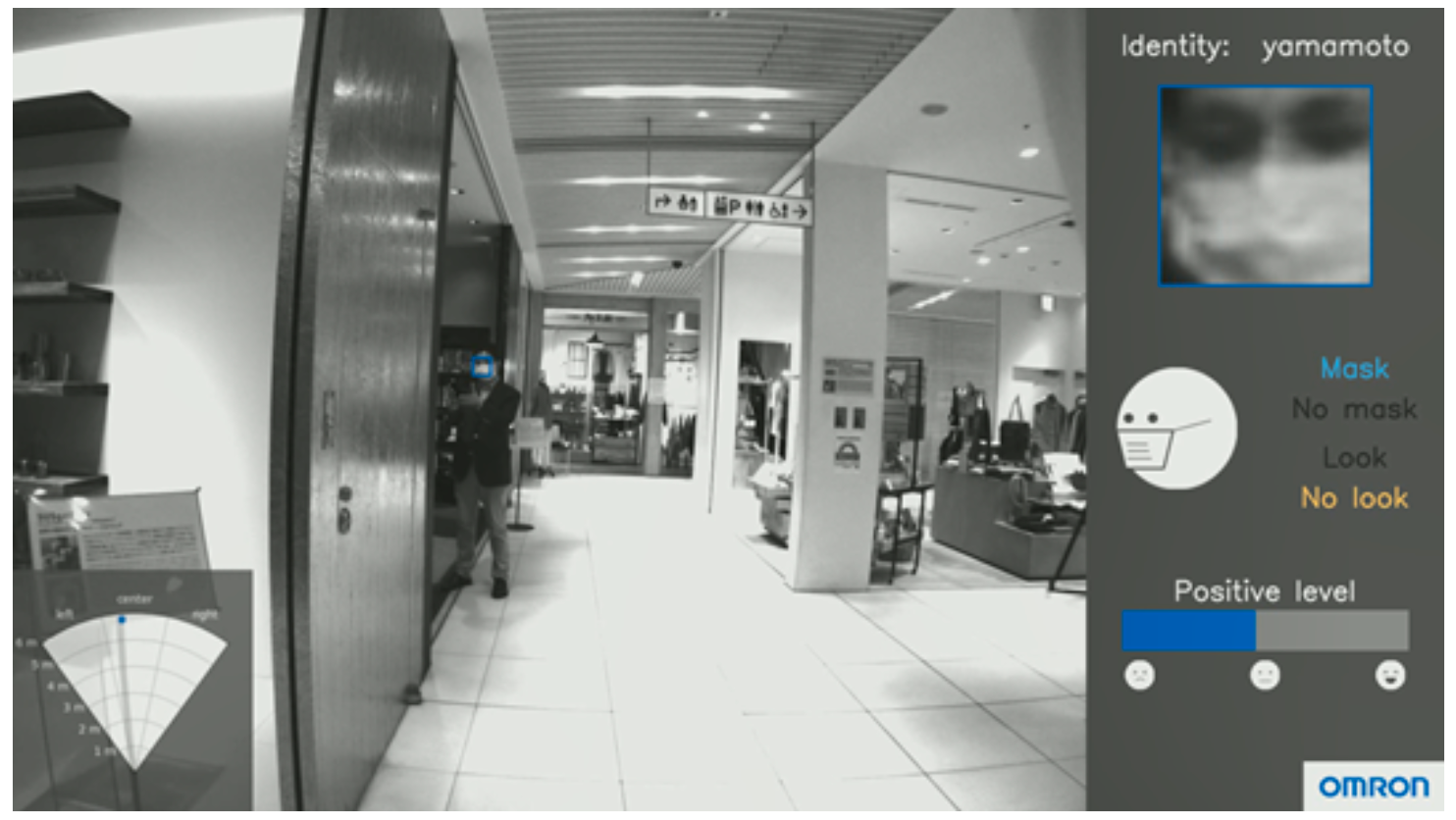

バックパックには周囲にいる人の存在や状態を推定する画像認識機能を実装した.具体的には,カメラ前方に存在する人の方向や距離を推定する機能に加え,その人が知人であるかどうか(顔認証),笑っているかどうか(表情推定),こちらを見ているかどうか(顔向き推定)といった詳細な状態を推定する機能である.ユーザの肩にのせたカメラを通して撮影される低解像度の顔画像から最大約6メートルの遠距離でこれらの情報を推定するために,深層学習を用いた超解像(低解像度の画像から高解像度の画像を生成する技術)と画像認識を組み合わせて高精度な推定を実現している.加えて,パンデミックで日常化したマスク着用に対応するため,各画像認識の機能強化とマスク着用の有無を識別する機能追加を実施した.

視覚障がい者がバックパックを活用して知人を発見し挨拶する技術デモは,第3章で記載したコンソーシアムのWebページで動画が公開されている.その1シーンを図6に示す.図6は約6メートル左前方に存在する知人(yamamoto)が,マスクを着用し,こちらを向いておらず,普通の表情であることを示している.

公共空間での顔認証の適用は今なお社会の理解が必要な課題であるため,実証実験では使用していない.この課題については7.3節で改めて議論する.

6.評価実験

これまでに参加している各組織においてさまざまな評価実験を行ってきた.CMUおよび日本橋室町地区,日本科学未来館においては実際の利用環境に近い状況で視覚障がい者が利用する実証実験が行われている(6.1節).アルプスアルパイン社は仙台においてバックパックの振動子による振動パターンの評価実験を行い(6.2節),オムロン社は京都において画像認識によるナビゲーション技術の検証を行った(6.3節).

6.1 日本科学未来館における実証実験

概要

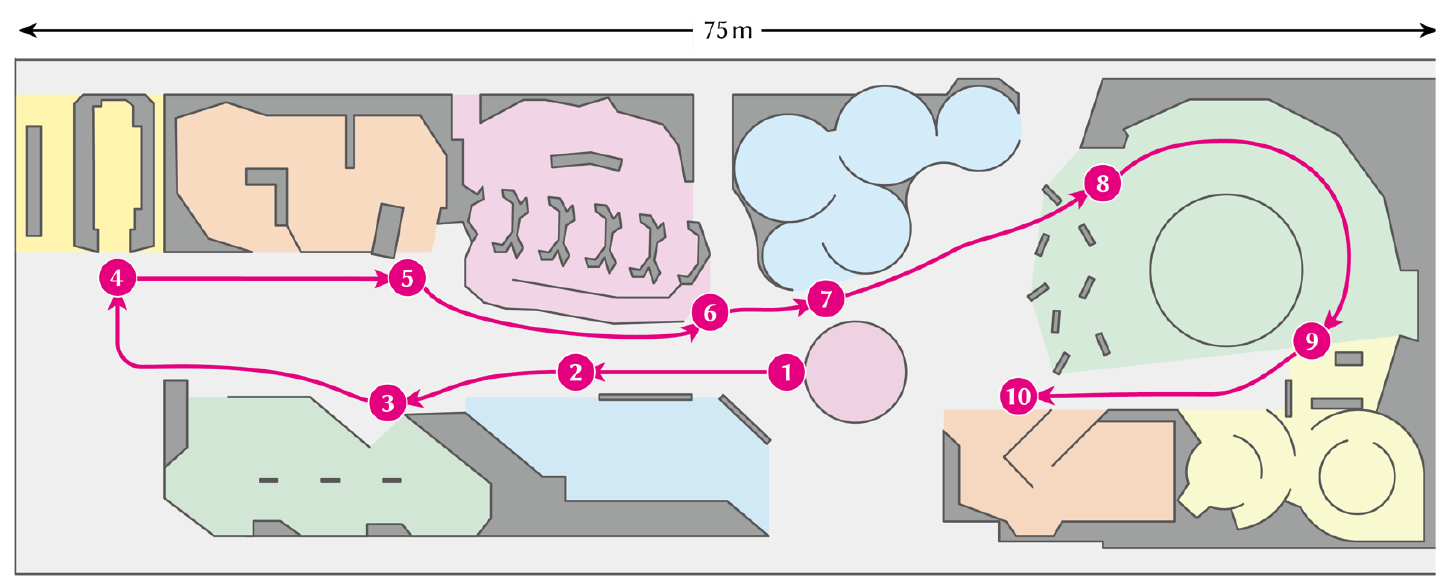

日本科学未来館では実証実験として,視覚障がい者がロボットによるナビゲーション技術を体験するとともに,科学館の展示を独力で自立して体験するという「AIスーツケース体験会」を継続して実施している.目的地へナビゲーションするだけではなく,一連の目的地をツアーとして回る機能を実装した.これにより未来館の5階フロアの約10カ所の展示を一巡するツアールート(図7)も可能にしている.また,従来どおり任意の展示を指定して移動することも可能である.来館者はスマートフォンを用いて特定の目的地を選択するか,ツアールートを選択する.移動中は移動先の展示に関する概要が音声で説明されるため,展示内容を確認しながら館内を移動することができる.また向かう先の展示内容に興味がある場合は,各展示の入り口に到着した際,展示内容の詳細について聞くこともできる.実証実験として,一連の展示を回るツアーや,フロアを自由に歩き興味のある展示を楽しむ実験などを実施し,2022年7月末現在のべ50名以上の視覚障がい者が体験した.

結果

参加者からは独力で展示を選んで移動できるという自由が得られることに対して肯定的なコメントが得られている.また障害物やほかの来館者をロボットが避けて移動することに対する安心感に関してもコメントが多い.一部を以下に紹介する.

- 女性(20代)

「自分のペースで好きな順に好みの展示を回ることができた.友人と一緒に行くとたとえば自分が行きたくても相手が興味ない場合は気を使ったりするが,ロボットだと好きな展示を自分が満足するだけ回ることができた.」 - 女性(30代)

「自分でどの展示へ行くか決める,自分のペースでフロアを移動するという体験は初めてのことで楽しかった.」 - 男性(50代)

「人がいる環境でもきちんと止まったり避けたりしてくれたので安心して歩くことができた.」 - 男性(40代)

「次の展示の概要を説明しながら移動する機能は自分が歩いている先に何が分かるのでよかった.移動中も先の展示を考えながら歩くことができた.」

6.2 バックパックによる背中への振動提示

概要

背中への振動提示機能をバックパックシステムに実装するにあたり,振動パターンに対するユーザの知覚傾向を検証することを目的に実験を行った.この実験は2021年6月に公益財団法人宮城県視覚障害者福祉協会および宮城県視覚障害者情報センターの協力の元実施した.被験者は,全盲および弱視である10名(33歳から70歳)を対象とした.実験では,椅子に座った状態でバックパックを装着した被験者の背中に任意の振動パターンを提示し,振動の位置や振動テンポ変化の有無を回答してもらい,正解率を元に知覚傾向を分析した.実験後にはアンケートを実施し,バックパックの振動提示機能の有効性について主観的な意見を確認した.

結果

実験の結果,左・中央・右の振動位置は全被験者100%の精度で識別でき,振動で人の位置を通知する機能の実装は可能であることを確認した.振動テンポの変化についても被験者平均90%以上の識別精度を示す設定値を得ることができ,これを振動テンポ変化の限度値にすることでバックパックに実装する振動パターン設計に対する指針を得ることができた.アンケートからは振動による背中への情報提示に対しておおむね好意的な評価が得られたことで,主観・客観両面からバックパックにおける背中への振動提示機能は有効であることが確認できた.得られた意見の中には聴覚を塞がず・騒音下にあっても情報を得られる等といった振動提示の優位性に関するものも多く,実用性・ニーズの面からも触覚による情報伝達技術が重要であることを確認できた.

6.3 人・マスク認識に基づく誘導

概要

画像認識で推定した情報を音声・振動で伝達するバックパックの機能で,視覚障がい者の移動をナビゲートできることを検証するために実験を実施した.実験は2021年12月~2022年1月に社会福祉法人京都ライトハウスの協力の元で実施した.被験者は,視覚障がい者の中でも,自身の前方にある物体を視認できない全盲および重度弱視者(視力を測定できないが光を感じることができる)である8名(28歳から63歳)を対象とした.この実験では,前方7メートルにパーティション越しに立っている人の位置・方向・マスク着用状態をバックパックで認識し,その人がマスク着用時は右へ回避,未着用時は左へ回避して移動するタスクを設定した.1人あたり6回,全被験者の合計で48回のこのタスクを実施した.

結果

全タスクにおいて被験者はバックパックの伝達する情報と一致する方向へ回避しながら移動することができ,バックパックで移動をナビゲートできることが確認できた.この実験での被験者が移動する様子を図8に示す.

実験後のアンケートでは,振動提示で環境音を遮ることなく情報を取得できることについて肯定的なコメントが得られた.一方で,PCを搭載するバックパックの重量については否定的なコメントが得られた.

7.普及に向けて

AIスーツケースを実際に普及させるためには価格の低減と利用者へ提供するためのビジネスモデルを確立する必要がある.また周囲の動きを認識する社会的動作や屋外走行に関する技術的課題も存在している.さらに公共空間で周囲の人々に受け入れられるための技術的工夫だけではなく,啓蒙活動なども欠かせない.制度やインフラの整備も欠かすことはできない.本章ではこうした課題を俯瞰するとともに解決に向けた方向性を議論する.

7.1 価格とビジネスモデル

価格

前述のようにAIスーツケースでは価格を下げるために,利用者が必要に応じてロボットをサポートするデザインとしている.また,センサなどはほかのロボットや自動運転自動車と共通なものが多く,マーケットの拡大につれて徐々に価格も低下してきている.特に最も高価なLiDARセンサは開発当初と比較して現在は数分の1の価格で手に入るようになってきている.コンソーシアムメンバである清水建設においては,3次元計測を行うLiDARセンサの代わりに,より廉価な2次元測域センサ(2次元LiDAR)を用いたAIスーツケースも試作されている.ソフトウェア開発でハードウェア機能を代替することにより,量産時の単価を下げる検討も行っている.着実に価格を下げる方向に技術開発を行っており,最終的にはおそらく一般向け乗用車のような金額感が目標になるであろう.

ビジネスモデル

AIスーツケースを実際に提供するビジネスモデルを検討する上で,既存の障がい者支援モデルが参考となる.たとえば盲導犬は寄付と政府からの援助によって育成と提供が行われており,利用者は利用料金を支払う必要がない.日常の世話や餌代は負担する必要がある.このように寄付によって無償もしくは低価格で提供するというモデルが考えられる.また,空港で貸し出している車椅子のように,公共施設に配備してユーザに貸し出す「レンタルモデル」も考えられる.公共施設がサービスの一環として導入することで個人向けよりもコストモデルが成立する可能性が高くなる.また,施設内に限定してリスクアセスメントを行い,さまざまな対策をとることも可能になる.これ以外にも個人向けサービスロボットの普及に際しては公的な補助も含めて今後もさまざまなビジネスモデルが検討されるであろう.今後もこうした動きに対しても知見を提供していきたい.

7.2 技術的課題

社会的行動

普及に向けては公共空間を社会的な習慣に則って行動する必要がある.前述したように行列もその1つである.行列に並ぶためには行列が存在していること,最後尾,前の人との適切な距離,行列の先頭に来たことを認識する必要がある.現在は,レジの前など行列ができる可能性がある経路を地図情報として持つことで実現しており,行列を事前情報なしに認識することはできていない.一般的な行列の認識には大量のデータが必要になるが,公共空間での画像取得の難しさが大きな課題である.また,パンデミックによりソーシャルディスタンスを開けて列に並ぶ習慣が広まったことで,以前とは行列の形状が変化している点もデータ蓄積においては課題となる.このように,常に変化する公共空間における社会的な習慣やルールに合わせるため,今後も継続的なデータの収集と技術開発が必要である.

屋内外走行

AIスーツケースの当初からの目標の1つ「視覚障がい者の旅のお供になる」を実現するためには交通機関から目的地といった「屋外」を走行できる必要がある.5.3節で紹介したように屋外での測位技術を組み合わせたプロトタイプを作成し,屋外走行の初期実験にも成功している.本格的に屋外走行を行うためには道路の段差に対応した駆動系の改良,日差しの下での人・障害物回避性能の検証,アスファルトに対応した振動提示の検討,長距離走行時のバッテリ持続時間,長距離走行時のユーザビリティなどさまざまな検証・改良を行う必要がある.

7.3 社会の理解

目立たない自由

前述のトーマス・キャロルの「20の喪失」の中に「視覚障害者は目立たないという選択肢を失う」という一節がある.公共の場所で白杖や盲導犬を使っていれば必ず目立ってしまう.また,周囲のサポートを得るためには視覚障がい者であることが分かる必要がある.現に日本の道路交通法では第14条で視覚障がい者は公共の場所では「白杖もしくは盲導犬」を使うことが定められている.しかし,目立たないで「溶け込んで」歩くことを切望している視覚障がい者が数多く存在していることも事実である.従来の白杖や盲導犬による歩行では,周囲のサポートを必要とする場面が多々存在するため,目立たないという選択肢を選ぶことは難しかった.しかしAIスーツケースが完成すればほぼ確実に目的地に到達することができるようになる.つまり,技術によって視覚障がい者が「目立たない」という現実的な選択肢を現実のものとすることができる.日本の社会では公共施設の管理者を中心として「安全のために視覚障がい者は目立つべきである」という考えが広く浸透している.新たな技術が出現しつつある今,いかに目立たないことを社会が許容できるかが近い将来大きな課題になる.

社会的受容性(Social Acceptance)

街中で知人を見つけて挨拶をするのは健常者にとっては日常の振る舞いであろう.視覚障がい者も顔認証技術の力を借りることで実現可能である.しかながら現在のところ公共空間での不特定多数に対する顔認証技術の使用に関しては社会的な理解が得られている状況ではなく,AIスーツケースにも実装されていない.顔認証に対するもともとの批判は監視カメラなどで顔を認識することで行動が把握されプライバシーが侵害されるという懸念が理由であった.視覚障がい者にとって,周囲の人の行動把握が目的ではなく,晴眼者(視覚に障害のない者)が当たり前に行っている社会的行動を可能にするために必要な技術である.認識結果を保存しないなどの技術的対応も可能である.そのため,どうすれば社会に受け入れられるか「社会的受容(Social Acceptance)」が重要な研究課題になっている.Lee[6]らの研究では視覚障がい者がアクセシビリティ用途で顔認証技術を使った場合,プライバシーの不安を感じる人の割合が大幅に低下することが分かった.またクラウドに画像を送らない形で顔認証を実装している視覚障がい者用の眼鏡型デバイスも普及しつつある.これ以外にも自律移動ロボットが人や車に衝突する可能性などの安全性に関しても社会的な受容が必要である.こうした技術に関しては技術開発や運用時の配慮とともに,社会的受容を目指した情報発信を継続していく必要があると考えている.

7.4 制度の整備

横断歩道

AIスーツケースの屋外走行におけるチャレンジの1つが横断歩道の横断である.横断歩道を渡るためには信号を確認しなければならないが,現在ナビゲーションロボットが横断歩道の信号を確認する標準は確立されていない.車道を走行する自動運転自動車については高度道路交通システム(ITS)の一部として信号の情報を送信するための標準が確立され,日本でも実証実験が行われている.しかし,歩行者のための信号に関しては標準が定まっておらず,一部でロボットの横断実験や視覚障がい者のためにスマートフォンに配信するサービスの実験が始まったところである[7].自動運転自動車の産業規模を考えるとITSはハイペースな普及が予測されるが,歩行者向け信号の情報送信に関しては遅れている.電波による送信が普及しない場合,画像認識技術のみで信号色を認識する必要があるが,日光,信号までの距離,複数の信号が視界に入る場合の判別などさまざまな要因で認識精度は影響を受ける.今後は,配送ロボットなど歩道を自律的に走行するロボットの用途も広がるであろう.技術標準の確立や関連した制度の整備に期待したい.

技術標準

AIスーツケースの社会実装を進めるための技術標準の整備も課題である.たとえば5.4節で示したルートマップが標準化できれば,建物側でこうした情報をあらかじめ準備することができ,実装コストを下げることができる.これによりAIスーツケースのみならず屋内での自律型支援ロボットの普及が促進できる.エレベーターの呼び出しやセキュリティドアの通過なども現状ではボタン操作や入管証の提示が必要である.建物側とロボット側が連携するための技術標準が必要となっており,清水建設では実際に試作が行われている.

国際標準化機構のISO 13482はサービスロボットの安全規格を策定している[8].この中でサービスロボットは1)自律移動型,2)人間装着型,3)搭乗型に分類されている.しかし,AIスーツケースのような「人を案内する」ナビゲーションロボットはどの分類にも直接は当てはまらず,周囲の環境を観測しながらの自律走行,ハンドルの接触を通した使用者との情報伝達,目的地までの移動支援とすべての分類の要素が部分的に含まれている.そのため実際の普及に向けたリスクアセスメントや安全基準を世界的な標準を基に独自に策定していく必要がある.将来的にはこうしたナビゲーションロボットに関しても国際的な標準が確立され,普及の後押しとなることを期待したい.

8.社会実装を目指して

本稿では構想から実証実験に足るモデルの開発に至るまで,筆者らの4年以上にわたる視覚障がい者ナビゲーションロボット「AIスーツケース」の開発経験をまとめるとともに普及に向けた課題について検討した.当初の思いつきは視覚障がい者のシンプルな日常の経験からであった.しかし,自立した街歩きを望む視覚障がい者の希望が後押しする形で大きく注目を集めることになった.周囲の歩行者の社会的行動の理解,屋内外のシームレスな移動など技術的な課題もまだ多い.同時に「視覚障がい者が街に馴染んでカッコよく歩く」というコンセプトは現在の制度に一石を投じるものであり,社会の側の変化が必要になる.また,顔認証技術の使用,歩行者信号の情報,安全規格など社会的・制度的な課題も存在している.現在は新たなAIスーツケースを開発するとともにより広いエリアで,想定されている運用形態の1つであるレンタルモデルに近い形での実証実験も計画している.また開発したソフトウェアだけでなくハードウェアの設計情報も含めてオープンソースとして公開している.こうして蓄積した情報が視覚障がい者の移動環境を近い将来大きく改善し,最終的には高齢者などほかの移動弱者支援に活用されることを関係者一同希求している.

参考文献

- 1)Carroll, T. : Blindness What It Is, What It Does and How to Live (1961).

- 2)Murata, M., Ahmetovic, D., Sato, D., Takagi, H., Kitani, K. M. and Asakawa, C. : Smartphone-based Indoor Localization for Blind Navigation Across Building Complexes, In 2018 IEEE International Conference on Pervasive Computing and Communications (PerCom), IEEE (2018).

- 3)Xu, M., Wang, Y., Xu, B., Zhang, J., Ren, J., Poslad, S. and Xu, P. : A Critical Analysis of Image-based Camera Pose Estimation Techniques, arXiv preprint arXiv : 2201.05816 (2022).

- 4)日本視覚障害者ICTネットワーク:第1回支援技術利用状況調査報告書,JBICT.Net,調査,https://jbict.net/survey/at-survey-01 (2022年7月29日現在)

- 5)Guerreiro, J., Sato, D., Asakawa, S., Dong, H., Kitani, K. M. and Asakawa, C. : Cabot : Designing and Evaluating an Autonomous Navigation Robot for Blind People, In The 21st International ACM SIGACCESS Conference on Computers and Accessibility, pp.68-82 (2019).

- 6)Lee, K., Sato, D., Asakawa, S., Kacorri, H. and Asakawa, C. : Pedestrian Detection with Wearable Cameras for the Blind : A Two-way Perspective, In Proceedings of the 2020 CHI Conference on Human Factors in Computing Systems (2020).

- 7)信号と連動して道路を横断.エレベーターで別フロアに配達.竹芝で進む配送ロボット実証実験,ソフトバンクニュース,https://www.softbank.jp/sbnews/entry/20210616_01 (2022年7月29日現在)

- 8)一般財団法人日本品質保証機構:サービスロボット(ISO 13482),https://www.jqa.jp/service_list/fs/service/13482/ (2022年7月29日現在)

脚注

- ☆1 https://caamp.jp/

- ☆2 視覚障がい者のナビゲーション用途では骨振動型など,周囲の環境音も聞くことができるヘッドセットが用いられることが多い.

高木啓伸(非会員)takagih@jp.ibm.com

1999年日本アイ・ビー・エム(株)入社.以来,東京基礎研究所にてアクセシビリティ技術の研究開発に従事.2008年情報処理学会喜安記念業績賞受賞.2021年より日本科学未来館副館長を兼務.博士(理学).

村田将之(非会員)muratams@jp.ibm.com

2013年,東京工業大学大学院理工学研究科機械物理工学専攻修士課程修了.同年,日本アイ・ビー・エム(株)入社.東京基礎研究所にて視覚障がい者ナビゲーションの研究開発に従事.

佐藤大介(正会員)daisukes@cs.cmu.edu

カーネギーメロン大学シニアプロジェクトサイエンティスト.2005年日本アイ・ビー・エム(株)入社.以来,東京基礎研究所でアクセシビリティ技術の研究開発に従事.2018年より現職でAIスーツケースの研究開発に従事.博士(工学).

田中俊也(非会員)shunya.tanaka@alpsalpine.com

2009年アルプス電気(株)(現アルプスアルパイン(株))入社.AIスーツケースを始めとした障がい者支援技術に関する研究やシステム開発に従事.

籔内智浩(非会員)tomohiro.yabuuchi@omron.com

2005年,京都大学学術情報メディアセンタ日本学術振興会特別研究員.2010年,大阪工業大学特任講師.2016年,オムロン(株)入社,現在に至る.人認識・理解のための画像処理,機械学習の研究に従事.

粥川青汰(非会員)seita.kayukawa@lab.miraikan.jst.go.jp

早稲田大学先進理工学研究科,後期博士課程.2020年より日本学術振興会特別研究員(DC1),2021年より日本科学未来館研究員を兼務.視覚障がい者の移動支援に関する研究に従事.

木村駿介(非会員)kimura.shunsuke@shimz.co.jp

2018年清水建設(株)入社.技術研究所にて制御工学の研究,および自律移動ロボットやロボット運用システムの開発に従事.博士(工学).

採録決定:2022年8月23日

編集担当:除補 由紀子(NTT ソフトウェアイノベーションセンタ)