カメラ以外のセンサと学習用データの事前登録が不要なフィジカルサーチシステムの提案と検証

Proposal and Verification of a Physical Search System that does not Require Pre-learning Data and Sensors Other than Cameras

1. はじめに

住環境の中にセンサやアクチュエータを組み込んで環境知能化し,人間の状況を観察しながら有益な支援を提供するスマートホームの研究が長年行われ,多くのスマートホーム技術が商用化されてきた[1].佐藤らのロボティックルーム[2]は,人間の行動から意図を理解し,ロングリーチマニピュレータがコーヒー缶を持ってくる.さらに500個を超えるセンサを備えたセンシングルームが構築され,人間の行動異変を検知するようになった[3].しかし,多様なセンサ類や複数の情報キャリアなどの相互運用性が低く,ユニバーサルへの配慮,デバイスの使いやすさなどの問題により,スマートホームのサービスがシームレスに提供できていない[4].

そこで,インターネットを通じて,現実空間(フィジカル空間)の情報を仮想空間(サイバー空間)でスムーズに取り扱うためのCyber-Physical System [5](以下,CPSと記す)が提案されている[6].情報を取得する多数のセンサ,アクチュエータ,制御デバイスなどがネットワークによって接続され,フィジカル空間での情報を分析し,その結果を仮想空間に適用する分散制御システムである[7].サイバー空間とフィジカル空間を高度に融合させるために,様々なワイヤレス信号を変換する“Intelligent Control Box [8]”,人工知能により様々な気象条件での障害物検知[9],センシングデータを自己組織化Wi-Fiネットワークを備えたシステムで収集する方法[10]などの研究が行われている.

実用的にはセンサの数や設置する箇所には制限がある.たとえば,紛失物の場所を特定するために,各物体にセンサ(Apple “Air Tag”など)をつける方法がある.しかし,家の中などの限られた空間であっても,すべての物体にセンサをつけることは現実的ではない.近年,ディープラーニング技術の進歩により,カメラ画像から物体の特定が容易になってきた.田中ら[11]は,物体認識ライブラリ“YOLO [12]”で既知の物体を検出し,人物姿勢推定ライブラリ“OpenPose [13]”を用いて,人物の手の位置からその物体への操作の有無を判定することにより,物体の置き忘れを検出する方法を提案した.しかし,対象とする物体はYOLOなどであらかじめ登録された(学習された)物体に限られており,CPSで扱うすべての物体を検知するための「事前学習用データ」を準備することは難しい.

筆者らはこれまでに,事前学習用データなしに,撮影された範囲内で“移動した”あらゆる物体の画像を自動で切り出し保存する手法として,差分検知による移動物体抽出手法[14]と,切り出された小さい物体画像を分類する手法[15]を提案してきた.しかしこれらはまだ,実社会で実践したものではない.

そこで本稿では,事前学習用データを一切必要とせずに,フィジカル空間で移動したあらゆる物体を,2台のカメラで検知して検索できる“Physical Search System(以下,PSS)”を提案し,構築する.通常,インターネット上やコンピュータ内のデータなど,サイバー空間のデータを検索する場合には,キーワード検索や画像検索が用いられている.一方,フィジカル空間で物体を捜索する場合には,事前にセンサの取り付けや画像の事前学習をしたシステムが必要であり,容易に検索できるものではなかった.本稿で提案するPSSでは,カメラ以外のセンサや事前学習用データを一切必要とせず,フィジカル空間内において移動したあらゆる物体に対して検索ができるようにする.

本稿の2章で,PSSを提案し,そのコンセプトと実装方法を述べる.3章で,倉庫を模した環境とオフィスデスクを模した環境における評価実験とその結果について述べる.4章で,社会実装の第一段階として,大学図書室に実装したプラクティスと,第7筆者の職場のデスクにPSSを約1か月間設置したプラクティスの結果について述べる.5章で,プラクティスから明らかになったPSSの有用性と用途,今後の課題とその対策について述べ,6章でまとめる.

2. Physical Search System(PSS)の提案と実装

2.1 PSSのコンセプト

PSSは,ブラウザなどからインターネット上の情報を探す際に用いる検索システムからのアナロジーとして,フィジカル空間の「移動物体」を検索し,表示できるようにするというコンセプトのシステムである.移動物体とは,ある対象範囲に新たに置かれた物体および取り除かれた物体を指す.PSSで比類されるインターネット検索システムの6項目を以下に述べる.

<インターネット検索システム>

- (a)検索システムは,サイバー空間上の膨大な情報を,ユーザの関与しない状態で自動的に集め,記録しておく.

- (b)検索システムは,記録された情報に対し,含まれるキーワードや更新日時,使用言語などを検索タグとしてラベル付けしておく.

- (c)検索システムは,インターネット上にあるすべての情報が検索可能であることを保証するものではないが,ユーザにとって有用な情報を提供する可能性を高めるため,大量の情報を保持する.

- (d)ユーザは,大量の情報から目的の検索結果を得る手段として,情報に含まれるキーワードや情報の更新日時,使用言語などで絞り込んで表示する.絞り込み方法は,用意されている複数の方法から.各ユーザが任意で選択して用いる.

- (e)ユーザは,検索システムを,特定のURLにある情報を探す目的で利用しても良いし,似たような内容の情報を探す目的で利用しても良い.

- (f)検索システムで表示される検索結果は,過去のある時点での情報であり,現時点での情報はリンク先を表示して確認する.

PSSは,上記をアナロジーとするフィジカル空間上での移動物体の検索システムとして,以下のコンセプトで提案される.

<Physical Search System(PSS)>

- (a)PSSは,フィジカル空間上で移動した様々な物体のデータを,ユーザの関与しない状態で自動的に集め,記録しておく.

- (b)PSSは,記録された移動物体のデータに対し,特徴量をもとにした「特徴量分類番号(2.5節)」や含まれる色,移動日時などを検索タグとしてラベル付けしておく.

- (c)PSSは,移動したすべての物体が検索可能であることを保証するものではないが,ユーザにとって有用な情報を提供する可能性を高めるため,大量のデータを保持する.

- (d)ユーザは,大量のデータから目的の検索結果を得る手段として,データの特徴量分類番号や含まれる色,移動日時などで絞り込んで表示する.絞り込み方法は,用意されている複数の方法から.各ユーザが任意で選択して用いる.

- (e)ユーザは,PSSを,特定の物体(たとえば自分のハサミ)を探す目的で利用しても良いし,似たような物体(たとえば他者のハサミ)を探す目的で利用しても良い.

- (f)PSSで表示される検索結果は,過去のある時点での情報であり,現時点での情報は表示された場所で確認する.

PSSのコンセプトは,上記のようにインターネット検索システムからのアナロジーであり,使用目的も使用方法も個々のユーザに強く依存するシステムである.

2.2 PSSの概要

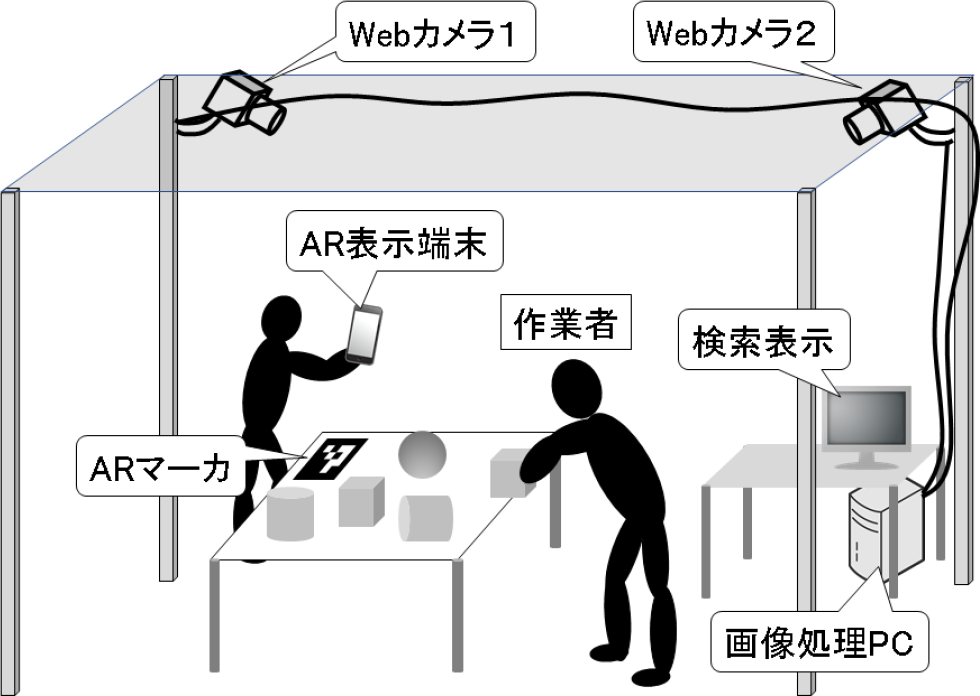

PSSのハードウェア構成(2.3節)は,検索対象範囲を常に撮影し続ける2台のカメラと,カメラで撮影した画像を処理するコンピュータからなる.ソフトウェアは,カメラで撮影された画像から移動物体を切り出す移動物体検知部(2.4節),切り出された移動物体を分類する物体分類部(2.5節),分類された移動物体を検索して表示する検索結果表示部(2.6節)からなる.ユーザが検索結果をAR(Augmented Reality)表示する場合には,ARマーカとAR表示端末を用いてもよい(2.7節).PSSのハードウェア構成を図1に示す.

Fig. 1 The construction of PSS hardware.

2.3 撮影用カメラおよび画像処理用コンピュータ

撮影用カメラ2台は,いずれも,PSSの検索対象範囲全体を撮影できる位置に取り付けられ,コンピュータとUSB接続される.撮影開始時に,2台のWebカメラの撮影範囲内で,1辺が16 cm,1マスが2 cmのチェッカーボードを撮影し,歪み補正をする.また,2台のカメラから映る場所にARマーカを配置し,撮影されたARマーカの画像から,そのマーカを原点とする室内座標系におけるカメラ位置とカメラ方向を取得する.ARマーカは,OpenCVの標準的に利用できるArUcoマーカ[16]を,1辺が12 cmとなるように印刷して用いた.取得された各カメラの位置姿勢情報は,透視投影変換行列としてコンピュータ内に保存した.保存後,ArUcoマーカは撤去するが,カメラの位置や向きを変更した場合は,改めてArUcoマーカを撮影して,透視投影変換行列を再取得する.カメラはコンピュータに接続され,たとえば5秒に1枚などの指定された頻度で画像を常時撮影し,コンピュータに送信する.

本稿で用いたコンピュータは,Dell Precision T1700(OS:Windows 10,プロセッサ:Intel Xeon CPU 3.4 GHz,実装メモリ:16 GB,購入:2013年度)である.カメラは,ロジクール社製のLogicool HD Webcam C270を,HD画質(720p:1280×720)で用いた.なお,2台のカメラは画角や解像度が異なるものを用いても構わないが,解像度が異なる場合は,低いほうの解像度に合わせて処理される.

2.4 移動物体検知部

2.4.1 人物検知アルゴリズム

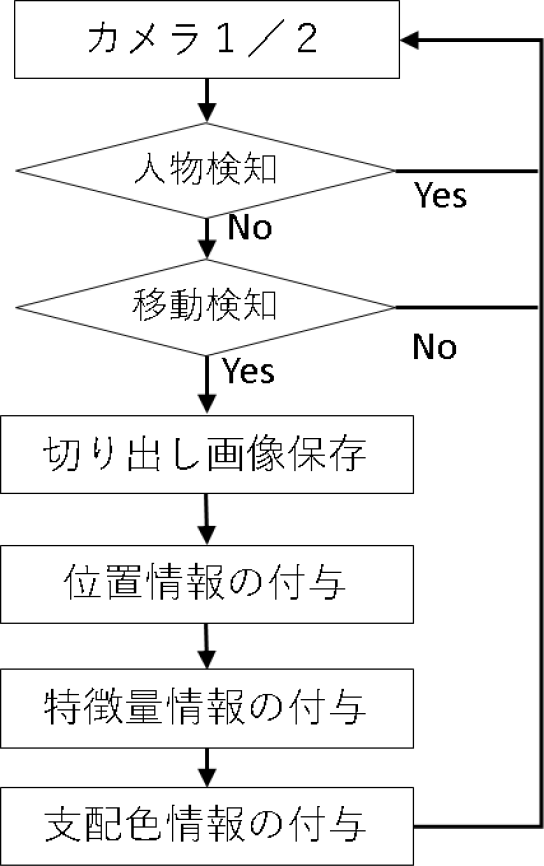

コンピュータは,人物検知アルゴリズムにより,在室モード/不在モードを判別する.2台のカメラで撮影された画像は,YOLO [12]により人検知処理をかける.いずれかのカメラの撮影対象範囲に人物が検知された場合を在室モードとし,人物が検知されない場合を不在モードとする.不在モードの場合,次項の移動物体検知アルゴリズムに進む.一方,在室モードでは,不在モードになるまで,以後の処理は行わない.この理由は,PSSが人物ではなく移動物体の検索が目的であるため,人物やその影などが移動物体として検知されないようにするためである.また,人物を撮影することでプライバシーの問題が発生するリスクを避けるためでもある.

2.4.2 移動物体検知アルゴリズム

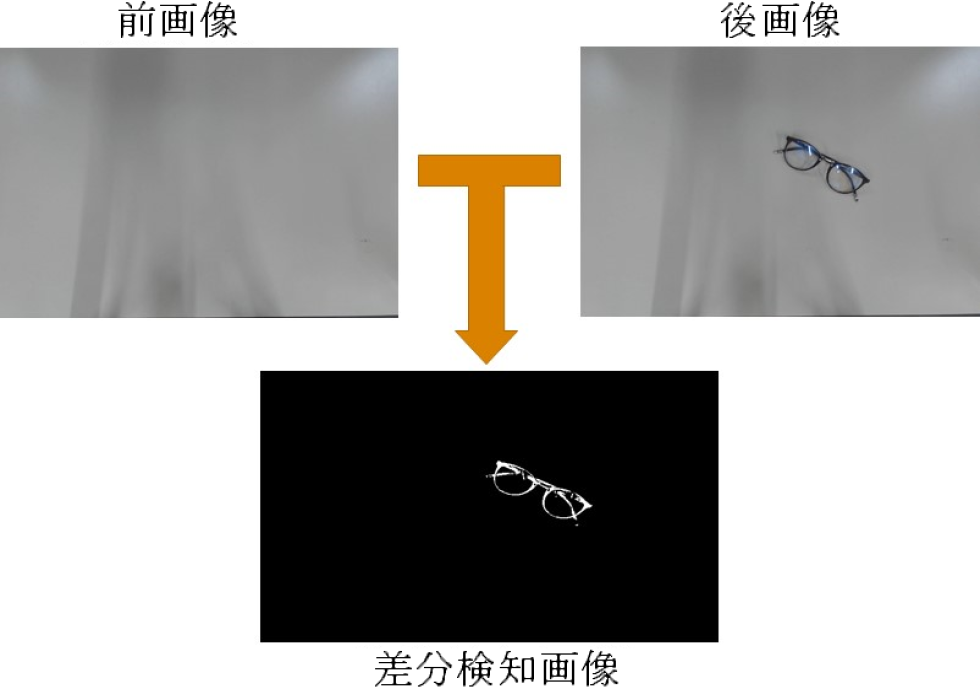

不在モードで撮影された画像は,撮影時刻順に処理される.ある時刻の画像は,1つ前の時刻に撮影された画像と画素レベルで比較され,一定の基準以上の差分のある画素が検出されると,「移動物体が映っている」と判定される.2枚の画像の差分(移動物体に相当する画素)が白く表示された差分検知画像の例を図2に示す.対象範囲内で移動したあらゆる物体の画像をこのように検知する.

Fig. 2 Results of difference detection.

白く表示された画素を含む領域を,移動物体画像として矩形で切り出す[14].切り出された画像は,「移動物体フォルダ」に保存される.このとき,切り出された画像を囲む矩形の中心座標をその物体の画像中の位置とし,画像とともに保存する.

矩形で切り出された画像から,さらに背景を削除した画像を作成する.背景削除に成功した例を図3に示す.2.5節で述べる分類用の画像に使用される.

Fig. 3 Image segmentation with successful detection.

移動物体の誤検知により,切り出しに失敗した主な例を図4と図5に示す.図4は余計な物体が誤検知された例である.図4左の例は,人物の一部が誤検知された例である.図4右の例は,光沢のある本の表紙やフィルム,金属などが反射した光を誤検知して複数の物体をまとめて切り出された結果である.

Fig. 4 Image segmentation with false detection of unnecessary objects.

Fig. 5 Image segmentation with false detection due to light and shadow.

図5は光のあたり方による誤検知が起きた例である.図5左は,机のエッジ部分が光のあたり方の変化で移動物体と誤検知された例である.図5中央は,移動物体の影の部分や背景の模様を含めて移動物体と誤検知した例である.図5右は,暗い場所で移動した黒い物体の一部を移動物体と誤検知した例である.なお,これらの誤検知画像も,2.5節の物体分類部で削除するまで,そのまま保持される.

2.4.3 3次元位置推定アルゴリズム

移動物体の3次元位置は,2台のカメラの位置姿勢情報を示す透視投影変換行列と,前項で述べた各カメラ画像から切り出された移動物体画像の中心座標から求める.

1台のカメラの位置姿勢情報と,そのカメラに映った移動物体画像の中心座標から,移動物体が存在した可能性のある座標が,3次元空間中のカメラを通る直線として算出される.もう1台のカメラからもその移動物体が存在した可能性のある座標を,カメラを通る直線で同様に算出する.これら2本の直線の最短距離を表す線分の中点を,その移動物体の3次元位置として算出する.求められた3次元位置は,画像とともに保存される.

2.5 物体分類部

2.5.1 2段階特徴量分類アルゴリズム

移動物体フォルダに保存された移動物体をResNet50 [17], [18]により2段階に分けて分類する.ResNet50は事前学習済みの畳み込みニューラルネットワークで,画像のデータベースであるImageNet [19]から読み込むことができる[18].このため,ユーザが学習用データを用意する必要はない.

特徴量分類の第1段階では,移動物体の画像を入力サイズ(224×224)にリサイズしてResNet50へ入力し,四次元(1×7×7×2048)の特徴マップ(畳み込み層の出力データ)を取得する.四次元特徴マップを一次元特徴マップ(100352)に平坦化し,「ディープラーニング特徴量」とする.この特徴量をx-means法[20]に適用し,分類する.x-means法とは,k-means法[21]を逐次繰り返し,自動的に決定されたクラスタ数に分類するアルゴリズムである.これにより,正解ラベルのないデータを,事前にクラスタ数を求める必要なく分類ができる.x-means法により決定されたクラスタごとに,分類番号が付与される.すべての移動物体画像に対し,いずれかの分類番号が付与され,付与された分類番号のフォルダに保存される.本稿の実験では,いずれも8~12クラスタに分けられた.

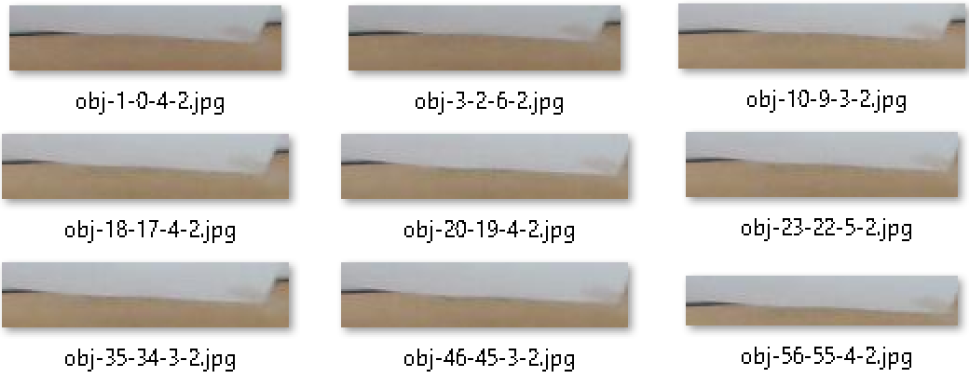

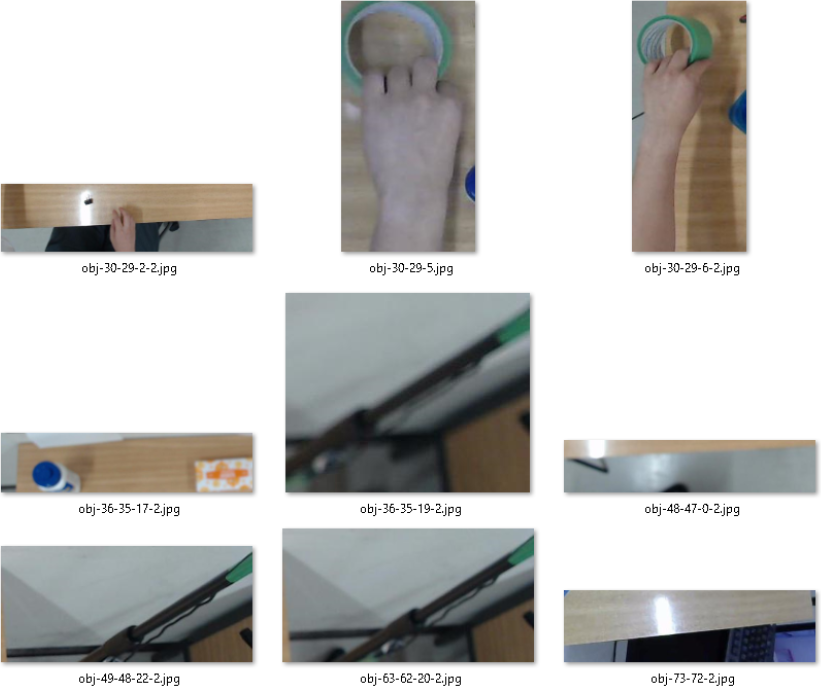

第1段階のクラスタには,移動物体以外のノイズ画像が分類されたクラスタ(ノイズクラスタ)が存在する.図6は机のエッジ部分を移動物体と誤検知して切り出し,分類されたノイズクラスタである.図7は手や照明の映り込みなどを移動物体と誤検知して切り出し,分類されたノイズクラスタである.ユーザは,これらのノイズクラスタを削除ボタンで削除する.本稿の実験では,8~12程度のクラスタのうち,半数程度がノイズクラスタとして削除された.

Fig. 6 The cluster of desk edges were considered a noise cluster.

Fig. 7 The cluster that includes hands or lighting reflection were considered a noise cluster.

ResNet50を用いた特徴量分類の第1段階では,ノイズクラスタ以外のクラスタでも,1つのクラスタに2種類以上の物体が分類される場合が多い.図8は,すべてセロハンテープが分類されたクラスタであるが,図9は,ニッパー,ハサミ,青マジック,赤サインペンが同じクラスタに分類された例である.そこで,第2段階として,ノイズクラスタの画像をすべて削除した後,残されたクラスタの全画像に対し,改めて第1段階と同じ処理を行う.

Fig. 8 The cluster that includes only one type of object.

Fig. 9 The cluster that includes multiple types of objects.

特徴量分類の第2段階の結果,図9に示した複数の種類の物体が分類されていたクラスタも,図10に示すニッパーのクラスタと,図11に示すハサミのクラスタに分類できた.ただし,図12に示すように,青マジックと赤サインペン,レーザポインタなどの複数の種類の物体が分類されたクラスタも発生した.

Fig. 10 The second classification made a cluster of only nippers.

Fig. 11 The second classification made a cluster of only scissors.

Fig. 12 A cluster that included multiple types of objects after the second classification.

2.5.2 色分類アルゴリズム

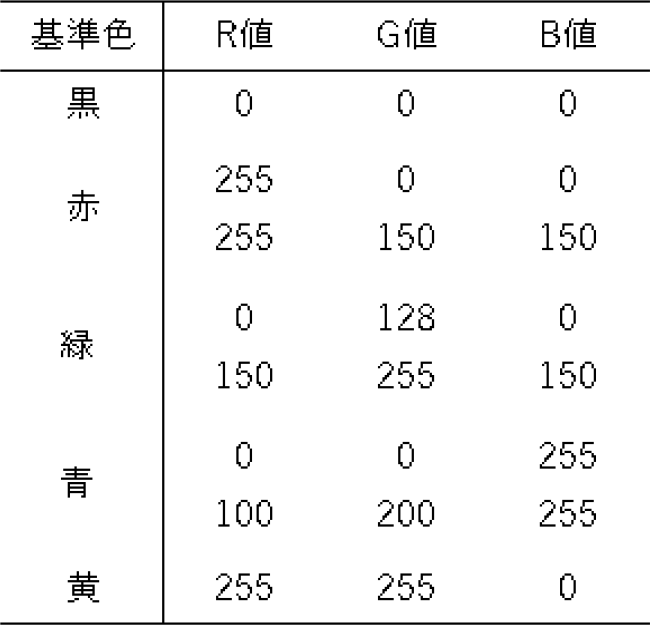

特徴量が似ている場合,図12のように異なる物体が同じ分類番号の移動物体フォルダに保存される場合がある.そこで,第1段階でノイズクラスタとして削除されなかったすべての画像に対して,第2段階の特徴量分類と独立に,色分類を行う.切り出した移動物体画像の前処理として,コントラストと明度を50%高める.k-means法[21](k=4)により,切り出された画像を4つの領域に区分する.区分された各領域の平均色を支配色と呼ぶ.支配色のsRGB値をL*a*b*値(CIE 1976)に変換する.色差式「CIE DE2000」[22]を利用し,表1に示す基準色と4つの支配色との色差を計算する.基準色との色差が一定(今回は24)以下の支配色を画像に含まれる色として分類する.ただし,赤/緑/青については,明るい色と暗い色のいずれの場合でも色分類できるようにするため,基準色を2色ずつ設定し,いずれかの基準色との色差が一定以下の場合にその色を含む画像と判定した.その結果,複数の色を含む画像や,1色も含まない画像も存在する.なお,PSSでは,白や灰色の基準色は用いない.これは,PSSが室内の照明が消えている場合も動き続けるため,白や灰色はほぼすべての移動物体画像に含まれるためである.

Table 1 Standard color used in color classification.

図13に,前節と本節で述べた処理をフローチャートで示す.これらの処理の結果,2台のカメラに人物が映っていない状態で移動物体を検知した場合に,その物体の画像を切り出し,3次元位置と特徴量分類番号,および画像に含まれる色のデータが付与され,PSSに保存される.

Fig. 13 Background processing of PSS.

2.6 検索結果表示部

ユーザは,移動物体を検索する場合,本節で述べる検索結果表示アプリケーションまたは次節で述べるAugmented Reality(AR)で表示するアプリケーションを用いて検索する.

検索結果表示アプリケーションは,Webブラウザ上で動作する.本稿の実験では,サーバは,Google社の提供するクラウドサービスであるFirebase [23]を用い,Webブラウザは2.3節で述べたDell Precision T1700にインストールされたGoogle Chromeを用いた.

なお,本節で述べるWebページをスマートフォン端末から(たとえばiPhoneからSafariで)閲覧することも可能である.ただし,セキュリティを考慮して,データベースをFirebaseではなく,Dell Precision T1700の内部に構築した場合は,スマートフォン端末から本節のWebページを見ることはできなくなる.

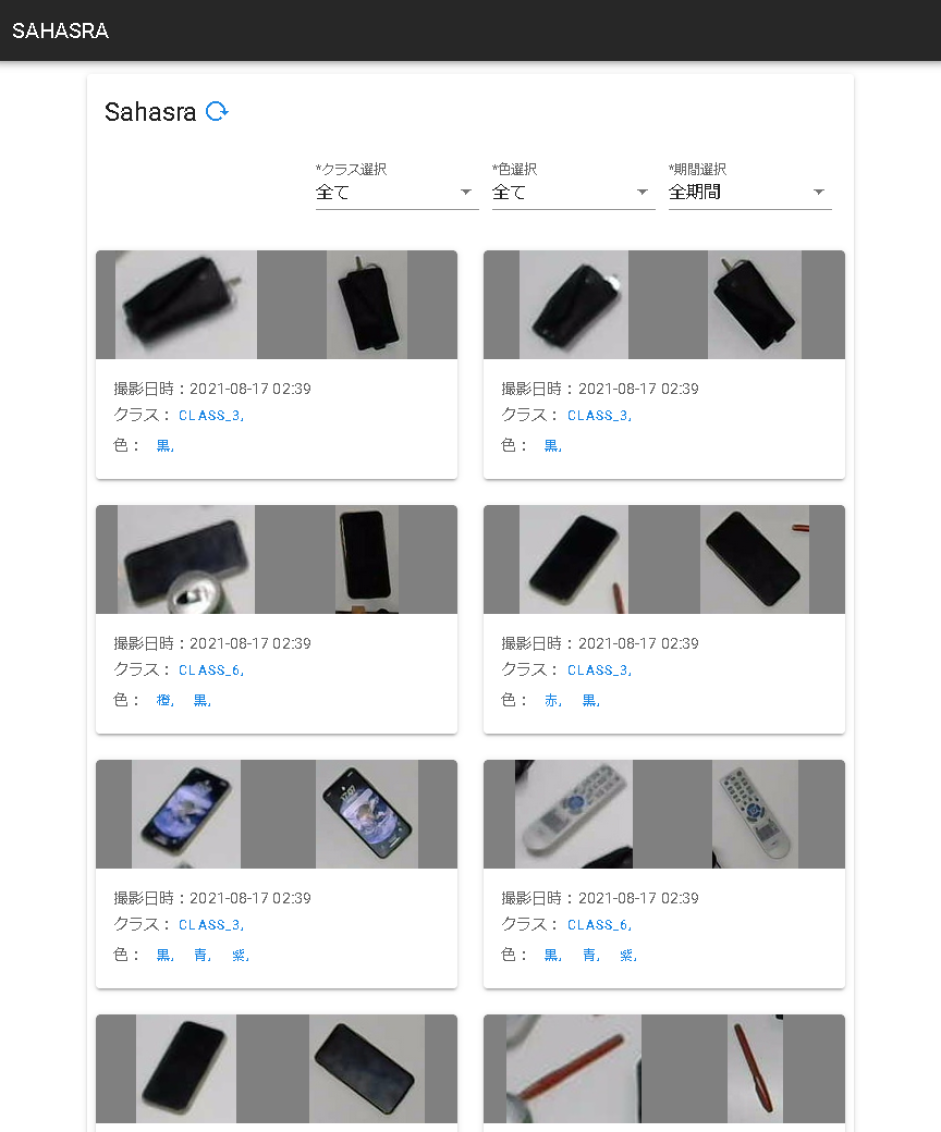

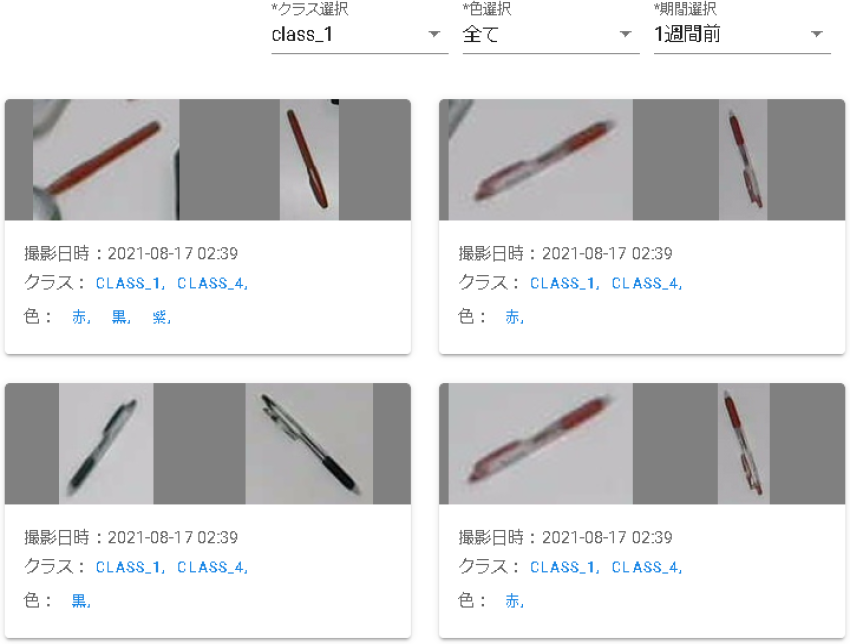

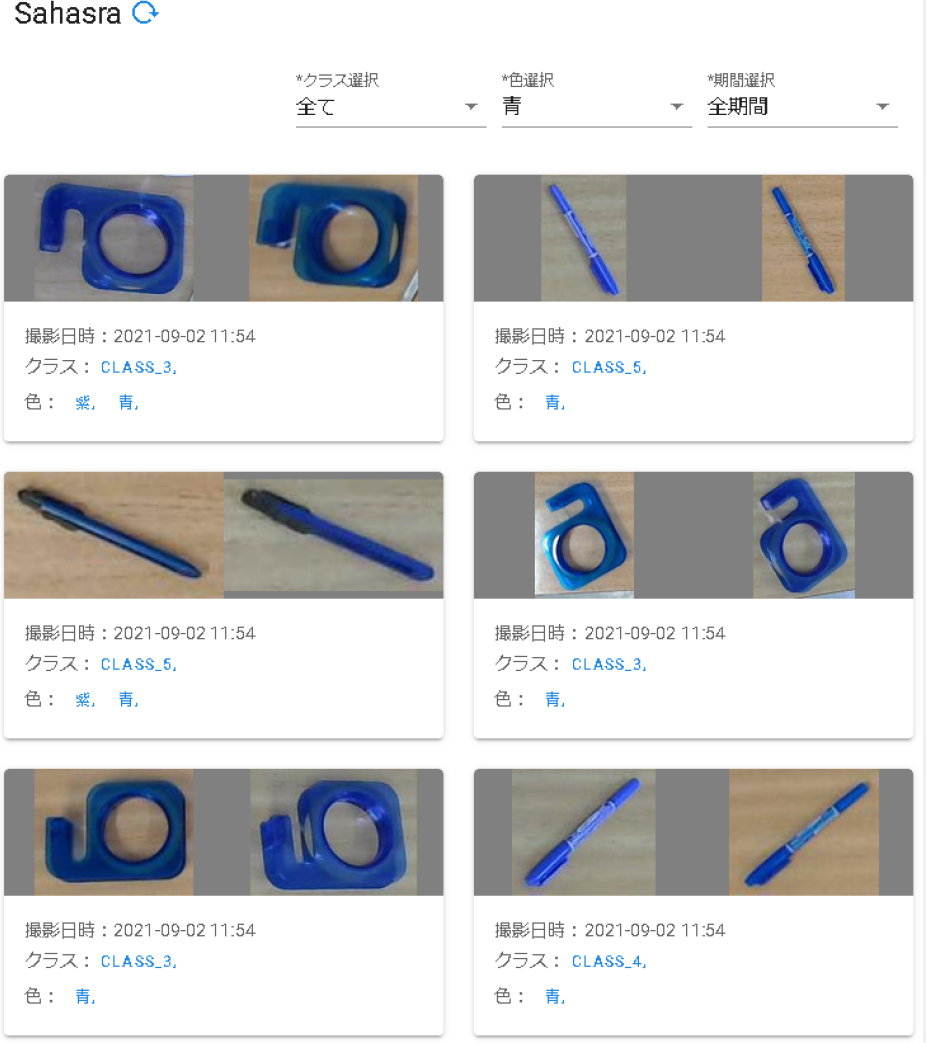

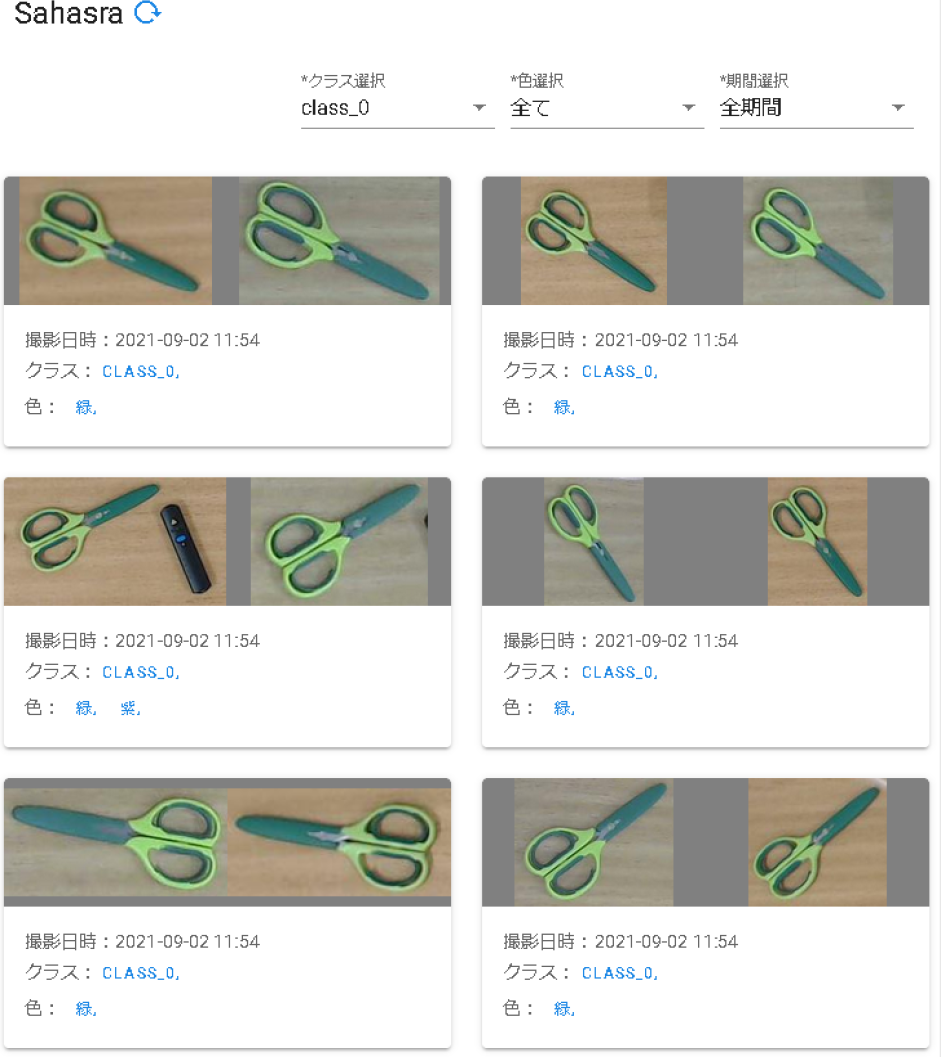

表示画面を図14に示す.検索結果表示アプリケーションでは検索クエリとして,検索対象物体の分類クラスタ番号/含まれる色/移動日時のいずれかを,図15に示す検索クエリ入力画面右上のプルダウンメニューから入力する.左端のクラスタ選択メニューは,2.5.1項で述べたx-means法で分けられた分類番号から探す場合に用い,中央の色選択メニューは2.5.2項で分けられた含まれる色から探す場合に用いる.右端の期間選択メニューは,移動物体が移動した日時から探す場合に用いる.これらを組み合わせて絞り込み検索をすることもできる.たとえば,「クラスタ1(class_1)」の画像のうち,移動した期間が「1週間前から」で検索すると,図16に示すように10組のペンが表示された.このうち8組が赤ペン,2組が黒ペンであった.ここで,色選択メニューで赤を選択すると,8組の赤ペンが表示された.これは,8組の赤ペンのすべてにおいて,画像に赤を含むためである.一方,黒を選択すると,2組の黒ペンと2組の赤ペンが表示された.これは,8組の赤ペンのうち2組で,画像に黒が含まれたためである.

Fig. 14 Screen of the search application.

Fig. 15 Screen for inputting search query.

Fig. 16 Screen of displaying search results.

画像に赤を含む赤ペンのような物体の場合は,色分類の信頼性が高いため,色による検索で高い精度が期待される.また,おおよその移動日時が分かっている物体の場合は,移動日時を入力することで高い精度が期待される.

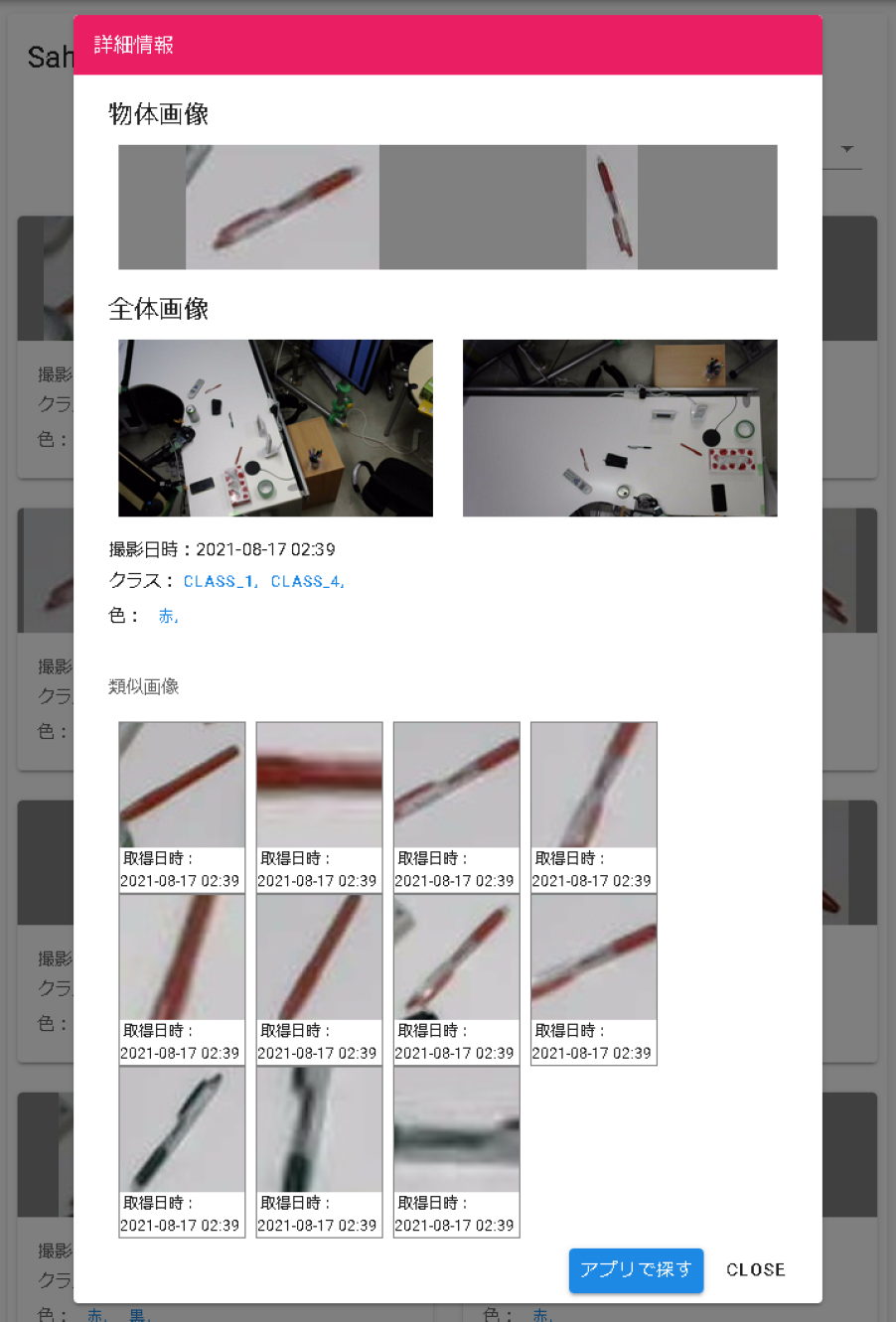

検索結果表示画面で探したい物体を見つけたユーザは,その画像をクリックすることで,図17に示すポップアップ画面が表示される.この画面では,2つのカメラで撮影された物体画像と全体画像に加えて,撮影日時,分類番号,含まれる色,および類似画像とその撮影日時が表示される.類似画像に表示された画像をクリックすると,その移動物体のポップアップ画面に遷移する.なお,図17右下の「アプリで探す」ボタンは,次節で述べるAR表示端末でのみ利用可能である.

Fig. 17 Display of pop-out screen after selecting images.

2.7 AR表示アプリケーション

検索された移動物体は,AR表示端末により,現実世界で移動した位置にAR表示することができる.AR表示端末は,カメラおよび加速度センサのついたAndroid OSのスマートフォンを用いた.前節の検索結果表示アプリケーションはWebアプリケーションであったが,本節のAR表示アプリケーションは,事前にスマートフォン端末へのインストールが必要なネイティブアプリケーションである.画像処理用コンピュータのデータをスマートフォンで参照するために,事前に分類結果をFirebase [23]にアップロードし,本節の端末内にダウンロードしておく必要がある.なお,AR表示アプリケーションを用いない場合,PSSではオンライン上にデータをアップロードする必要はない.

図17に示すポップアップ画面の右下の「アプリで探す」ボタンを押すと,スマートフォンのAR表示アプリケーションに移行する.このアプリケーションでは,自分が探したい物体が置かれていた場所にカメラを向けると,その場所で移動した物体の画像を表示する.

2.3節で用いたArUcoマーカを,初期設定と同じ場所に置いてスマートフォンで撮影すると,図18に示すとおり,ArUcoマーカの中心を室内座標系の原点と認識する.その後のカメラの移動はAR表示アプリケーションがスマートフォンの加速度センサとカメラ映像から推定するため,ArUcoマーカを映し続ける必要はない.

Fig. 18 Origin of coordinates in AR display application.

AR表示アプリケーションは,図19に示すように,撮影範囲内で移動したすべての移動物体を表示する.表示される物体数が多すぎる場合は,図18に示す画面上部に分類番号や移動日時を入力することで,特定の分類番号の画像や特定の日時に移動した物体のみを表示することもできる.表示されたアイコンを選択することで,その物体がいつ移動したか,また類似画像からどこに移動したかという移動物体の情報が表示される.

Fig. 19 Icons that display moving objects in AR display application.

3. Physical Search Systemの評価実験

3.1 実験環境

本章では,倉庫を模して金属製のラックを設置した実験(以下,倉庫実験と記す)と,オフィスを模してオフィスデスクを設置した実験(以下,デスク実験と記す)における実験設定について述べる.

3.1.1 倉庫実験での設置

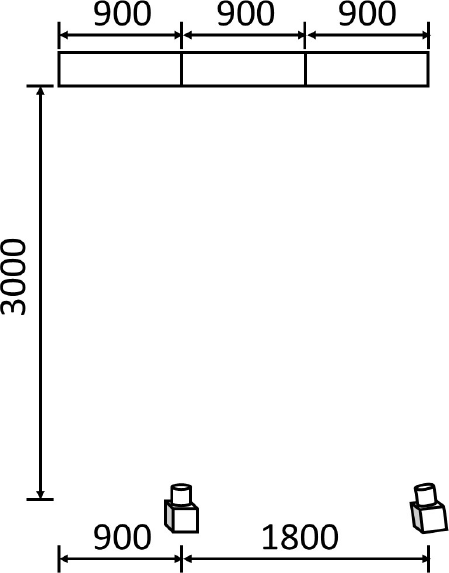

倉庫実験では,幅900 mm,高さ1880 mmの金属パイプラック3台を配置した.ラックの配置と移動物体を置いた様子を図20に,実験時のカメラの配置(室内上面図)を図21に示す.ラックの棚は3段あり,各段の高さは,下段から順に,780/1160/1590 mmであった.カメラは,ラックから3000 mm離れた位置で,床からの高さ1600 mmの位置に設置した.2台のカメラ間の距離は1800 mmとした.

Fig. 20 The placement of objects in the “stockroom experiment”.

Fig. 21 The placement of cameras in the “stockroom experiment” (top view).

3.1.2 デスク実験における配置

デスク実験におけるカメラと机の配置を図22に示す.デスク実験では,奥行き700 mm,幅1200 mm,高さ700 mmの木目のデスクを用いた.カメラは高さ1900 mmの位置に下向きに設置し,カメラからデスクまでの距離は1200 mm,2つのカメラ間の距離は800 mmとした.ただし,カメラの画角の制約のため,デスク上で移動した物体の配置は,横幅方向に800 mm,奥行き方向に500 mmの範囲に限定した.

Fig. 22 The placement of a desk and cameras in the “desk experiment”.

3.2 移動物体と移動方法

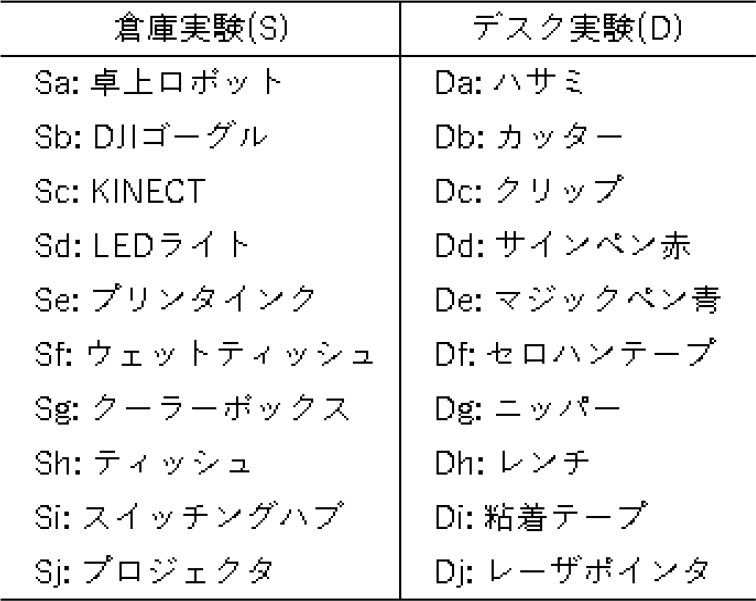

表2に本実験で配置して移動する物体の一覧を示す.倉庫実験では,表2の左の欄にある10個の物体を,デスク実験では表2の右の欄にある10個の物体を移動させた.

Table 2 Moving objects in the experiment.

PSSでは,人がカメラに映っている間は差分検知しないため,以下の手順で物体を移動させる.

- (1) 実験者は各実験で,10個の物体から無作為に1つの物体を選択して移動させる.選択された物体がラックまたはデスクに置かれていない場合には,その物体を無作為に選ばれたラックまたはデスクに置く.選択された物体がラックまたはデスクに置かれている場合は,その物体をそこから取り除く.この間,実験者は体の一部が常にカメラに映る場所にいるため,在室モードとなる.

- (2) (1)の動作を3回繰り返したら(3個の物体が移動),実験者はカメラに体が映らない場所に移動し,不在モードになることを確認したら,(1)に戻る.

(1)と(2)を,倉庫実験では50回,デスク実験では100回繰り返す.

3.3 2段階特徴量分類に関する実験結果

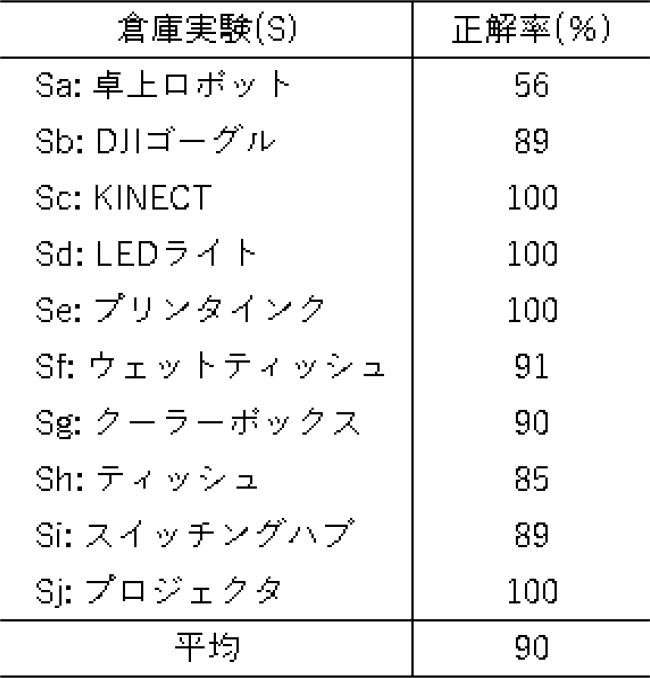

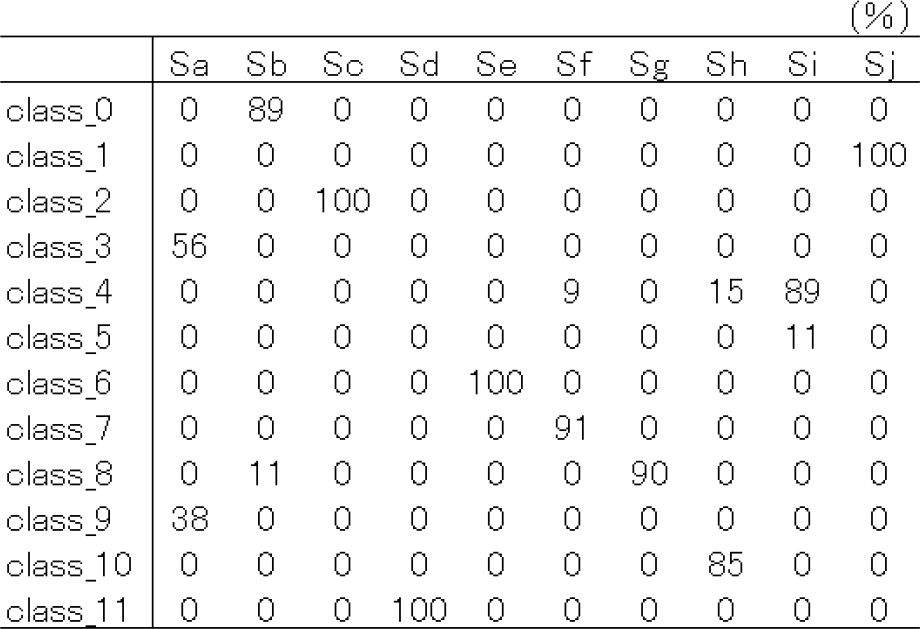

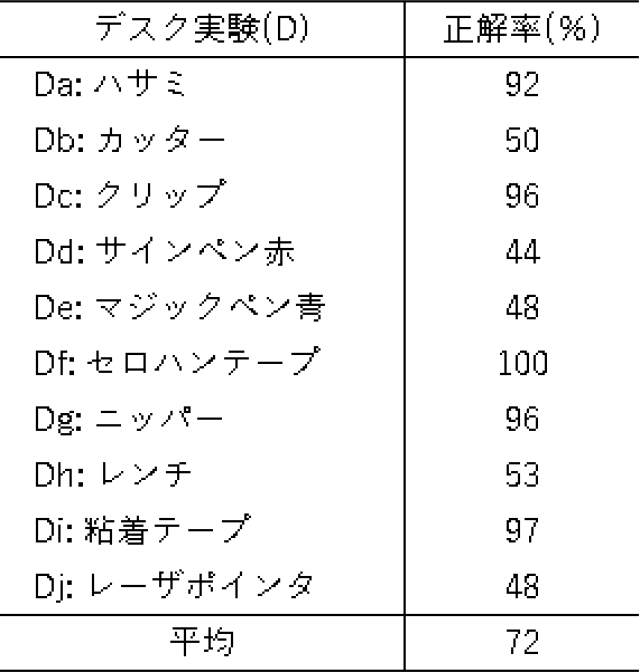

実験結果のうち,2段階特徴量分類結果として,倉庫実験の分類正解率を表3に,分類結果を表4に示す.また,デスク実験の分類正解率を表5に,分類結果を表6に示す.

Table 3 Accuracy rate of two-step feature classification in the “stockroom experiment”.

Table 4 Results of two-step feature classification in the “stockroom experiment”.

Table 5 Accuracy rate of two-step feature classification in the “desk experiment”.

Table 6 Results of two-step feature classification in the “desk experiment”.

倉庫実験では,10種類の物体画像が12クラスタに分類された.物体Sa,Sb,Sh,Siは2つのクラスタに分類された.そのうち,Sa(卓上ロボット[24])はclass 3とclass 9に分かれた.このとき,class 3とclass 9に分類されたすべての画像が卓上ロボットであったため,切り出された卓上ロボットの画像の94%は特定のクラスタに分類できたと言える.その他の物体も,平均で90%以上の正解率であったことから,倉庫実験の場合は,色分類を使わずに,2段階特徴量分類のみでも物体の検索に有効であることが示された.

デスク実験では,10種類の物体画像が8クラスタに分類された.このとき,いずれも細長い物体であるカッター,サインペン,マジックペン,レンチがいずれもclass 2とclass 3に分類された.これらは,2段階特徴量分類だけでは物体の種類を判別できなかったため,色分類の併用が必要な物体であると言える.一方,ハサミ,クリップ,セロハンテープ,ニッパー,粘着テープの5種類の物体は,正解率がいずれも90%以上であったことから,色分類の必要なく,2段階特徴量分類のみで検索が可能であると考えられる.

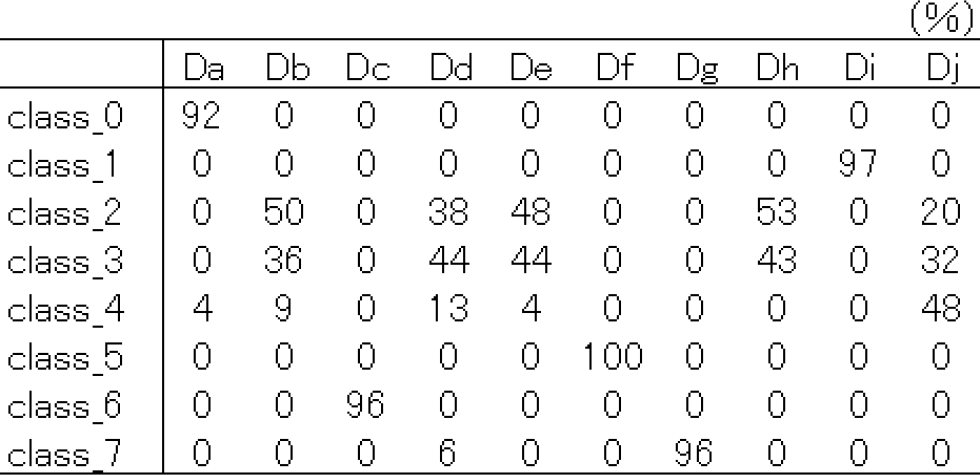

3.4 色分類に関する実験結果

デスク実験の色分類の結果を表7に示す.デスク実験では,表7中に太字で示した2段階特徴量分類の正解率が低かった5つの物体のうち,赤系統の色である物体Ddは100%が赤(red)に,青系統の色である物体Db,De,Djは95%以上が青(blue)に分類された.特徴量分類と色分類は並列に処理され,絞り込み検索時に両方が利用可能であるため,色分類も絞り込み検索に有効であると期待される.ただし,金属光沢を含む銀色の物体Dhは,最も高い緑(green)でも70%しか分類されておらず,色分類による絞り込みの効果は小さいと考えられる.

Table 7 Results of color classification in the desk experiment.

3.5 考察

本実験では,検索位置まで3 m離して水平方向にカメラを設置した場合と,1.2 m離して垂直方向に設置した場合という異なる2つの環境を用いている.いずれの環境においても,高い検索精度を得たことから,撮影範囲やカメラの距離,照明条件などへの依存が小さいことが期待される.また,3 cm程度のクリップでも高い精度で検知できたことから,ある程度,小さい物体に対しても検索可能であることが示された.一方,彩度の低い金属製の物体や,色と形状の両方が似ている物体同士の分類は,現在のアルゴリズムだけでは難しいことも示された.

PSSの正解率は100%ではない.しかし,たとえば青いと分かっているものを検索する場合の検索結果を示した図23や,高い確率でクラスタ0に分類されるものを検索する場合の検索結果を示した図24の例のように,実用上は検索ユーザの絞り込み方法次第で有用性が得られると期待される.

Fig. 23 An example of the result of searching for “blue object”.

Fig. 24 An example of the result of searching for “class 0”.

4. Physical Search Systemの実践

本章では,2つの方法で,PSSを実践した.4.1節で,大学図書室における実践について述べる.4.2節で,大学教員居室における実践について述べる.4.3節で,実践に対する評価について検討する.

4.1 大学図書室におけるPSSの実践的評価

4.1.1 実践内容

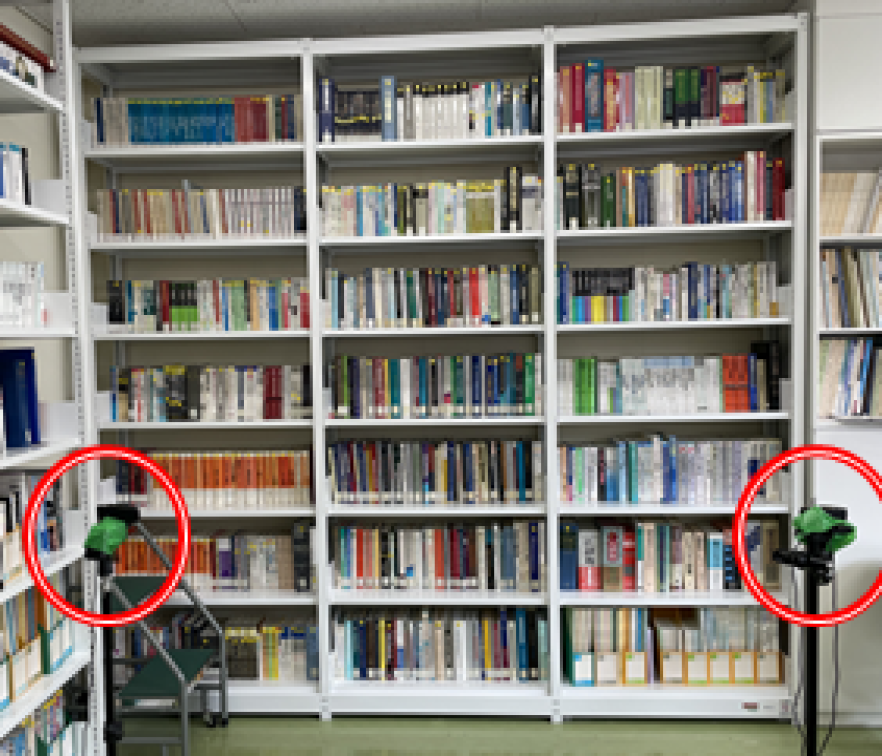

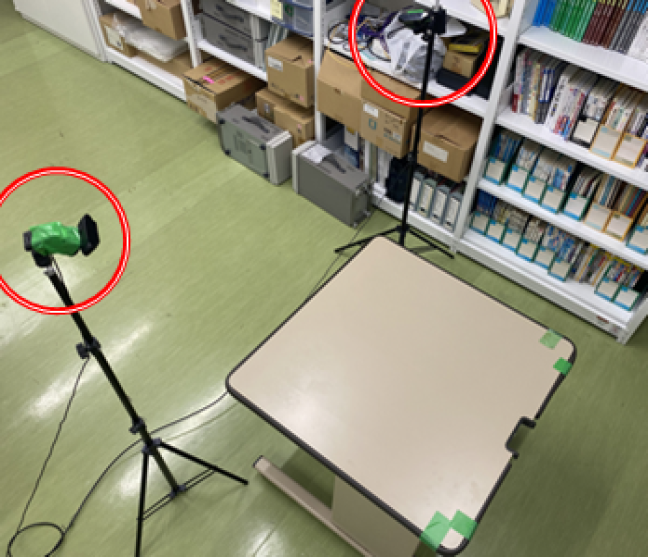

PSSの利用が望まれる現場では,3章の実験のような一様な背景であるとは限らない.本節では,佐賀大学理工学部7号館2階図書室にPSSを設置して,一様ではない背景や,重なり合った物体に対してPSSを適用する.佐賀大学の倫理審査(受付番号:R1-70)に基づき,被験者同意書を提出した被験者に,他の利用者がいない休日に,図書室を利用してもらう.実験を実施した図書室とWebカメラを図25に,取り出した図書を置いてもらう机Aを図26に示す.

Fig. 25 Bookshelf in the library used in the experiment.

Fig. 26 Desk A in the library used in the experiment.

本実践では,他の図書室ユーザがいない日に限定して実践的評価をするため,被験者にはあらかじめ,以下のように利用手順を指示した.

- 1 書架取出:書架から,任意の冊数の図書を取りだす.

- 2 机A配置:取り出した図書を,図書室の机Aに置く.

- 3 机A取出:机Aに置かれた図書を取り除く.

- 4 机B配置:取り除いた図書を机Bに置く.

このとき,書架/机A/机Bの3ヶ所それぞれに,PSSが設置されている想定で実験を実施した.すなわち,図25に示すように,書架の正面に2台のカメラを設置し,図26に示すように,机Aと机Bのそれぞれに2台のカメラを設置した.これにより,個々のPSSの撮影範囲からはすべての人物が退出するごとに不在モードとなり,室内には常に人物が存在した場合においても差分検知を可能とする.

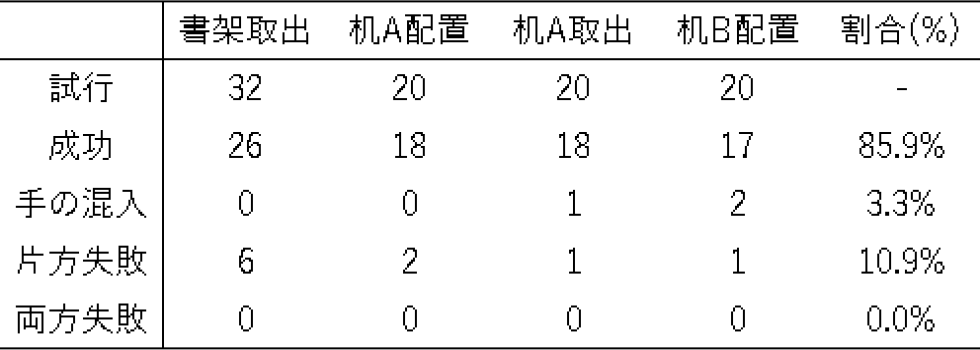

4.1.2 実践結果

被験者が書架から取り出した図書は32冊であり,その間,15回の在室モードと不在モードの切り替えが発生した.被験者が図書を置いた机Aの様子を図27に示す.

Fig. 27 The subject took books from the stack and placed them on the Desk A.

書架から図書を取り出した際に,書架を撮影するPSSの検知結果を表8に示す.「成功」は,2つのカメラの両方で,手の混入なく,移動した図書を含む画像が切り出された回数を示す.「手の混入」は,切り出された画像に被験者の手が映りこんだ回数を示す.「片方失敗」は,2台のカメラのうち1台のカメラでは移動した図書を含む画像を切り出したが,もう1台のカメラでは,移動した図書を含まない画像を切り出したか,または画像が切り出されなかったことを示す.「両方失敗」は,2台のカメラともに移動した図書を切り出さなかったことを示す.

Table 8 Detection results for books' movements.

32冊の図書を15回に分けて取り出した結果,26冊の移動検知と位置検知に成功した.残りの6冊は,片方のカメラのみで検知し,もう片方のカメラで検知に失敗したため,移動検知には成功したものの,正しい位置検知ができなかった.書庫からの取り出しは,32冊中26冊,テーブルへの配置/取り除きは計60冊中53冊が成功したことから,実践的に利用できる可能性が示された.

4.1.3 考察

背景に多数の本の入った書架や,重なり合って置かれた図書があっても検知率が低下しなかった理由は,PSSでの移動検知では,背景のコントラストに影響を受けるエッジ抽出や,背景の模様に影響を受けるディープラーニングを用いていないため,背景の影響を受けにくかったからであると考えられる.

カメラ配置については,テーブルなど限定的な範囲を映す配置にすると,手や足の一部だけが映りこんだ場合に人物検知に失敗し,不在モードと在室モードの切り替えが正しく行われない場合があることが明らかとなった.

4.2 大学教員居室におけるPSSの実践的評価

4.2.1 実践内容

第7筆者の職場の天井のオフィスデスクを撮影できる位置に2台のWebカメラを設置し,約1ヶ月間,実践的に評価をした.2021年6月23日から7月14日までの実践結果を踏まえて,PSSを調整した後の2021年7月15日から2021年7月27日までの評価と課題について述べる.なお,本Webカメラは音声を収録していない.また,学生を含む来客が座るイス等は映らない角度でカメラを設置しており,第7筆者以外にカメラに映った人物はいなかった.

4.2.2 特徴量分類の評価

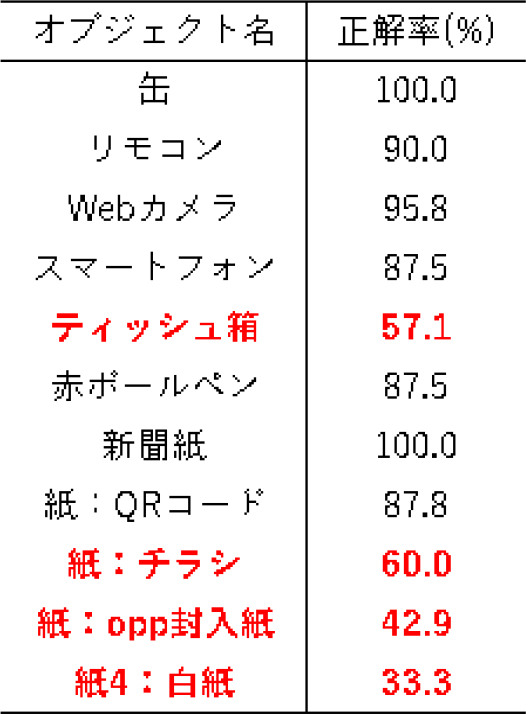

本実践では,11種類の物体が7個のクラスタに分類された.表9に示すとおり,缶やリモコンなどの7つの物体は,85%以上が1つのクラスタに分類されたが,4つの物体は,1つのクラスタに分類された割合が60%以下であった.

Table 9 Ratio classified into the same class by feature classification.

1つのクラスタとしての分類に失敗した4つの物体のうち,チラシ,opp封入紙,白紙の3つは,いずれも形状がA4サイズの長方形であった.長方形の内側の違いはディープラーニング特徴量としては小さかったと考えられる.特に,表面のフィルムが照明を強く反射するopp封入紙や,白紙のコピー用紙は,正解率が低かった.

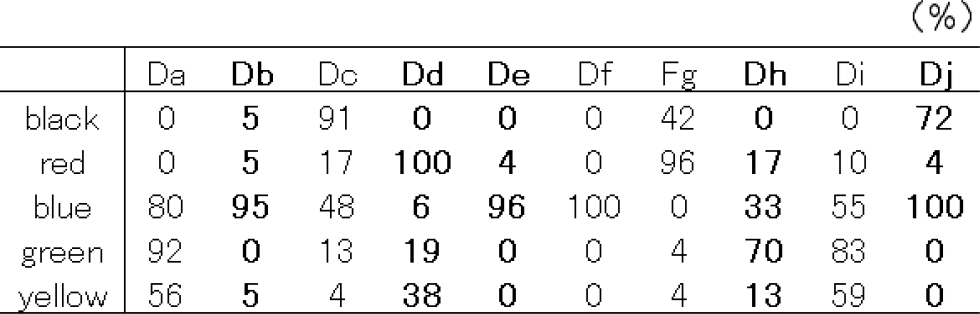

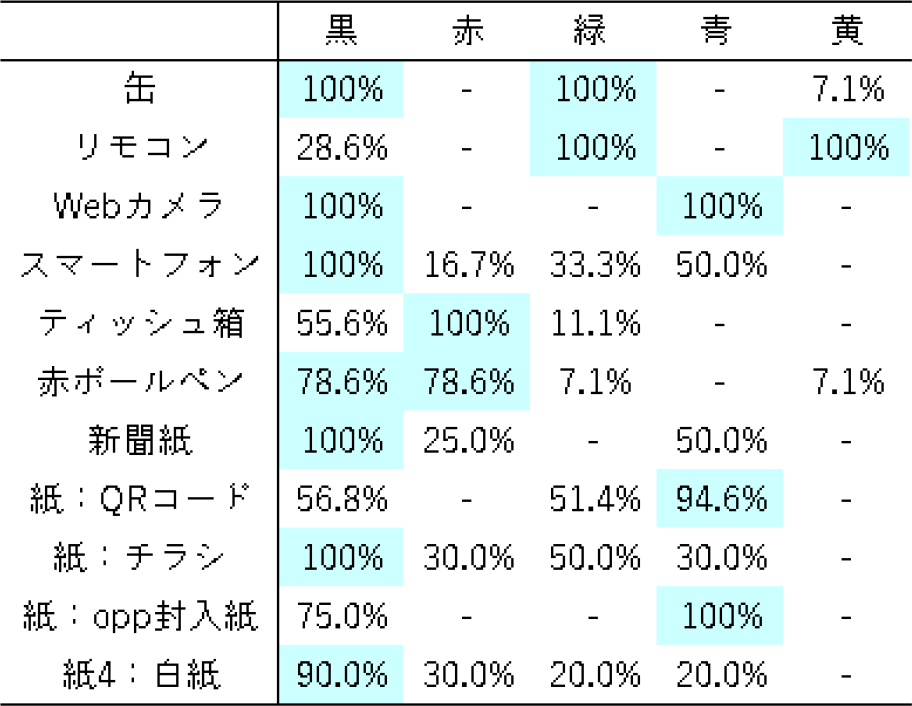

4.2.3 色分類の評価

PSSで,特徴量分類できなかった移動物体を検索する場合,色分類により検索する.表9の11物体について,色分類した結果を表10に示す.表中の分類結果の値は,その物体の画像のうち,その色を含むと判定された割合を示す.複数の色を含むと判定された物体画像や,指定した色を含まないと判定された物体画像もあるため,合計は必ずしも100%にはならない.

Table 10 Results of color classification for each object.

色分類の結果,すべての物体において一定の割合で「黒」を含むと判定されている.特に,新聞紙やロック状態のスマートフォンなど,主観的に黒く見える物体は,そのすべての画像に「黒」を含むことが確認できた.一方,赤を含むティッシュ箱や赤ボールペンは赤を含むなど,特徴量分類の正解率が50%以下であった物体でも,色分類により70%以上の割合で特定の色に分類されるものがあった.これらの結果から,ユーザは色分類から検索できる可能性が高いことが示された.

4.2.4 人物検知および移動物体検知の評価

本実践では,2.4.1項の人物検知アルゴリズムにより,人物全体および上半身全体,人物の顔が映った画像が切り抜き画像に含まれたことは一度もなかった.ただし,手首から先やひざから下の部位が移動物体として切り抜かれた事例があった.これらの結果から,プライバシーやセキュリティの問題が発生する可能性は低いと考えられるが,映りこんだ靴や指輪などから人物が特定される可能性もあるため,人物の特定が好ましくない場所でPSSを用いる場合は,オンライン上では検索しない運用が望まれる.今後は図28のように,カメラの撮影範囲のうち,移動物体検知範囲を制限する機能などを実装することが望ましいと考えられる.

Fig. 28 Example of moving objects detection range.

4.3 システムの利用に関する実践的評価

4.3.1 ユーザの作業負荷に対する評価

PSSの導入までの作業負荷は,機器の設置とキャリブレーションがある.本実践のために,第7筆者の部屋の天井にWebカメラ2台を設置し,画像処理用コンピュータを配置した.Webカメラの設置は,検索したい範囲が映れば,どのような位置と角度であってもよい.また,実践中にカメラの位置や角度が変わっても,改めて,ArUcoマーカを置いて撮影すればキャリブレーションできる.このため,民生品の小型Webカメラを粘着テープでとめるといった簡単な設置方法でも構わない.本実践でも,2021年6月23日から2021年7月27日までの撮影期間中,一度もWebカメラに触れる必要はなかった.

PSS導入後は,物体検索をするとき以外にユーザの作業は発生しない.物体検索時は,Webブラウザを立ち上げてPSSのURLをクリックし,2.6節で述べた検索作業をする.検索時の操作は,マウスクリックのみであるため,ブラウザ上でキーワード検索をする場合と比べても大きな負担を感じることは無かった.これらの結果から,PSSの利用に対し,ユーザの作業負荷は小さいと筆者らは考える.

ただし,本実践でPSSを使用したのは第7筆者である.PSSの開発者(第1~4筆者)ではないがアルゴリズムを理解したうえで使用しているため,ユーザにとっての負担感の詳細については今後の検討課題である.

4.3.2 システム負荷に対する評価

PSSで用いるWebカメラは,Windows 10で認識される一般的な民生品のWebカメラであれば利用可能である.本実践では720p(1280×720画素)の時価3000円程度の標準的なWebカメラを用いたが,性能的に問題は無かった.

コンピュータで実行する画像処理のうち,リアルタイムで処理するのは2.4節の移動物体検知アルゴリズムである.人物検知アルゴリズムはYOLO [12]であり,移動物体検知アルゴリズムはOpenCVであるため,多少の計算負荷は必要となる.ただし,コンピュータのスペックに合わせて,処理の頻度を,たとえば5秒に1回から10秒に1回に変更することもできる.本実践で用いたコンピュータも2013年度に購入したものであったが,スペックとして不足することは無かった.2.5節の分類アルゴリズムには多少の計算負荷がかかるが,こちらはリアルタイムで実行する必要はないため,大きなシステム負荷はかからなかった.

検索データは自動的に増えていき,切り出し画像が約500枚で約2 MB,切り出し前の全体画像が約500枚で約50 MBであった.これらは物体移動を検知するたびに増えていくため,ストレージ容量の確保は課題である.本実践における第7筆者のオフィスデスクの場合,2週間で50 MB程度のストレージ容量が必要となった.このため,今回の環境の場合,1年間で1~2 GBのストレージを確保しておく必要があると予想される.

これらの結果から,システム負荷に対する実用上の問題は少ないと考えられる.

4.3.3 ELSIに対する評価

PSSは,常に2台のカメラで撮影を続けるため,倫理的・法的・社会的課題(ELSI),特にプライバシーの問題が避けられない.第7筆者の職場のデスクで,約1ヶ月間,PSSを稼働させた実践では,PSSのコンピュータは第7筆者の居室内にあり,画像等のデータは室内に置かれた画像処理用コンピュータから外部に送信することなく処理できる.しかしその場合でも,共筆者以外の被験者には,長期間の設置に同意してもらうことはできなかった.

また,来客など他者がPSSの置かれた部屋に入室した際には,PSSが稼働中であることを伝え,希望によりシステムを停止する必要があると考えられる.

本実践では,2.7節で述べたAR表示アプリケーションおよびオンライン上でも検索する場合に,PSSによる分類結果をGoogle社の提供するクラウドサービスであるFirebase [23]にアップロードした.このようなクラウドサービスで運用する場合には,アップロードの可否を判断する仕組みなどが課題である.AR表示アプリケーションやオンライン上で検索する必要なく,室内端末のみで検索する場合には,その画像データにアクセスできるのはその室内にいる人物のみであるため,プライバシーの問題は少ないと考える.

本実証期間中,体の一部(主に手首や靴など)が誤って移動物体として切り出される例が発生した.顔や上半身全体が映る場合は,人を検知できず不在モードになることはなかったが,体の一部でも人物を特定できる場合もある.また,現在のPSSでは,移動物体の切り出し前の全体画像も保存しているため,利用者が限定されるスペースでの利用に限定することが望ましい.

5. 期待される社会的有用性

5.1 想定される個別の用途

4章で示したように,PSSの公共の場所での実践には,実践先での規程の整備が必要なため,本稿で十分な実践結果を示すことは難しい.そこで本章では,PSSが有用に働くと想定される状況についてまとめる.

PSSが有用な場所には,物体の保管倉庫,木工室,個人宅(リビング,子供部屋など),オフィス,店舗などが挙げられる.保管倉庫や木工室は,物体の出入りの記録が定かではないまま紛失した場合,いつ,その物体が移動したかという情報は移動物体の発見に有用に働く.

個人宅では,ユーザの特性によりPSSの必要性は異なる.各物体を部屋のどこに収めるかが明確に定められており,ユーザ本人も必ずその位置に戻すのであればPSSは不要である.しかし,常に物体が雑然と置かれ,同じ部屋を使う人数が多い場合や,幼児,認知症高齢者が同居する家庭では,PSSが有用と考えられる.さらに視覚障害者は,通常どこに何が置いてあるか把握しているが,同居する他者が報告もなく物体を移動した場合には見つけることが困難である.このような場面でもPSSは有用に働くと期待される.

また個人宅では,PSSを長期間稼働させることにより,普段使用しない物体や,その部屋に存在するか不明な物体に対して有用性が高くなる.たとえば,1年前のお歳暮に油をもらって,どこかにしまい込んでいた場合,家に未使用の油があることすら忘れてしまうかもしれない.しかしユーザが油を買い足す前に,アプリケーションを使って検索することで,思わぬ場所で油を見つけることができるかもしれない.

オフィスについては,4.3.3節で示したように,画像等のデータは居室内に置かれたコンピュータで処理されるため,個人の居室で,ユーザがシステムを理解していれば,利用の敷居は低くなると考える.店舗では,棚やテーブルのうえに間隔に余裕をもって商品を置くディスプレイなどで有用に働くと考える.移動した商品の中で,購入ではない紛失がいつ起きたのか,その商品は店舗内の別の場所に置かれたのか,といった情報をPSSから得ることができる.さらに,客が興味をもって手にとった商品の情報を収集することも可能であると期待される.

5.2 実践結果を踏まえた今後の課題

教員居室でのPSSの実践的評価(4.2節)では,特徴量分類で1つのクラスタに分類された割合が60%以下の物体は4種類あったが,色分類では70%以上の割合で1色に分類された.PSSの精度は高いことが望ましいが,そのコンセプトから,100%を目指すものではない.本実践結果でも,白紙に印字された書類や,透明フィルムでラッピングされた雑誌などは,移動検知はできても特徴量による分類はほぼできなかった.しかし,第7筆者がPSSユーザとして過ごした際には,「白い書類だから検索できない」とか「真っ赤なマジックだから検索できる」などの前提でPSSを利用するのみならず,「後から検索しやすいように赤いマジックと一緒に白い書類を置いて動かそう」と意識して使う場合もあった.これは,Webページ作成における検索エンジン最適化(SEO:Search Engine Optimization)と同様に,PSS検索で見つかりやすいようにPSSユーザが対応することを意味している.本稿の実践では,長期間の被験者は共筆者に限定されているため,今後は,共筆者や開発者ではなく,PSSの中身を知らない被験者に対する長期間の実験が課題である.

もう1つの課題は,PSSを想定した規程の整備である.実験を実施した佐賀大学では,研究に対する倫理審査とは別に,「国立大学法人佐賀大学における防犯カメラの管理および運用に関する規程[25]」が制定されている.この規程に基づくと,被験者同意書を提出していない人物の撮影の際には,一切の画像の加工は禁止されており,1ヶ月以上前のデータを保存することも禁止されている.このため,佐賀大学内での公共スペースや,学生や来客が映る可能性のある場所へのPSSの設置は,事実上,禁止されている.このように,PSSの社会実装には,実装先の規程の整備も必要となる.また,初期のGoogleでは,検索結果を表示する画面が違法(著作権法の複製および翻案にあたる)として裁判[26], [27]になり,検索結果の表示がFair Use(公正利用)に該当するかが議論された.現在では,一部の国家を除く世界各国で,事実上の黙認,あるいは合法化されている.PSSでは,設置されたカメラを用いて自動的に撮影し,画像の加工と保存をするため,社会的合意が得られつつある監視カメラとは異なる規程を整備する必要があると考えられる.これらも,今後の課題である.

6. おわりに

本稿では,カメラ以外のセンサや学習用データの事前登録が不要で,フィジカル空間で移動したあらゆる物体を,2台のカメラで検知して検索できる“Physical Search System(PSS)”を提案し,構築した.一般的なインターネット検索と同様に,ブラウザに検索クエリを入力するだけで,フィジカル空間内において移動した物体を検索できた.また,約1ヶ月のプラクティスから,問題点を明らかにするとともに,その有用性を検討した.現在のPSSの課題として,人物がカメラに映っていない場合に限定して撮影する点があげられる.このため,常にカメラに人物が映っている場合には,現在のPSSが利用できない.一方,PSSの有用性として,事前に学習や登録をしていない様々な移動物体に対して,特徴量と色から自動的に分類でき,検索が可能となることを確認した.

PSSは,センサを装着した物体の位置検知や,十分な学習用データをあらかじめ用意した物体検知と比較すると,精度は劣ると考えられる.しかし,PSSでは,これらの事前作業が一切必要なく,様々なフィジカル空間の情報をサイバー空間で検索できるようになった.これは,サイバー空間とフィジカル空間との高度な融合を目指す際に,有用であると筆者らは考えた.

PSSは,市販のPCと2台のWebカメラ,およびAR表示用Android端末があれば,開発したソフトウェアをダウンロードすることで利用可能となる.今後は,軽度認知症者の自宅や,物品管理倉庫など,幅広い領域で利用可能なシステムへと改良を進める予定である.

参考文献

- [1] 西山高史:スマートホーム技術の現状と将来:SoS視点も入れて,計測と制御,Vol.59, No.12, pp.957–960 (2020).

- [2] 佐藤知正:生活を支えるネットワーク知能機械:ロボティックルームの試み,東芝レビュー,Vol.56, No.9, p.28 (2001).

- [3] 佐藤知正,西尾英樹,保坂 寛:ロボティクスとユビキタスコンピューティングが創るIoTの新世界,日本ロボット学会誌,Vol.35, No.2, pp.88–92 (2017).

- [4] Ahmad, A., Paul, A., Rathore, M. M. and Chang, H.: Smart cyber society: Integration of capillary devices with high usability based on Cyber-Physical System, Future Generation Computer Systems, Vol.56, pp.493–503 (2016).

- [5] Baheti, R. and Gill, H.: Cyber-physical systems, The impact of control technology, Vol.12, No.1, pp.161–166 (2011).

- [6] 堂前幸康,多田充徳,谷川民生:サイバーフィジカルシステムと人・機械協調,日本ロボット学会誌,Vol.37, No.8, pp.683–686 (2019).

- [7] Kim, N. Y., Rathore, S., Ryu, J. H., Park, J. H. and Park, J. H.: A survey on cyber physical system security for IoT: issues, challenges, threats, solutions, Journal of Information Processing Systems, Vol.14, No.6, pp.1361–1384 (2018).

- [8] Bai, Z. Y. and Huang, X. Y.: Design and Implementation of a Cyber Physical System for Building Smart Living Spaces, International Journal of Distributed Sensor Networks, Vol.8, No.5, 764186 (2012).

- [9] Castaño, F., Beruvides, G., Haber, R. E. and Artuñedo, A.: Obstacle Recognition Based on Machine Learning for On-chip LiDAR Sensors in a Cyber-physical System, Sensors, Vol.17, No.9, 2109 (2017).

- [10] Zhou, C., Luo, H., Fang, W., Wei, R. and Ding, L.: Cyber-physical-system-based Safety Monitoring for Blind Hoisting with the Internet of Things: A case study, Automation in Construction, Vol.97, pp.138–150 (2019).

- [11] 田中未来哉,角所 考,小島隆次:人物行動を手掛かりとした放置物体の置き忘れ検出可能性の検討,ヒューマンインタフェース学会論文誌,Vol.23, No.2, pp.209–212 (2021).

- [12] Redmon, J., Divvala, S., Girshick, R. and Farhadi, A.: You only look once: Unified, real-time object detection, In Proceedings of the IEEE conference on computer vision and pattern recognition, pp.779–788 (2016).

- [13] Cao, Z., Simon, T., Wei, S. E. and Sheikh, Y.: Realtime Multi-person 2d Pose Estimation Using Part Affinity Fields, In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pp.7291–7299 (2017).

- [14] Hamasaki, R. and Nakayama, K.: A Deep Learning System that Learns a Discriminative Model Autonomously Using Difference Images, Proceedings of the Genetic and Evolutionary Computation Conference Companion, ACM, pp.1683–1685 (2019).

- [15] Nakamura, K., Hamasaki, R., Oshima, C. and Nakayama, K.: Optimizing Combinations of Teaching Image Data for Detecting Objects in Images, Lecture Notes in Computer Science, Springer, Vol.12185, pp.491–505 (2020).

- [16] OpenCV: Detection of ArUco Markers: 〈https://docs.opencv.org/4.5.2/d5/dae/tutorial_aruco_detection.html〉(参照2021-09-06).

- [17] He, K., Zhang, X., Ren, S., and Sun, J.: Deep residual learning for image recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition, pp.770–778 (2016).

- [18] ResNet50: 〈https://jp.mathworks.com/help/deeplearning/ref/resnet50.html;jsessionid=c2d1fcfb1eb58ff18ab9a8beff0c〉(参照2021-09-06).

- [19] ImageNet: 〈https://www.image-net.org/〉(参照2021-09-06).

- [20] Pelleg, D. and Moore, A. W.: X-means: Extending k-means with efficient estimation of the number of clusters. In Icml, Vol.1, pp.727–734 (2000).

- [21] Bradley, P. S. and Fayyad, U. M.: Refining initial points for k-means clustering, In ICML, Vol.98, pp.91–99 (1998).

- [22] Luo, M. R., Cui, G. and Rigg, B.: The Development of the CIE 2000, Colour-Difference Formula: CIEDE2000, Color Research and Application, Vol.26, No.5, pp.340–350 (2001).

- [23] Google, “Firebase”: 〈https://firebase.google.com/〉(参照2021-09-06).

- [24] Hock, P., Oshima, C. and Nakayama, K.: CATARO: A Robot that Tells Caregivers a Patient's Current Non-Critical Condition Indirectly, Proceedings of the Genetic and Evolutionary Computation Conference, pp.1841–1844 (2018).

- [25] 国立大学法人佐賀大学における防犯カメラの管理及び運用に関する規程(平成30年3月28日制定):〈https://kiteikanri2011.admin.saga-u.ac.jp/doc/rule/1142.html〉

- [26] wikipedia: Field v. Google, Inc.: 〈https://en.wikipedia.org/wiki/Field_v._Google,_Inc.〉(参照2021-11-05).

- [27] wikipedia: Perfect 10, Inc. v. Amazon.com, Inc.〈https://en.wikipedia.org/wiki/Perfect_10,_Inc._v._Amazon.com,_Inc.〉(参照2021-11-05).

梶原 薪(非会員)

2018年3月佐賀大学理工学部卒業.2020年3月同大学大学院工学系研究科博士前期課程修了.2020年4月同大学大学院工学系研究科博士後期課程進学,現在に至る.株式会社NEXS代表取締役社長.

岡崎 政人(非会員)

2022年3月佐賀大学理工学部知能情報システム学科卒業.2022年4月同大学大学院理工学研究科博士前期課程入学,現在に至る.

川端 健介(非会員)

2020年3月佐賀大学理工学部卒業.2022年3月同大学大学院理工学研究科博士前期課程修了.修士(工学).

古川 皓登(非会員)

2021年3月佐賀大学理工学部卒業.2021年4月同大学大学院理工学研究科博士前期課程入学,現在に至る.

大島 千佳(正会員)

北陸先端科学技術大学院大学修了.博士(知識科学).株式会社ATR,独立行政法人NICT,JSPS特別研究員(RPD)を経て,佐賀大学客員研究員.ACM Multimedia2004 Best Paper Award,山下記念研究賞等受賞.

福田 修(非会員)

広島大学大学院修了.博士(工学).産業技術総合研究所を経て,2014年から佐賀大学理工学部教授,現在に至る.サイバーフィジカルシステムや人間拡張デバイスに関する研究を行う.IEEE Transactions on Robotics and Automation K. S. Fu Best Paper Award,計測自動制御学会論文賞(友田賞)などを受賞.

中山 功一(正会員)knakayama@is.saga-u.ac.jp

京都大学大学院修了.博士(情報学).株式会社ATR,独立行政法人NICTを経て,2010年から佐賀大学理工学部准教授,現在に至る.個人に最適化される知的情報システムに関する研究を行う.山下記念研究賞等受賞.

再受付日 2021年11月5日/2021年12月29日

採録日 2022年1月27日

会員登録・お問い合わせはこちら

会員種別ごとに入会方法やサービスが異なりますので、該当する会員項目を参照してください。