スマートフォンを用いた聴覚障がい者向け情報保障システムの構築と評価

1.はじめに

1.1 背景

今日,ラジオやテレビなど音声による情報伝達が多数用いられている.しかし,聴覚障がい者は,音声から情報を得ることが難しい.また,文字として書かれた日本語(書記日本語)による解説があったとしても十分とはいえない.これは,聴覚障がい者の中には,書記日本語を読むのが苦手な人がいるからである.

文字は視覚的にアクセスができるので,一般の健聴者から見れば,聴覚障がい者でも読み書きの日本語は容易にできると考えがちである.しかし,聴覚障がい者は音声言語の獲得が困難であるため,二次的な書記言語の学習も困難である.読み書きは,音声言語を第一言語として習得した後に,教育的な介入を経ることによって初めて習得できるものである[1].ろう学校に通う聴覚障がい児の書き言葉の読み能力を調査した研究では,普通小学校4年生程度の発達にとどまるとされており,中学校・高校の生徒でも読解力に問題があることが挙げられている[2],[3].筆談やチャットなどでのコミュニケーションのように,文法的に簡単な文章であれば,理解も容易であると思われるが,展示物の解説などの長く複雑な文法構造を持つ文章の場合は,理解しづらいのである.

筆者らが書記日本語と日本手話(以下手話とする)による展示物の解説について,手話を主に使用する聴覚障がい者を対象とした評価実験を行ったところ [4],手話の方が日常的に使っているので分かりやすい,文字もよいが,読めないことや意味がつかめないことがあるといった意見があった.さらに顔が見えるから分かりやすい,顔の表情などを楽しく見ることができるといった文章の理解だけではなく,親しみやすさも重要であることが分かった.

日本において,手話を主に使用する聴覚障がい者の人口は,調査・研究結果によって異なるが,3.5万人から5.7万人と推定されており[5],[6],[7],手話コンテンツによる情報保障は,非常に重要であると考えられる.

これとは別に,現在多くの聴覚障がい者がフィーチャーフォンやスマートフォンを利用している[8].普及率は2012年度で95%で,健聴者の98%[9]と比べてもほぼ同じといってよい.フィーチャーフォンが普及する前は,遠隔地の通信手段は手紙かFAXであったが,フィーチャーフォンの普及によりメールでのやりとりが中心となった.その後,フィーチャーフォンにおいて,TV電話が利用できるようになり,リアルタイムで手話でのやりとりが可能となった.さらにスマートフォンでは,TV電話のほかにチャットアプリやSNSでのコミュニケーションが盛んとなっている.

しかしながら,文字によるコミュニケーションは日常の会話が中心であり,先に述べたように複雑な文章の場合は,手話を主に使用する聴覚障がい者の人たちにとっては,手話の方が理解しやすいのである.

1.2 目的

現在,インターネットが整備され,あらゆる場所で情報保障が得られる状況が整い始めた.情報保障は障がい者に限らず健常者にも必要である.たとえば,海外旅行をしたときの日本語での説明などもその1つである.筆者らは,いつでもどこでも情報保障が受けられるシステムについて研究を行っている.これは聴覚障がい者に限っていない.用意するコンテンツを利用者に合わせれば,その利用者向けの情報保障となる.たとえば書記日本語であれば,日本語力が十分な聴覚障がい者だけでなく,一般の晴眼者にも有効である.また日本語音声なら視覚障がい者を含む健聴者に有効である.さらに各国語の音声や文章を用意することで,それらを母語とする人たちへの情報保障となる.

そこで筆者らは,フィーチャーフォンやスマートフォンを用いて,いつでもどこでも情報保障が得られるシステムを構築することを目的とし,研究を行っている.最終的には聴覚障がい者に限らず,あらゆる人への情報保障を行うことを目的としているが[10],本稿で述べるシステムは,コンテンツとして日本手話を用い,手話を主に使用する聴覚障がい者を対象としている.

1.3 これまでの研究成果

これまで筆者らはいくつかの情報保障システムを開発してきており,場所に応じて,屋内と野外で分けて,システムの開発を行ってきた.

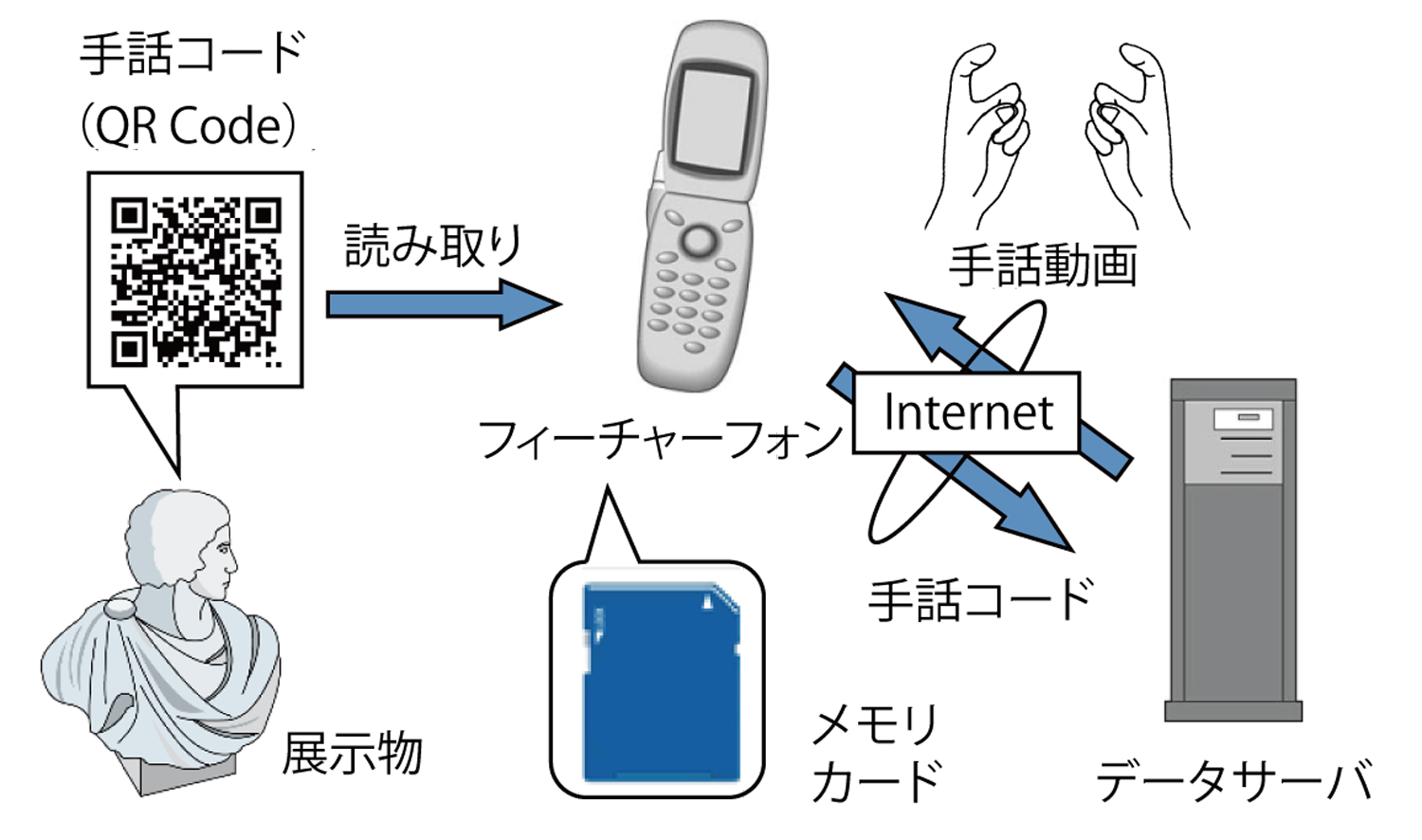

まず筆者らは,屋内向けの手話による情報保障として,フィーチャーフォンの動画配信機能とQRコードを利用したシステムを提案してきた[4],[11],[12],[13].これまでの研究成果で,NTTドコモのiモード用のアプリケーションとコンテンツを作製し,データサーバを構築した.さらに,愛知県豊田市のとよた科学体験館で評価実験を行った.図1にシステム概要図を示す.

このシステムでは展示物のそばにQRコードを貼付し,それをフィーチャーフォンで読み取ることで,その展示物解説の手話動画を内蔵ストレージもしくはインターネットから取得し,見ることができる.

この評価実験でのアンケート結果から,動物園などの場所での情報保障を求める意見を得た.これは野外での使用を意味する.美術館や博物館などの屋内での展示物であれば,展示物の近くにQRコードを掲示すればよい.利用者は見たい展示物に近づくのでQRコードにアクセスすることも容易である.しかし野外の展示物の場合は事情が異なる.大きな展示物の場合,近くまで行かずに遠くから眺めるだけのこともある.また,広い場所に展示物が点々としている野外展示施設の場合は,展示物に近づくルートは決まっていないことが多い.そのため,QRコードの設置場所が悪いと見逃す可能性もある.したがって,野外ではQRコードを用いたシステムでは,不十分であると考えた.

1.4 類似研究

携帯端末を利用した情報保障システムとして,国立民族博物館の「みんぱく電子ガイド[14]」がある.現在運用されているのは,日本語版,英語版,中国語版,韓国語版であり,手話は研究段階で行われた.このシステムは展示物に貼付された番号を入力することで,解説を見ることができる.現在は,iBeaconによる位置推定システムを利用したシステムが研究されている.また,久保らに神戸空港でのユビキタス実証実験の報告がある[15].これは空港内に設置された視覚障がい者誘導用タグ(RFID)を用いて,利用者の位置推定を行い,適切な案内を行うシステムである.この一部に手話による案内が用意されている.これらのシステムは近距離の無線通信を使って,タグから数cm〜数mでの範囲で利用することを目的としている.そのため,野外展示での利用は想定しておらず,適していない.

GPS を利用したシステムがいくつかある.一般に公開されているものとして,Androidアプリである鎌倉手話観光ガイドがある[16].これはGoogleマップと連動して地図上に手話解説のある施設を表示する.利用者は必要に応じて,手話解説を再生することができる.また,位置情報と連動したシステムとして,寺田が開発したシステムがある[17].これらはコンテンツの再利用性を重視したシステムである.そのため,手話を利用する人たちの意見反映や,実利用トライアルからフィードバックを得て,どのような改良を行ったかなどを中心に報告を行った論文ではない.

本稿では,利用者の立場からどのようなシステムが使いやすいかを検証し,本格運用に向けての評価について述べる.

2.システム概要

今回のシステムは,愛知県犬山市にある野外民族博物館リトルワールド[18]を対象とする.図2に示すように一周2.5kmの周遊路に沿って展示物が点々としており[19],地図にある道以外でも自由に移動することができる(図中の展示物はデフォルメされており,実際はもっと小さい).そのため利用者がどのルートから展示物に近づくかが分からない.そこで屋内とは違った,野外に適したシステムを作製する必要があると考えた.

野外展示施設の場合,それぞれの展示物は離れた場所にある.したがって,展示物の位置と利用者の現在位置が分かれば,近くにどの展示物があるかが特定できる.そして,その展示物の解説が手話動画で表示できれば,この問題は解決できると考えた.

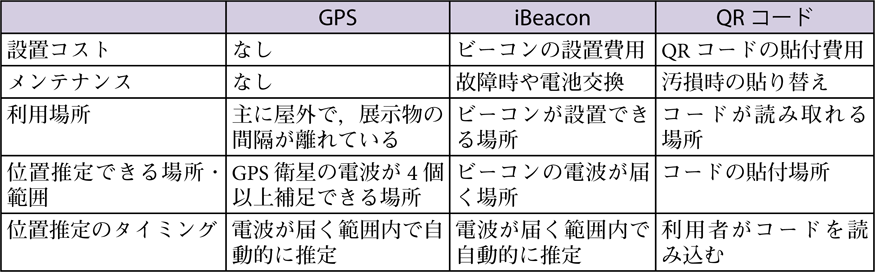

まず,利用者の位置を推定する方法としてGPS,iBeacon,QRコードが挙げられる.これらの位置推定手法の比較を表1に示す.表1に示すようにiBeaconやQRコードを利用する場合,多少なりとも設置コストや手間がかかるが,GPSでは,それもかからないという利点がある.他方で,GPS信号が届かない屋内や展示物同士が近くにある場合などは,GPSよりもQRコードやiBeaconを利用したシステムの方が有効である.ただし,QRコードは,利用者が自発的にQRコードを読み込ませないといけない.iBeaconは,利用者がiBeaconのそばに近づくだけで自動的に起動するというメリットがある.それぞれ,メリット,デメリットがあるため利用状況に合わせて選択する必要がある.

本システムは広大な敷地に展示物が点在しているリトルワールドでの利用を想定しているため,利用者の位置推定としてGPSが有効であると判断し,採用する.

GPSにより利用者の位置を推定し,周辺にある手話解説などのコンテンツが用意されている展示物を画面上に表示する.それを選択することで手話動画を再生する.この機能を持つアプリケーション(以下アプリとする)をスマートフォン上に実装する.

実装したアプリを用いてリトルワールドで評価実験を行った.まず初期バージョンのアプリを作製し,評価実験を行った.その評価をフィードバックして,アプリを改良し,2回目の評価実験を行った.本稿では,これらについて報告する.

今回実装するシステムは,手話を主に使用する聴覚障がい者を対象としているが,ユーザインタフェースは,通知などに音を使っていないことを除けば,一般の利用にも差し支えない.したがって,ここで述べるユーザインタフェースに関する問題は,聴覚障がい者のみならず,一般の健聴者にも言及できることである.ただし視覚障がい者向けのユーザインタフェースは用意していないため,ここでは議論しない.

1.3節で述べたフィーチャーフォンから今回スマートフォンに変えた理由として,GPSはiモード機種の一部にしか実装されておらず,さらに画面が小さく施設の地図を表示しても見にくいという問題がある.逆にスマートフォンでは,画面が大きく,動画もスムースに再生できる.さらに通信速度が上がり,ストリーミングで手話動画を再生することができるということからスマートフォンで実装する.また,iモードで評価実験を行った当時はスマートフォンが普及していなかったという状況でもあった.

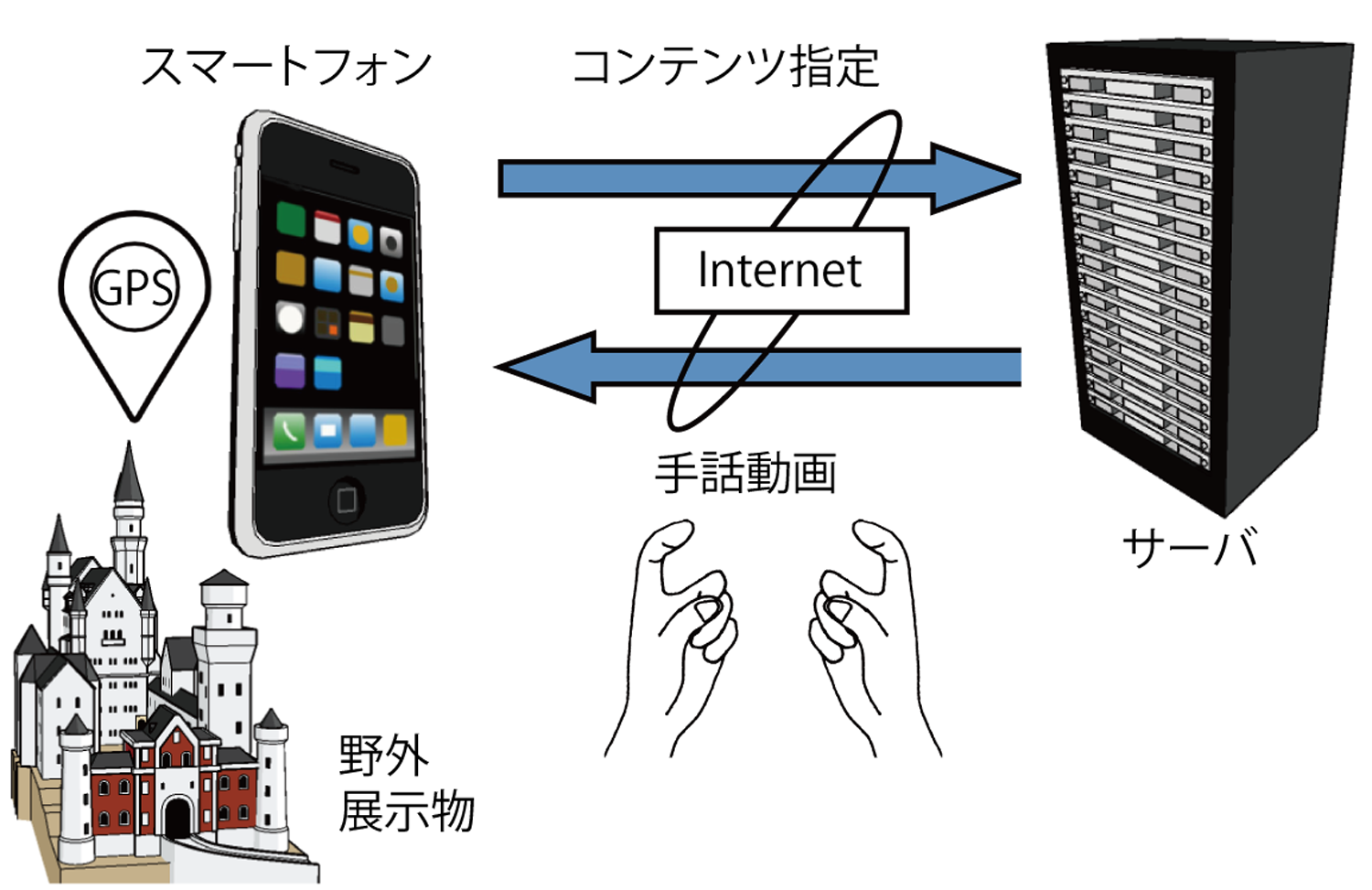

図3に本稿で提案するシステム概要図を示す.また,以下に動作手順を示す.

- 利用者の位置情報を取得し,その位置を地図上に表示する.

- 手話動画解説が用意されている展示物に近づくと,展示物名が書かれた手話動画の再生ボタン(以下再生ボタン)を地図上に表示する.

- 再生ボタンを押すことにより,指定されたコンテンツをインターネットを通じてダウンロードし,手話動画を再生する.

リトルワールドには野外展示施設として33の展示物があるが,本システムでは,そのうちの14の展示物についてコンテンツを用意する.コンテンツがある展示物は地図上にアイコンで表示する.コンテンツを用意していない残りの19の展示物については,利用者の混乱を避けるため地図上には表示しない.これは地図上に展示物のアイコンがあっても,手話解説が表示されないため,システムの不具合と勘違いする恐れがあるためである.

またコンテンツは,展示物のそばにいるときだけ再生できるようになっており,事前に見たり,家に帰ってから復習のために再度見ることはできない.

3.システム実装

本システムはアップル社のiPhone 4を用いて実装する.また,コンテンツの作製方法や利用者の利便性を上げる機能についても述べる.

3.1 位置情報

GPSを用いたアプリの開発にはアップル社が提供するライブラリを使用する.このライブラリでは測定精度を設定することができ,今回は最高精度とする.アプリを使用しているときの位置情報の更新頻度は,利用者が1m移動したときとする.これはアップルから提供されているGPSライブラリは,精度は公表されていないが数m程度とされており,この更新頻度にすることで,最高精度を保てるようにするためである.GPS信号が測定ができない場合は,アプリが利用できないという注意メッセージを表示する.

1) 再生ボタン表示再生ボタンの表示は,展示物を中心とした特定の範囲に利用者が入ったときに表示されるようにする.リトルワールドは広大な土地に点々と展示物が設置されている.そこで,展示物から100m程度の範囲に入ったときに表示することで検討した.この距離であれば展示物が視界に入ってくるので,タイミングとしてはよいであろうと考えた.しかし,展示物の間隔は,長いところで200m以上であるが,短いところで100m弱しか離れていないため,2つの展示物の再生ボタンが同時に表示されることもある.そこで展示物ごとに再生ボタンが表示される範囲を変えることで対応する.展示物ごとに,その位置を中心とした有効範囲(経度と緯度)を定義したテーブルを用意し,その範囲内に入ったときに再生ボタンが表示されるようにする.展示物同士が近い場合は50m程度,離れている場合は100m程度を有効範囲とし,同時に複数の展示物の再生ボタンが表示されないように設定する.

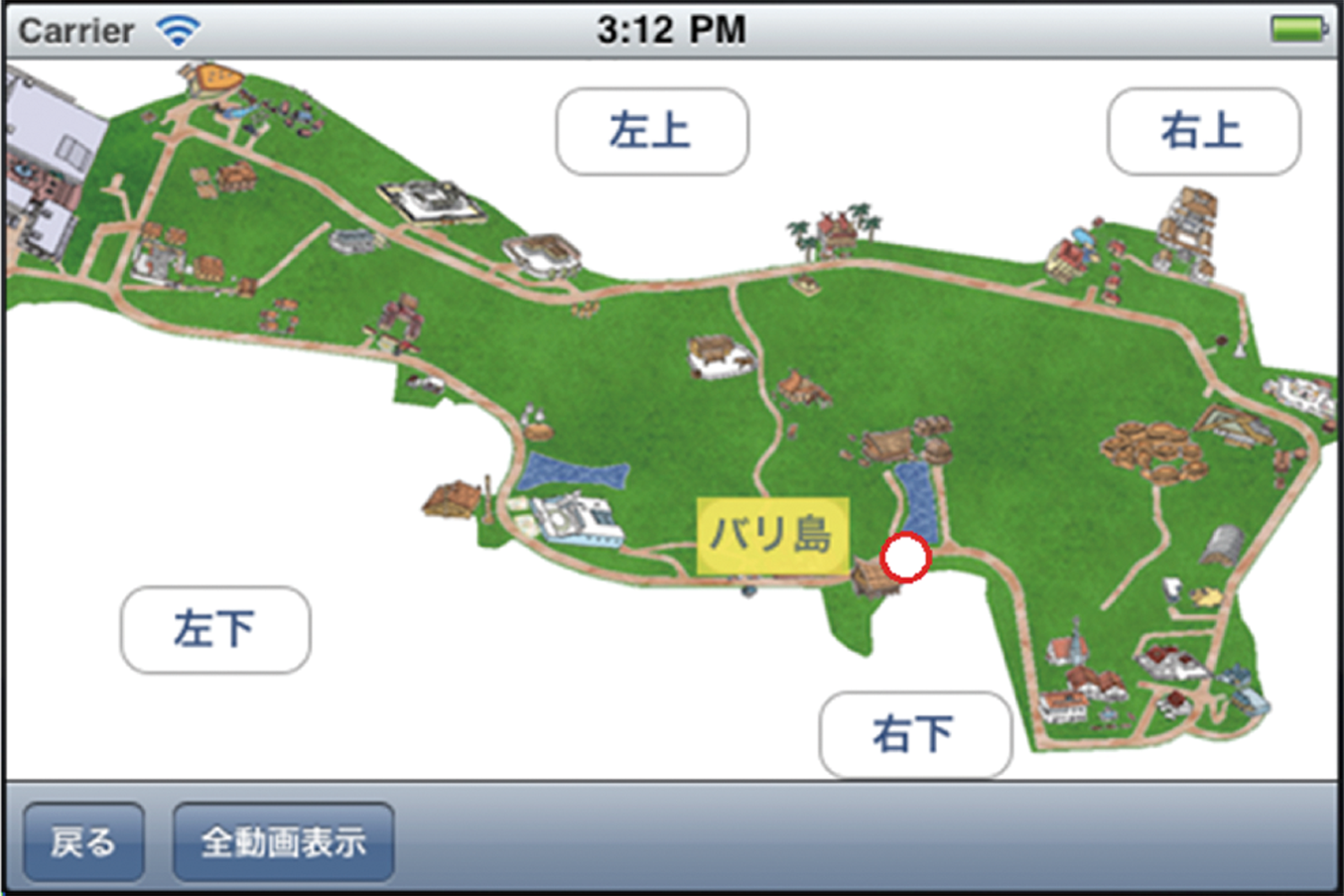

実装したアプリの実行画面を図4に示す.リトルワールドの園内地図に利用者の現在位置(図4内の○)と近くにある展示物(バリ島)の再生ボタンを表示している.

園内地図は拡大できるようになっており,図4内にある「左上」「左下」「右上」「右下」のボタンで,それぞれの区域を拡大表示することができる.

当初は,展示物に近づいたときのみ再生ボタンを表示していたが,1回目の実験を行ったときに,最初からすべての展示物名を表示してほしいという要望があった.そこで利用者の設定に応じて,あらかじめ手話解説のコンテンツが用意されているすべての展示物を表示しておくこともできるようにした.図5にその画面を示す.図中右下付近の○が利用者の現在位置であり,再生ボタンが有効(ボタンの色が異なる)になっているのが「バリ島」であるが,それ以外の展示物もすべて表示されている.

利用者は設定によって図4と図5のどちらかの表示方式を選ぶことができる.

2) 方角表示利用者の向いている方向が分かるように,コンパス機能を用いて方角を表示する.これにより,2つ以上の建物が同時に視界に入っても,利用者が向いている方向が分かるため,展示物の判別ができる.図6にその様子を示す.逆三角形の下の頂点が,利用者の現在位置であり,上の辺が,利用者が向いている方向を示している.

展示物を見逃さないように,再生ボタンが出現したときにバイブレーション機能で通知する.

3.2 コンテンツの作製

ここでは展示物の解説を手話で行う動画コンテンツについて述べる.

今回の評価実験の場所として利用したリトルワールドには,世界の生活や文化に手軽に触れ,学ぶことができ,その素晴らしさを味わうことができる野外展示家屋や世界各地から集めた民族資料がある.ここにある33の野外展示物の中で,特に楽しめると思われる14の展示物を選び,これらについて手話動画による情報保障を行うことにする.

展示物のそばには,図7に示すような看板による簡単な解説がある.今回作製するコンテンツはこの内容よりもう少し詳しくする.

そこでコンテンツの内容は,展示物内やWeb上で配付されている説明書[20]を基に作製する.しかし,この説明書はかなり詳細に書かれているため,これをそのまま手話に翻訳するのは難しく,また,難解であると思われる.そこで筆者が,手話通訳者と手話表現モデルの方と相談しながら,原稿を作製した.方針としては1) 説明書を要約するが,説明看板よりは詳しくする.2) 1つの文は短くする.3) 専門用語は避け,平易な日本語表現とする.4) 1つの動画の時間は1分から2分程度とする.

この原稿を基に手話動画を作製した.文章量や動画の時間については,あまり多いと途中で飽きてしまうこともある.逆に少ないと,説明不足になる.また,展示物によって説明するポイントが異なっている.たとえば石垣島の家は,建物の構造が複雑で,家具や生活習慣などの解説もあり,説明も多くなる.逆にテントのような簡単な構造を持つ展示物もあり,こちらは説明も簡単になる.通訳者とモデルの方と相談しながら,興味がありそうな展示物は詳しく,そうでない展示物は簡単に説明することにした.そのため,展示物ごとに動画の長さが異なる.

作製した14のコンテンツの平均文章量は149文字で,最大は300文字,最小は72文字である.単語数では,平均50単語,最大で80単語,最小で21単語である.手話動画の平均再生時間は1分16秒となり,最も短いコンテンツで50秒,長いコンテンツでは2分5秒となった.ただし,文章量と再生時間は一対一には対応していない.これは書記日本語を手話に翻訳するとき,原稿内の単語が手話単語にあれば,短く表現できるが,固有名詞などの場合は,指文字で1文字ずつ表現しなければならないからである.

また,手話を主に使用する聴覚障がい者に特有な問題として言語(手話)と認知が健聴者と異なることが挙げられる[21],[22].展示物のそばにある解説看板には「この建物は…」といった表現がよく使われる.しかし,「この」という言葉を手話で表すのは簡単ではない.「この」という手話は,その場所を指し示すことで表す.「この建物」であれば,その建物を指さす動作になる.現場で直接会話をしているのであれば,その場所を指し示せばよいが,動画であればどこを指し示せばよいか特定できない.今回は,利用者が展示物に向いている状態でスマートフォンを見ていると仮定し,「この」は後を指し示す動作で対応する.このように空間を使う言語表現を用いる聴覚障がい者にとって,音声言語の日本語による説明では,理解が難しい原因の1つでもある.

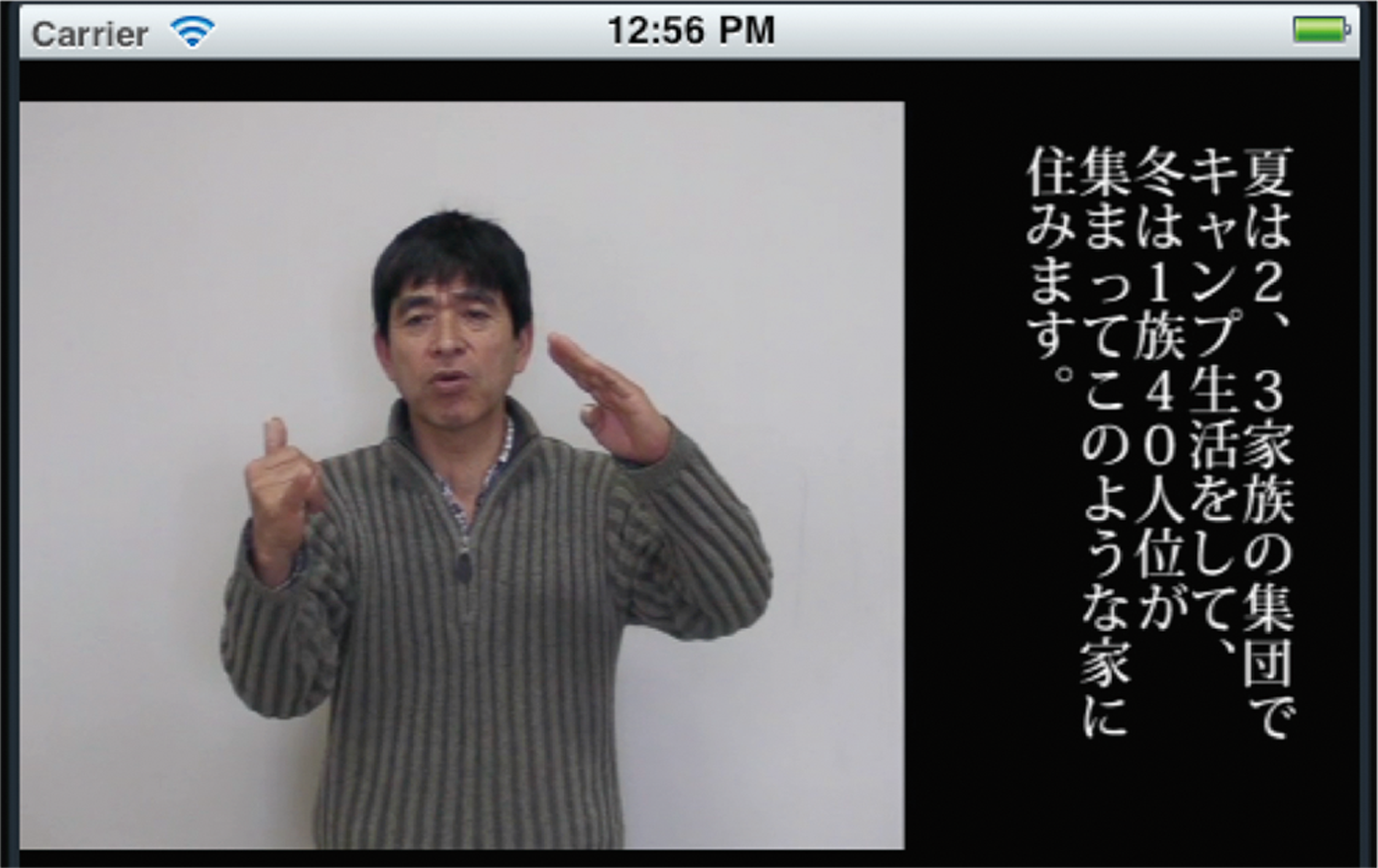

図8に手話動画の再生例を示す.端末上の手話表現者の領域は,約5cm四方の大きさ(画面サイズ:約3インチ,解像度:640×640px)で,右横に字幕を埋め込んだ動画を作製する.字幕の文字の大きさは9pt程度(約40px)である.またフレームレートは29fpsである.過去の研究[23],[24]から画面の解像度がQCIF(176×144px)より高く,フレームレートが10fps以上であれば,手話は十分に読み取れることが分かっている.そのため,今回作製した動画の品質は十分であるといえる.

字幕については,1.3節で述べた先行研究[4]において,字幕付きの解説と手話だけの解説を用意して評価実験を行った.その結果,7割の利用者が手話だけの解説を選んでいた.しかし,残りの3割の人は字幕付きを選んでいる.また,展示物の説明には地名や建物の名前などの固有名詞が多く,指文字表現を多用する部分がある.さらに,利用者によっては,一部の手話表現が理解できないこともある.それらを補助するため字幕も表示し,手話表現と連動させることで理解を助けるようにする.また,難読漢字にはルビを振ることにする.

3.3 そのほかの機能

情報保障とは直接関係ないが,利用者がより便利に使えるように,いくつかの機能を搭載する.

1) ヘルプ機能初めて利用する人に対し,使い方を説明するヘルプ画面を設けることで,少しでも利便性を上げる.

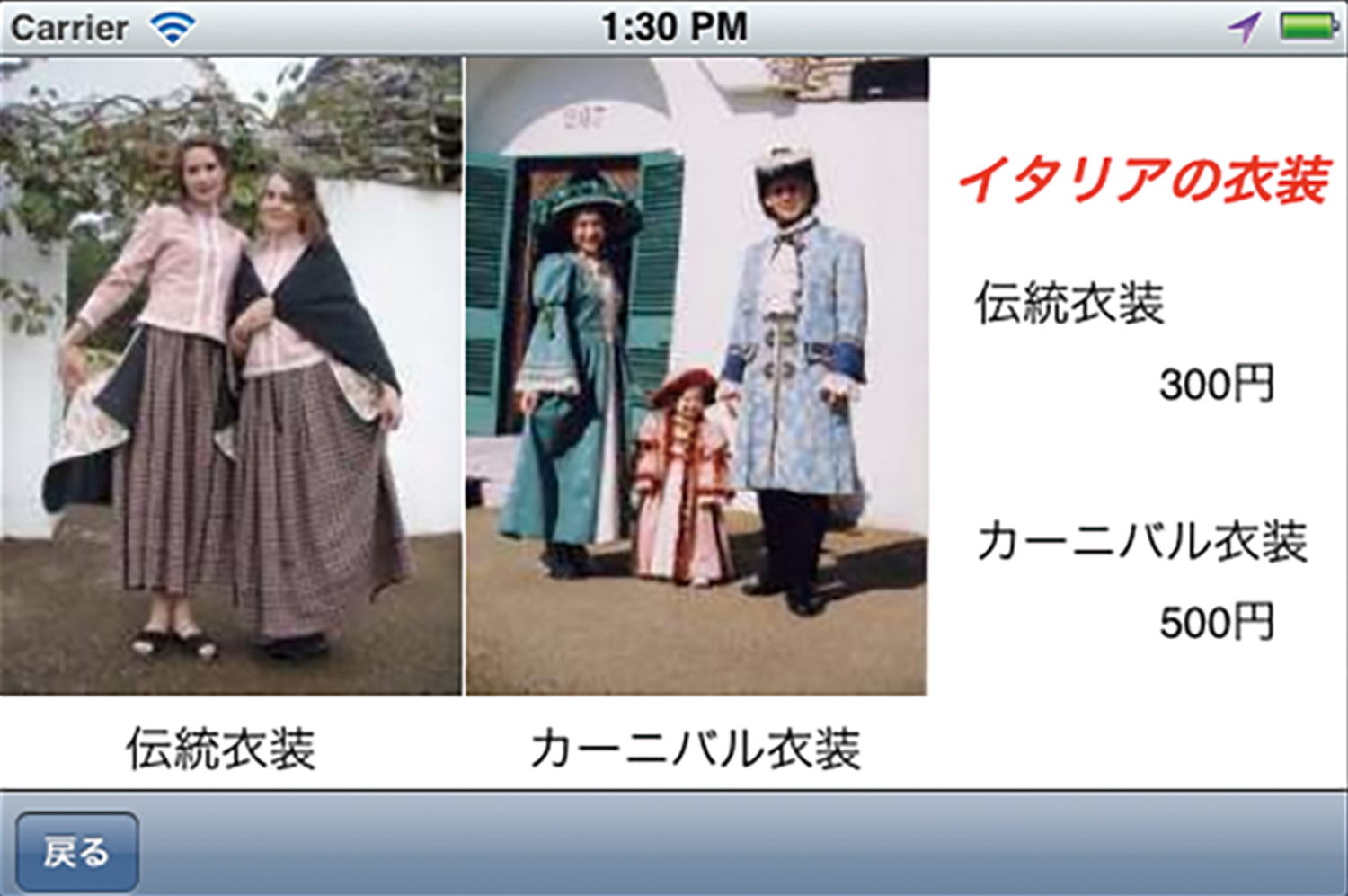

2) 民族衣装体験紹介実験を実施したリトルワールドは,各国の民族衣装が体験できる.展示物の解説だけではなく,このようなイベントを写真と文字で,紹介する機能を追加する.図9に示すように,ここでの案内は項目や料金といった簡単な紹介なので,手話でなくても理解できると考え,手話による説明は行っていない.この機能により利用者がより楽しめるようにする.

4.評価実験

作製したアプリを用いて,実際にリトルワールドで使用してもらい,利用者からアンケートによる評価を得る実験を2回行った.この実験について述べる.

4.1 第1回評価実験

4.1.1 実施方法

1回目の実験の目的は,本アプリがユーザニーズを把握しながら開発を行うという社会実装観点からの開発を行うため,聴覚障がい者の方に評価実験を通してヒアリングを実施することである.今回の実験では,利用者にとって本アプリが有用であるか,また使い勝手がよいかを検証する.さらに問題点を洗い出して,次のバージョンに反映させることを目的とする.さらに実際にサービスを運用したときの意見収集も同時に行う.

ここでのアプリは,第3章の「システム実装」で述べた機能のうち,全展示物表示,方向表示,バイブレーション機能,その他の機能(ヘルプ・衣装体験)が実装されていないバージョンである.

リトルワールドで実施した1回目の評価実験[25]では,手話を主に使用している聴覚障がい者15名に参加してもらい,アンケート調査を行った.

参加者の年齢層および性別は,60代4名(男1名,女3名),50代7名(男5名,女2名),40代2名(女),10代2名(女)であった.日常的に使用している通信機器は,スマートフォンが4名,フィーチャーフォンが11名であった.

実験は,まず参加者に実験の趣旨とアプリの使い方を全員に説明した.このとき,倫理上に配慮して,実験の最後でアンケートに回答した内容は統計的に扱われ個人が特定されることがないことを説明し,同意してもらった方のみ実験に参加してもらった.

その後,園内に移動して参加者が各自でアプリを操作し,各展示物の解説を見た後に,その展示物を実際に観覧してもらう.そして,すべての展示物を見終わった後に用意したアンケートに答えてもらうという方法で行った.図10に実験説明時の様子を,図11に園内での実験の様子を示す.

4.1.2 評価実験結果

実験終了後にこのアプリについてのアンケートを実施した.この結果について述べる.

1)このアプリのアイディア(現在位置表示とその周辺展示物の手話による解説)について- よい:40.0%

- まあまあよい:60.0%

- あまりよくない:0.0%

- よくない:0.0%

- ちょうどよい:93.3%

- 小さい:6.7%

- 大きい:0.0%

- ちょうどよい:86.7%

- 小さい:13.3%

- 大きい:0.0%

- 初めからすべて表示:20.0%

- 近づいたときに表示:26.7%

- 必要に応じて使い分ける:26.7%

- どちらでもよい:26.7%

- 必要である:53.3%

- やや必要は感じる:40.0%

- あまり必要はない:6.7%

- 必要ない:0.0%

- とても使いやすい:33.3%

- 使いやすい:53.3%

- やや使いにくい:13.3%

- 使いにくい:0.0%

また,このアプリに対する自由意見として以下のような回答を得た.

- 現在位置が分かるのがよい.

- これまでは分からなかったことがあると,ただ見ているだけだったが,このアプリがあると由来などを知った上で見ることができたので,いつもと違い,面白かった.

- タッチパネルの反応があまりよくなかったので,専用のペンなどがあるとよい.

- どこに展示物があるか把握できるようにすべての再生ボタンの表示があるとよい.

4.2 第2回評価実験

4.2.1 実施方法

2回目の実験の目的は,前回からの改良点を評価することで,実際の運用時に問題点がないか明らかにすることである.さらにもっと必要な機能についても意見をもらう.

2回目の実験では,1回目に使用したアプリに1) 全展示物表示,2) 方向表示,3) バイブレーション機能,4) その他の機能(ヘルプ・衣装体験)を加えたアプリを使用する.

2回目の評価実験も前回と同様にリトルワールドで行い,手話を主に使用している聴覚障がい者5名から評価を得た[26].参加者のうち,3名は,前回の評価実験にも参加していた.年齢層および性別は,40代1名(女),10代4名(男女各2名)であった.

4.2.2 評価実験結果

実験終了後にアンケートでの評価を実施した.2回目は1回目の実験とは異なり少人数のため,統計的に扱っても個人が特定される恐れがあった.そのためアンケート結果は匿名情報として扱うことを誓約するとともに,統計情報のみ研究活動に活用することを説明し,同意してもらった方のみ実験に参加してもらった.この実験結果について述べる.

1)「使い方」画面の説明を読むことでアプリの使い方を理解できたか- 理解できた:100.0%

- やや理解できた:0.0%

- あまり理解できなかった:0.0%

- 理解できなかった:0.0%

- 役に立った:80.0%

- やや役に立った:0.0%

- あまり役に立たなかった:0.0%

- 役に立たなかった:20.0%

- 始めからすべて表示:60.0%

- 近づいたときに表示:20.0%

- 必要に応じて使い分ける:20.0%

- どちらでもよい:0.0%

- ある方がよい:60.0%

- どちらでもよい:20.0%

- なくてよい:20.0%

5.考察

5.1 第1回評価実験

1回目の評価実験でのアンケート結果について考察する.今回の評価実験では手話を主に使用する聴覚障がい者を対象として行ったが,下記の3),4)の操作性に関しては,聴覚障がい者特有ではなく,一般的な評価になると思われる.

1)アプリの有用性に関してアプリそのものに関しては,情報保障を行うという観点から見てもおおむね良好であるということはある程度予想でき,結果もその通りであった.

2)手話動画コンテンツについて手話表現者の大きさ,字幕文字の大きさはともに,今回採用した大きさ(動画約5cm四方,字幕約9pt)で十分であると考えられるが,小さいと感じた人もいる.大きい場合は我慢できるが,小さいと見にくくストレスを感じてしまう.

3)再生ボタン表示方法について再生ボタン表示方法について,アンケートの回答にばらつきが見られた.1回目の評価実験で用いたアプリでは,現在位置の近くにある展示物のみを画面上に表示する方法を採用した.しかし,この方法では歩きながら画面を常にチェックする必要があり,画面のチェックを忘れてしまうと,手話動画による解説がある展示物を見逃してしまうといった欠点もある.このことから,手話動画による解説がある展示物がどこにあるのか分かるように,手話解説がある展示物を始めからすべて表示する方法がよいと答える参加者が多く見られたと考えられる.この結果を踏まえ,2回目の実験では,利用者が自由に選択できるようにした.

4)アプリの使いやすさについてアンケート結果から,「とても使いやすい」と「使いやすい」で90%近く占めている.特にフィーチャーフォン使用者11名のうち,5名が「とても使いやすい」,4名が「使いやすい」と回答している.逆にスマートフォン使用者4名のうち,3名が「使いやすい」,残り1名が「やや使いにくい」と回答している.サンプル数が少ないのではっきりとはいえないが,フィーチャーフォン使用者からすれば,タッチパネルで直感的に使えるアプリがとても便利に思えたのであろう.逆にスマートフォン使用者から見れば,それほど目新しくもなかったのではないかと考えられる.

5.2 第2回評価実験

2回目の評価実験は,主に1回目から追加した機能の有効性の確認を中心に行った.ここでの評価は操作性に関する機能に対してであるため,特に聴覚障がい者特有の評価とは限らない.

1)バイブレーション機能再生ボタン出現を知らせるバイブレーション機能について,役に立たないことはないであろうと考えていたが,1名だけ役に立たないと答えていた.その理由として,バイブレーションが再生ボタン出現の合図であることを理解していなかったということであった.利用方法をしっかり理解してもらうようにしなければならない.

2)コンパス機能コンパス機能についても,あるとよいという回答が多かった.理由として利用者が向いている方向が分かるというのを挙げていた.どちらでもないという回答の理由は,初めての人にはよいということであった.この回答者は前回の評価実験にも参加しており,建物の場所をある程度覚えているため,コンパスは不要であるが,初めての人は,有益であると考えたようである.リトルワールドには展示物が密集して,出現している再生ボタンがどの展示物に対応しているのか分かりにくい場所がある.そのため,自分の向いている方向が分かることで,再生ボタンがどの展示物に対応しているか分かりやすいためだと思われる.

3)再生ボタンの表示方法について再生ボタンを表示するタイミングについては,「始めからすべて表示する」を選んだ人が多かった.今回は参加人数が少ないこともあり,ぶれは大きいため,一概にこれがよいとはいえないが,筆者の意見としては,現在位置近くの展示物のみ端末の画面上に示した方が,再生させる動画を探す必要がなくてよいのではないかと考えていた.しかし1回目の実験でも,多くの人から始めからすべて表示してほしいという意見を得ていた.この理由としては,現在位置周辺の展示物よりもすべての展示物がどのように配置されているかのほうに関心が集まったためではないかと考えられる.

4)1回目の評価実験との比較1回目の評価実験アンケートの設問,「1) このアプリのアイディアについて」において,「アイディアはよい」と回答しながら,「5) このアプリの必要性は感じられるか」では,「あまり必要ない」と回答した人が1名いた.その理由として位置情報が分かり,手話で解説しているのはよいとしながらも,無料のパンフレットがあるのなら,そちらを使うので必要ないということであった.この回答者は書記日本語が不自由なく使用できるようである.

この回答者は2回目の評価実験にも参加しており,追跡調査をしたところ,必要性に関して,「やや必要」と変わっていた.これは多くの情報(衣装体験紹介など)が入っているからというのが,その理由であった.

手話を主に使用する聴覚障がい者の方であっても,同時に,書記日本語に精通している人にとっては,無料で手に入る説明書を要約して手話に翻訳しても,あまり魅力がないと思われる.基本的な解説に加え,無料の説明書には書かれていない情報などのより付加価値の高いコンテンツも用意した方がよいと思われる.

6.今後の課題

今回の実験では,定量的評価の充実度には課題がある.たとえば画面上に再生ボタンが表示されてから,利用者が手話動画を見始める時間や終わる時間など,どのようなタイミングで操作したのか.操作手順の間違いはないか.手話または字幕を見ていた時間の測定などの評価が行えなかった.これらを測定できる仕組みを組み込み,操作性についての評価をする必要がある.

また,画面の大きさについてであるが,利用者によって,動画や字幕の大きさを大きく感じたり,小さく感じたりする.利用者が自由に変更できるようになるとよい.今回のコンテンツでは,手話動画に文字を埋め込んで作製した.これを手話動画とテキストを別に用意し,テレビの字幕放送のように,重ね合わせるようにすれば,文字の大きさを自由に変更できると考える.

次に再生ボタンの出現方法についてである.結果から現在位置周辺の展示物よりもすべての展示物がどのように配置されているかの方に関心が集まっていると考えられる.あらかじめすべての展示物名を地図に埋め込んでおき,現在位置周辺に手話解説が用意された展示物がある場合に,再生ボタンを出現させるのがよいであろう.ただしこの場合,すべての展示物に手話解説のコンテンツを用意するか,用意できない場合は,展示物ごとにコンテンツの有無が分かるようにしないと利用者が混乱する恐れがある.たとえば手話コンテンツがある展示物には,手の形のアイコンを付けるなどの工夫が必要となる.

今回作製したアプリでは,展示物の付近にいるときのみに手話解説が再生できるようになっており,それ以外では見ることができない.そのため,あらかじめ見たい展示物について知りたい,家に帰ってからもう一度詳しく知りたいといった要求に対応できていない.利用者が好きなときに自由に手話解説を見ることができる仕組みが必要である.

また用意するコンテンツであるが,いくつかの階層に分けるのがよいと思われる.最初に基本的な説明をする手話動画を再生する.さらに詳しく知りたい人のために詳細な説明をする手話動画を用意し,利用者が自由に選べるようにするのである.これにより利用者の好みに応じて,解説を見ることができる.

さらに,QRコードが貼付できない,あるいは暗くて読み取れなく,かつGPS電波が届かないような場所(たとえば水族館などの暗く,建物内の場所)では,「トーハクなび[27]」のようなiBeaconによる位置推定システムを利用したシステムの構築を検討する.リトルワールドには本館屋内にも展示室があり,ここでの手話解説ができていない.屋内と野外の情報保障がシームレスに行えるようなシステムを開発する必要がある.

今回は聴覚障がい者向けということで,再生ボタン出現などの通知はバイブレーションのみとしたが,健常者の場合は,音や光で通知する機能も搭載すべきであると考える.

実際に公式アプリとして提供するには,バスの時刻表やリトルワールド内で食べられる「世界の料理」の紹介など,一般の人にも役に立つようなコンテンツを増やしていくとよいと思われる.

7.おわりに

本稿では,手話を主に使用する聴覚障がい者向けに,手話による情報保障を行うシステムについて紹介した.評価結果から,このGPSを利用した本システムは有効であると考えられる.評価実験ではスタッフが手分けして,いくつかのグループと行動を共にしていた.手話解説の利用状況を見ると,展示物の全景を見ながら解説を見て,展示物の内部に入るという使い方をしている人が多かった.これは本アプリが建物から50m〜100m程度の離れたところから手話解説を見ることができるためである.QRコードや電波範囲が狭いiBeaconではできない使い方である.

今回は,特定の施設での実験であったが,アンケートから京都や東京といった観光地での要望も多い.GPSとマップをうまく利用し,利用者の状況(障がいの有無や種類)に合わせて楽しめるモデルコースを設定するなど,いろいろな拡張が考えられる.

手話による情報保障は,本稿で提案したシステムだけでなく,あらゆる時と場所,さまざまな方法で提供する必要があると考える.しかし,これを実現するためには,まず手話コンテンツを作成しなければならない.手話コンテンツを作成するにはコストと時間がかかるため,これらを抑える必要がある.1つの案として,コンテンツの共用化が挙げられる.たとえば水族館や動物園などは,展示物が同じ動植物であることが多く,共用することが可能である.しかし,展示物が施設ごとに異なる美術館・博物館,あるいは観光案内などでは共用が難しいのが問題である.

コンテンツ作成のガイドラインや文章を入力すれば自動的に手話動画が作成できるツールなどの開発と公開が望まれる.

今回は手話を主に使用する人々への情報保障による支援システムを構築した.障がいは個人によって異なり,支援システムはそれぞれの障がいに合わせて研究・開発される.たとえそれがたった1人のためであっても,その人には非常に有益であり,我々はそれを排除することはしない.それらの積み重ねが,最終的には,あらゆる障がい,あらゆる人々を支援するシステムを構築することになると考えているからである.

平成28年4月から「障害者差別解消法」が施行された.この法律では,障がいのある人には合理的配慮をしなければならないとされている.本稿は,今回作製したシステムの評価だけでなく,障がい者支援システムを構築する上でも指針となると思われ,少しでも役立てるのではないかと考える.障がい者支援システムを構築することで,障がい者に限らずあらゆる人が文化に触れあう機会が増えることを期待している.

謝辞 評価実験に協力していただいた野外民族博物館リトルワールドに感謝いたします.また,本研究の一部は,JSPS科研費23300215,26560318,23242022,15K12875の助成を受けたものです.

参考文献

- 1)阿部敬信:聴覚障害教育における日本手話・日本語バイリンガル教育に関する研究,明星大学大学院人文学研究科教育学専攻 博士論文 (2014).

- 2)我妻敏博:聴覚障害児の文理解能力に関する研究の動向,特殊教育学研究 38 (1),pp.85-90 (2000).

- 3) 田中耕司,斎藤佐和,四日市章:聴覚障害児の読書力の構造的特徴に関する研究 : 言語能力からの検討,特殊教育学研究 44 (6),pp.473-492 (2007).

- 4)木村 勉,高橋小百合,神田和幸,原 大介,森本一成:携帯電話を利用した聴覚障がい者向け情報保障システムの構築と評価,手話学研究,第20巻,pp.45-65 (2012).

- 5)市田泰弘,難波友加,伏原桃子,三宅三枝子,吉井美樹:日本手話母語話者人口推計の試み,日本手話学会第27回大会予稿集,pp.42-45, 日本手話学会 (2001).

- 6)神田和幸,原 大介,木村 勉:日本の聾者人口の推計,日本手話学会第34回大会予稿集,pp.17-20, 日本手話学会 (2008).

- 7)平成13年身体障害児・者実態調査結果,厚生労働省,http://www.mhlw.go.jp/houdou/2002/08/h0808-2.html(2016年6月20日現在)

- 8)障がいのある方々のインターネット等の利用に関する調査研究,総務省,http://www.soumu.go.jp/iicp/chousakenkyu/data/research/survey/telecom/2012/disabilities2012.pdf(2016年4月9日現在)

- 9)移動体通信(携帯電話・PHS)の年度別人口普及率と契約数の推移,総務省,http://www.soumu.go.jp/soutsu/tokai/tool/tokeisiryo/idoutai_nenbetu.html(2016年4月9日現在)

- 10) 森本一成,神田和幸,荒木雅弘,木村 勉,他:総合プロセーシス学の諸相,ユニオンプレス (2014).

- 11) Kanda, K., Kimura, T. and Hara, D. : A Proposal of the Universal Sign Code, ICCHP 2006, pp.595-598, Linz, Austria, (2006).

- 12) Kimura, T., Katoh, M. and Hayashi, A., et al. : Application System of the Universal Sign Code - Development of the Portable Sign Presenter -, ICCHP 2008, pp.678-681, Linz, Austria (2008).

- 13)高橋小百合,木村 勉,神田和幸:携帯電話を利用した聴覚障がい者向け情報保障システムの構築と評価,電子情報通信学会技術研究報告,WIT,福祉情報工学 110 (53),pp.49-54 (2010).

- 14)国立民族学博物館「展示場マップ」,http://www.minpaku.ac.jp/museum/exhibition/main/map(2015年8月25日現在)

- 15)久保伸治,他:ユビキタスサービスの実現に向けて〜神戸空港ユビキタス実証実験への参画〜,https://www.oki.com/jp/Home/JIS/Books/KENKAI/n209/pdf/209_R02.pdf(2015年8月25日現在)

- 16)日本初,手話による観光案内アプリの配信開始〜Android 端末向け,鎌倉市世界遺産版をリリース〜,http://shur.jp/shur_release20120214.pdf(2015年8月25日現在)

- 17)寺田 努:コンテンツの再利用性を考慮したナビゲーションシステムの開発と実運用,ヒューマンインタフェース学会論文誌14 (1-4),pp.111-120 (2012).

- 18)野外民族博物館リトルワールド,http://www.littleworld.jp/(2016年4月9日現在)

- 19)野外民族博物館リトルワールド 園内マップ,http://www.littleworld.jp/map/(2016年4月9日現在)

- 20)インフォメーション(家屋解説),http://www.littleworld.jp/doc/guide_yagai.pdf(2016年4月17日現在)

- 21)神田和幸:手話の言語的特性に関する研究 手話電子化辞書のアーキテクチャ,福村出版 (2010).

- 22)神田和幸,原 大介,谷 千春,植村英晴,長嶋祐二,木村 勉:基礎から学ぶ手話学,福村出版 (2009).

- 23)中園 薫,柳橋史織,長嶋祐二,市川 熹:ディジタル符号化された手話動画像の品質評価について,電子情報通信学会論文誌 D, Vol.J89-D No.3, pp.541-551 (2006).

- 24)塩野目剛亮,鎌田一雄,山本英雄,スーザン フィッシャー:画面大きさと手話知覚との関係に関する検討,ヒューマンインタフェース学会論文誌,Vol.9, No.2, pp.87-96 (2007).

- 25)高橋小百合,木村 勉,神田和幸,他:携帯情報端末を用いた聴覚障がい者向け情報保障システムの構築と評価,電子情報通信学会技術研究報告,WIT,福祉情報工学 111 (58),pp.25-28 (2011).

- 26)木村 勉,高橋小百合,神田和幸,他:スマートフォンを用いた聴覚障がい者向け情報保障システムの構築と評価,第4回福祉情報教育フォーラム論文集,pp.43-44 (2013).

- 27)国立東京博物館:「トーハクなび」について,http://www.tnm.jp/modules/r_free_page/index.php?id=1467(2015年8月25日現在)

1990年豊橋技術科学大学大学院情報工学専攻修士課程修了.同年,豊田工業高等専門学校情報工学科助手.2011年同学科准教授,現在に至る.博士(学術).福祉工学,障がい者支援,手話工学の研究に従事.電子情報通信学会,ヒューマンインタフェース学会,日本福祉のまちづくり学会,観光情報学会正会員.

高橋 小百合(非会員)2012年豊田工業高等専門学校専攻科情報科学専攻修了.同年パナソニックシステムソリューションズジャパン(株),2013年パナソニック システムネットワークス(株)(社名変更).現在に至る.学士(工学).

神田 和幸(非会員)1976年青山学院大学文学研究科博士課程修了.博士(学術).手話の言語学的研究に従事.現在,京都工芸繊維大学研究員,中京大学名誉教授.電子情報通信学会正会員.

採録決定:2016年8月3日

編集担当:西 直樹(NEC)